别让“松鼠症”拖了后腿,背后其实是“知识便秘”!

快来看看你的电脑、网盘或者 Notion,感觉怎么样:

- 是不是下载了成百上千本 PDF 技术书,结果只翻了个目录?

- 是不是储存了无数“干货”文章,想着“总有一天会用到”,最后却再也没打开过?

- 那些工作多年的项目文档、会议记录堆得像小山,想找个决策的细节,却怎么也找不到?

其实,我们的大脑更擅长思考,而不是存储信息。

强迫大脑记住几千个文件的内容,真的是太不人道了。

ChatGPT虽然厉害,但也有它的短板:

- 它不了解你的私人事务:虽然它看过很多互联网信息,但并没有读过你的日记、私密代码库或者公司的财报。

- 隐私泄露风险:你敢把公司的机密文件直接发给公有云的 AI 吗?(这可要小心被开除哦)

今天,我想带大家用 Python 和 RAG(检索增强生成)技术,把这些“沉睡的数据”喂给 AI,打造一个完全属于你的Private Agent(私有知识助理)。

核心原理:给 AI 来个“开卷考试”

那么,什么是RAG (Retrieval-Augmented Generation)呢?

简单来说,就是 AI 在回答你问题之前,先去你的“私人图书馆”查找资料,找到了答案再整理给你。

流程很简单:

- 切片 (Chunking):把你的 100 页 PDF 切成一个个小段落。

- 向量化 (Embedding):把这些段落转化为计算机能够识别的数字坐标,存入向量数据库(Vector DB)。

- 检索 (Retrieval):当你提问时,系统会计算出问题的坐标,然后去数据库中找出“最近的”段落。

- 生成 (Generation):将找到的段落和你的问题一起提交给大模型:“请根据这些资料回答用户的问题。”

️ 极速实操:15分钟搭建你的“贾维斯”

这次我们依旧使用 Python 的瑞士军刀。

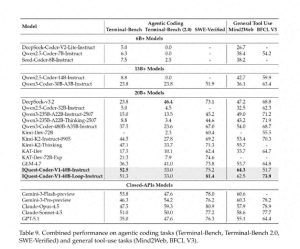

为了演示的极致体验,我们将使用LangChain隐私保护Ollama(运行本地模型,如 Llama 3 或 DeepSeek-Coder),这样数据就不会出本地,无需联网,也不用花钱。

1. 环境准备

你需要先安装 Ollama(官网下载,简单易用),然后拉取一个模型:

ollama pull llama3

接着安装 Python 库:

pip install langchain langchain-community langchain-chroma pypdf sentence-transformers

2. 核心代码:五步构建你的第二大脑

新建文件:brain.py

轻松打造你的智能知识助手

import os

from langchain_community.document_loaders import DirectoryLoader, PyPDFLoader, TextLoader

from langchain_text_splitters import RecursiveCharacterTextSplitter

from langchain_community.embeddings import HuggingFaceEmbeddings

from langchain_chroma import Chroma

from langchain_community.llms import Ollama

from langchain.chains import RetrievalQA

# --- 1. 加载知识库 ---

# 假设你有个文件夹叫 'my_data',里面全是 PDF 和 TXT 文件

print(" 正在读取知识库...")

loader = DirectoryLoader('./my_data', glob="**/*.pdf", loader_cls=PyPDFLoader)

docs = loader.load()

print(f"✅ 成功加载了 {len(docs)} 个文档页。")

# --- 2. 文本切片 ---

# 就像我们不能一口气吃太多,AI 也需要把内容分段来消化。

text_splitter = RecursiveCharacterTextSplitter(

chunk_size=1000, # 每块 1000 个字符

chunk_overlap=200 # 重叠 200 字,确保上下文流畅

)

splits = text_splitter.split_documents(docs)

print(f" 文档已被切分为 {len(splits)} 个部分。")

# --- 3. 向量存储 ---

# 这里我们使用一个本地的开源嵌入模型,不需要 API Key

print(" 正在将数据存入向量数据库 (Chroma)...")

embedding_function = HuggingFaceEmbeddings(model_name="all-MiniLM-L6-v2")

# 创建或加载向量数据库

vectorstore = Chroma.from_documents(

documents=splits,

embedding=embedding_function,

persist_directory="./chroma_db"

)

print(" 记忆存储完成!")

# --- 4. 设置 AI 大脑 ---

# 连接本地的 Ollama (Llama3)

llm = Ollama(model="llama3")

# 构建问答链 (RAG Chain)

qa_chain = RetrievalQA.from_chain_type(

llm=llm,

retriever=vectorstore.as_retriever(search_kwargs={"k": 3}), # 每次只返回最相关的3段

return_source_documents=True # 返回答案的出处

)

# --- 5. 开始互动 ---

if __name__ == "__main__":

print("n 贾维斯已上线。请问你想了解什么?(输入 'q' 退出):")

while True:

query = input("n用户: ")

if query.lower() == 'q':

break

# AI 开始思考

result = qa_chain.invoke({"query": query})

print(f"nAI: {result['result']}")

print("n--- 引用来源 ---")

for doc in result['source_documents']:

print(f" {doc.metadata['source']} (第 {doc.metadata.get('page', 0)} 页)")

3. 实际效果

假设你在my_data 文件夹中放了一份《2025年公司年会策划案.pdf》。

用户: 年会的预算是多少?

AI: 根据策划案,2025年年会的总预算是 50 万元。其中场地费 20 万,餐饮 15 万,奖品 10 万,备用金 5 万。

— 引用来源 —

my_data/2025年公司年会策划案.pdf (第 4 页)

进阶玩法:不止是搜索

有些朋友可能会问:“用 Ctrl+F 不是也能找到内容吗?那这有什么用?”

思路太狭隘了!

Ctrl+F 只能寻找关键词,而RAG Agent能够理解语义和逻辑推理。

场景一:跨文档比较

- 你问:“A 项目和 B 项目的技术栈有什么不同?”

- 代理人:它会同时查看《A项目文档》和《B项目文档》,提取相关段落,并为你提供一份对比表。这是 Ctrl+F 做不到的。

场景二:代码助手

- 把你写的几万行“屎山代码”交给它。

- 你问:“帮我写一个新功能,风格要和现在的 user_login 模块一致。”

- 代理人:它会模仿你以前的编码风格来编写新代码。

场景三:个人日记洞察

- 把你十年的日记给它。

- 你问:“过去五年,我通常在哪几个月情绪最低?”

- 代理人:它能分析你的文字内容,识别情绪趋势,充当你的心理顾问。

️ 为什么“私有化”对我们如此重要?

在2026年的今天,数据已经成为一种重要的资产。

当你把数据输入给 ChatGPT 或 Claude,其实是在用自己的知识来训练别人的模型。

而本地 RAG Agent带来了这样的保证:

- 离线也能使用:无论是在飞机上,还是在偏远山区,你的“第二大脑”都能正常运作。

- 绝对隐私:你的商业机密、私人日记,将始终保存在你的硬盘上,连马斯克也无法窃取。

结论:如何获取AI代理学习资料{转发关注+私信【资料】}

在这个AI蓬勃发展的时代,

搭建这个代理只需掌握一点Python,耗时不超过一顿饭的时间。但这将为你带来从“被信息淹没”到“掌控信息”的巨大转变。

掌握信息并不算优势,能够灵活调用信息才是真正的优势。

利用Python和RAG技术构建私人知识助理的思路真的很新颖,解决了我长期以来在信息整理上的困扰,期待尝试一下这个方法!

通过RAG技术来管理个人知识,确实是个不错的主意,这样可以有效避免信息过载带来的困扰,让我重新审视自己的资料整理方式。

用Python和RAG技术打造自己的知识助理,真是个好主意!能把杂乱的资料变得有序,期待能提升我的工作效率。

打造私人知识助理的思路非常实用,尤其是能把大量资料变得条理清晰,真的很期待试试这个方法!

文章中提到的RAG技术真是一个聪明的解决方案,能帮助我更好地管理和利用那些沉睡的资料,非常期待能通过这个方法提升我的记忆与学习效率!

将沉睡的数据转化为有用的信息,真是个好思路!期待通过RAG技术能让我的知识管理更高效,告别杂乱无章。