金磊 发自 凹非寺

量子位 | 公众号 QbitAI

在2025年的最后几天,TRAE发布了一个引人注目的年度产品报告。

里面有一组让人惊艳的数据:

TRAE在过去一年里居然写了1000亿行代码!

这到底有多夸张呢?

假设一个程序员每天写100行有效代码,这就意味着300万个程序员连轴转,没日没夜地干了一整年。

不过这只是《TRAE 2025年度产品报告》中一些冰山一角,更多的有趣数据还有:

- 超过50%的用户,每天都在频繁使用Tab键(Cue行间补全功能)

- 全球用户数超过600万,月活跃用户突破160万,覆盖近200个国家和地区

- 仅仅半年,Token消耗量暴涨700%

- 有6000名“肝帝”用户,全年写代码超过200天

- 国际版付费用户周均活跃超过6天,几乎全勤

- ……

数据是不会说谎的。

当大家在讨论AI是否会取代程序员时,TRAE已经悄悄在中国AI IDE的赛道上跑出了领先地位。

这份报告,揭示了TRAE在AI编程领域飞速发展的秘密。

谁在使用,怎么使用?

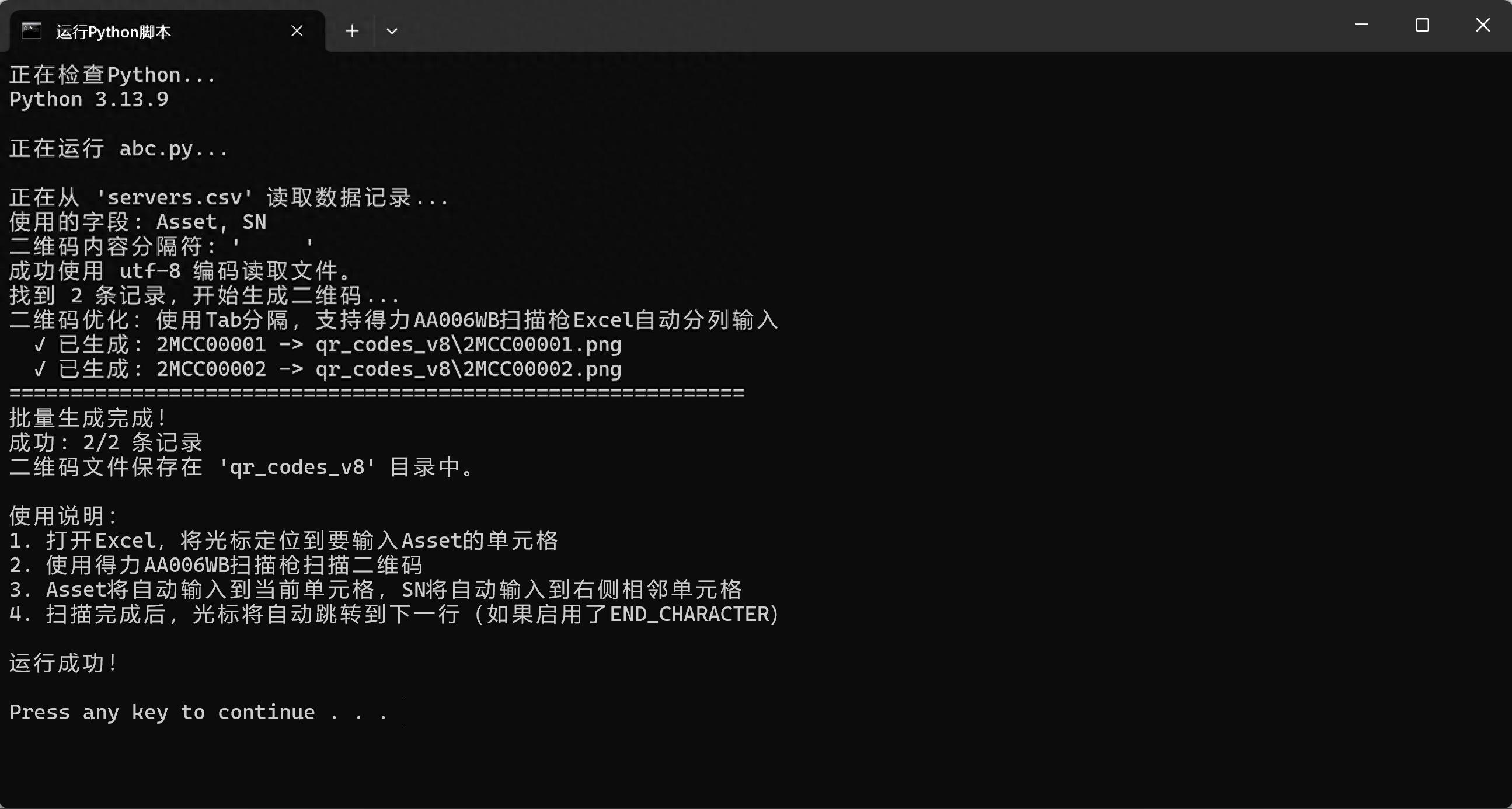

在深入技术细节之前,我们先来看看一个非常真实的现象。

如果你的开发环境里装了TRAE,你可能已经习惯了这样一个操作:

你手指悬在Tab键上的时间,远比其他键位要久。

报告显示,Cue(行间补全)功能已经成为程序员们最常用的肌肉记忆。

- 超过50%的用户每天主动使用Cue

- Cue累计推荐代码近10亿次,采纳率提升了80%

这意味着什么呢?

在互联网产品的开发方法中,有一个非常著名的50%渗透率拐点:当一项AI功能的使用率超过50%,并且保持高活跃度时,就标志着整个行业已经跨越了从尝鲜到实用工具的阶段,进入了人机共生的新时代。

AI不再是偶尔帮你写个正则表达式的助手,它开始理解你的意图、你的逻辑,甚至在你还没想好变量名的时候,就已经为你写好了函数体。

不过,真正的质变还在于TRAE的SOLO模式(Agent自主编程)。

如果说Cue是让你少打字,那么SOLO模式则是让你更省心。

报告提到,SOLO模式在中国版上线后,问答规模瞬间增长了7300%!

之前我们用AI编程更像是在打补丁,哪里不会点哪里:写个排序算法,查个API文档。但现在,AI编程工具已经转变为全托管的状态。

用户不再满足于让AI写两行代码,而是开始通过SOLO模式、通过MCP(Model Context Protocol,目前已支持1.1万个),以及各种Agent,让AI去操作浏览器、管理数据库、执行复杂的端到端任务。

因此,开发者的角色也在悄然改变:从写代码的人(Coder),变成了指挥写代码的人(Commander)。

这种变化在核心用户中表现得尤为明显。

报告中特别提到,6000名全年写代码超200天的硬核用户。数据显示,超过半数的用户在使用过程中会主动进行上下文管理(使用 #file, #code 等标签)。

这说明了什么?说明用户已经不再把AI视为只会回答问题的工具,而是主动将项目的深层逻辑、业务文档、代码结构输入给AI。

简单来说,TRAE的核心用户正在把AI能力融入到项目的核心部分。

那么,接下来一个问题就是:TRAE凭什么能满足这么复杂的需求?

从插件到自主Agent

回顾TRAE的发展历程,你会发现它经历了清晰的三阶段进化。

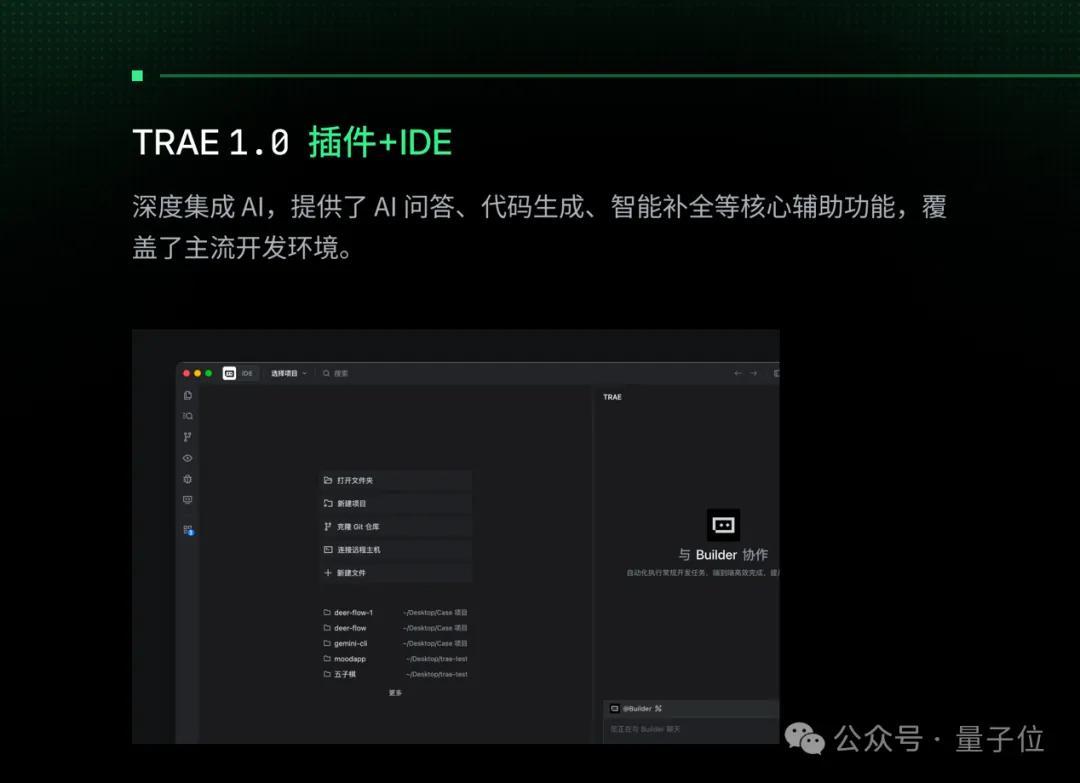

第一阶段,TRAE 1.0(插件+IDE时代)。

那个时候的TRAE更像是一个实用的插件,深度集成了AI,提供问答、代码生成、智能补全。这算是AI编程的初级阶段,解决了从无到有的问题。

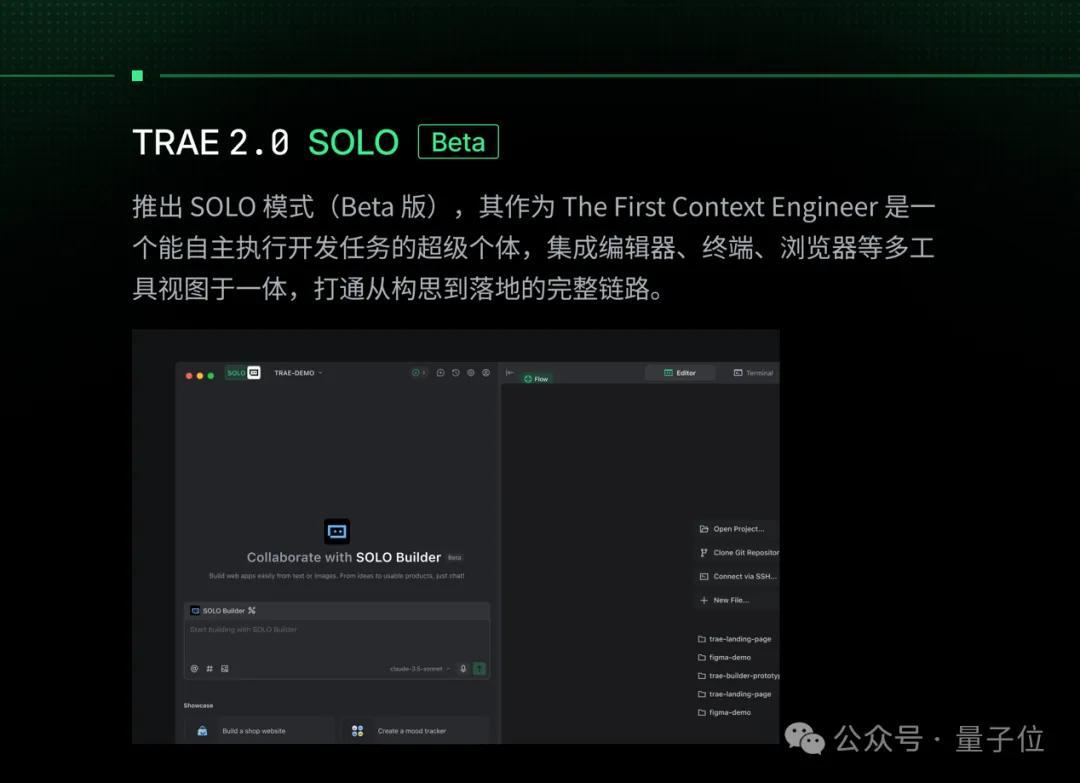

第二阶段,TRAE 2.0(SOLO Beta时代)。

推出了SOLO模式的Beta版。这时,TRAE开始被称为The First Context Engineer,集成了编辑器、终端、浏览器,努力打通从构思到实现的链条。

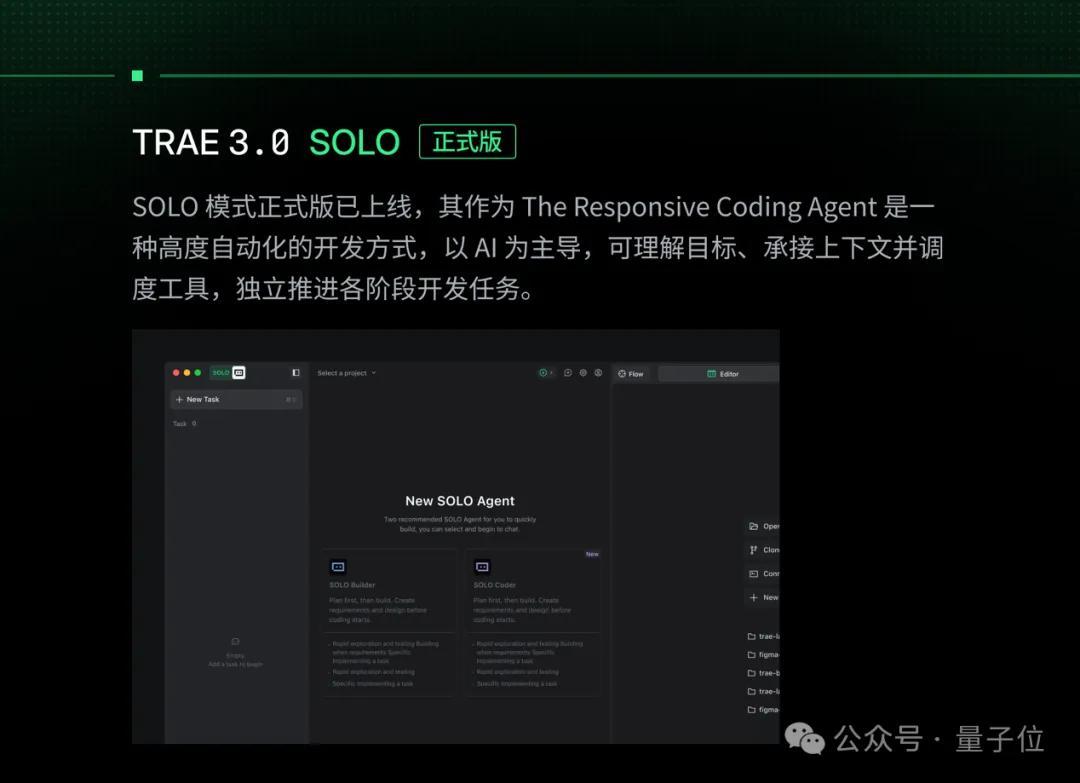

第三阶段,TRAE 3.0(SOLO 正式版)。

这是目前的完全体,TRAE自称为The Responsive Coding Agent。

注意这个词:Responsive(响应式)。

它不仅仅是被动回答问题,而是主动理解目标、承接上下文、调度工具,独立推进开发任务。

这种能力的背后,得益于强大的技术指标。

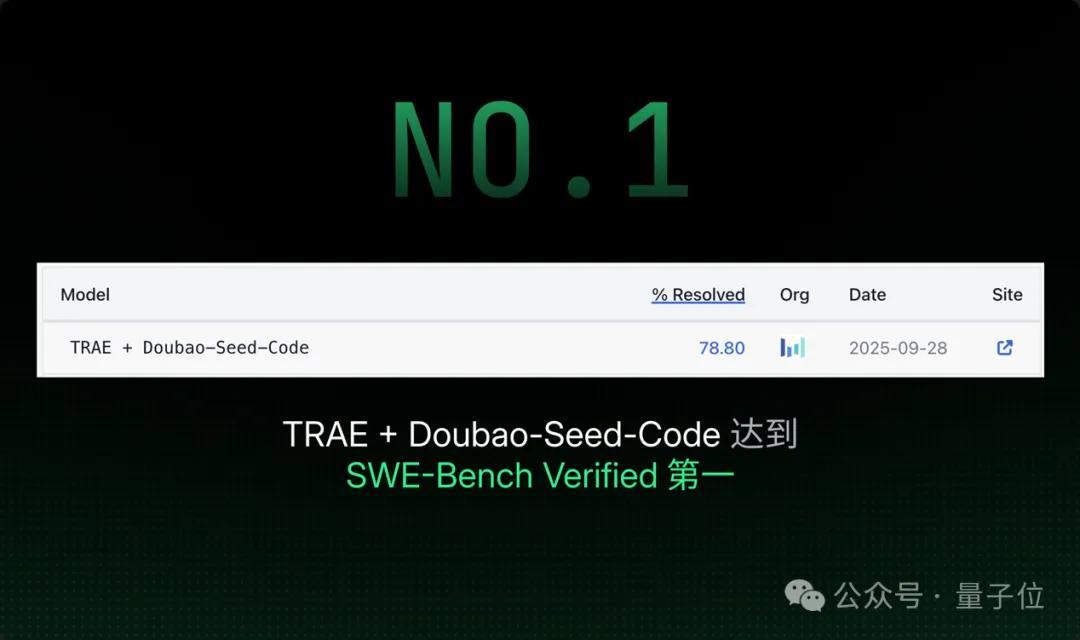

在公认的AI编程能力评测榜单SWE-bench Verified中,TRAE获得了全球第一的好成绩。

但这还不是全部。

如果你觉得TRAE不过是字节跳动的一个普通产品,那就大错特错了,它背后有着深厚的技术积淀。

报告中提到,2025年,TRAE在NeurIPS、ACL、ICSE、FSE、ASE等国际顶级会议上发表了10余篇与AI编程相关的学术论文,其中一篇还入选了NeurIPS Spotlight。

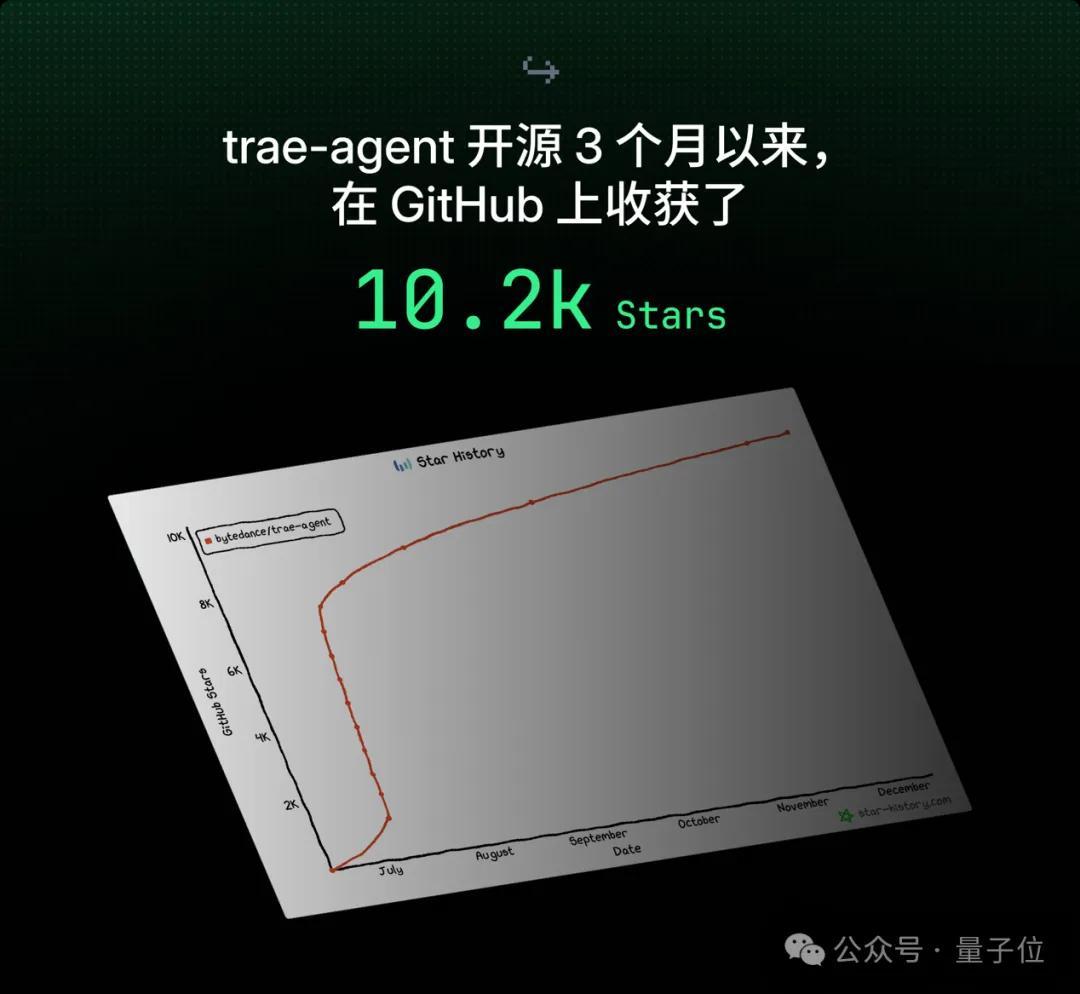

除此之外,他们还将trae-agent开源,GitHub上获得了10.2k Stars,合并了191个社区PR。

不仅快速,还要“稳、准、省”

在AI编程的下半场,竞争的焦点正在悄然转移。

上半场大家比的是代码生成能力,看谁的模型参数大,谁的Demo更炫酷。

而下半场则更注重在低延迟、低内存下,稳定地生成代码。

对于每天需要写大量代码的工程师来说,延迟降低100毫秒,比模型参数多100亿更重要。

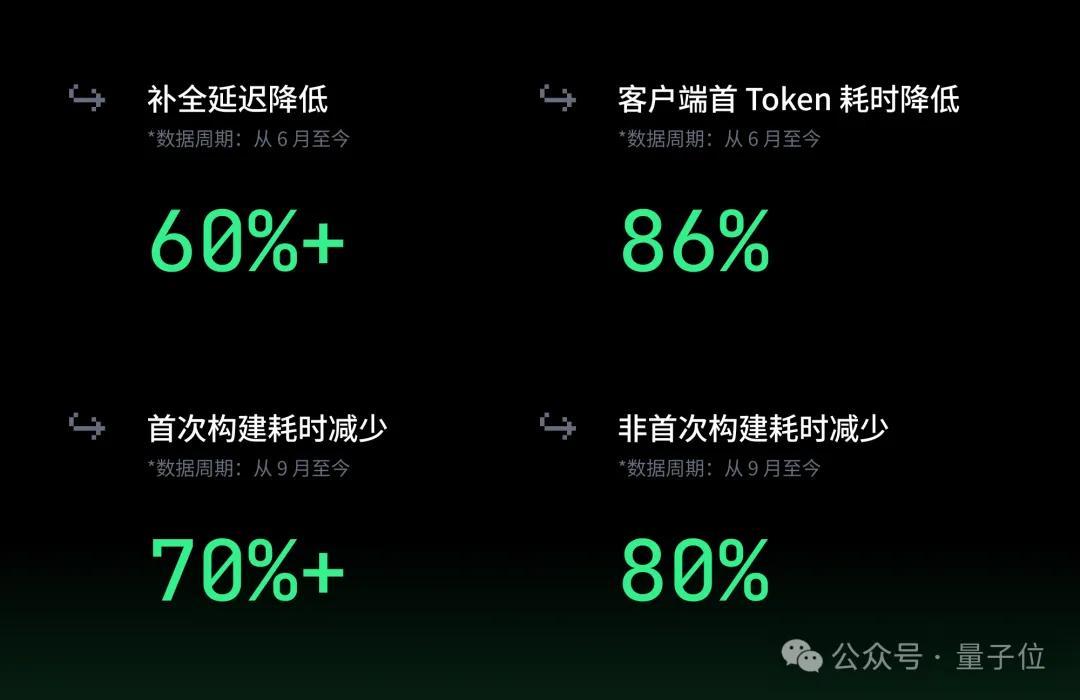

TRAE的年度报告中列出了一组极具参考价值的工程指标:

- 补全延迟降低超过60%。

- 客户端首Token耗时降低86%。

- 内存占用减少43%(在Windows设备上的测试结果)。

- 网络错误数减少60%,补全成功率达到了惊人的99.93%。

这些数据或许不容易直接感受到,但对于支撑大规模复杂项目开发来说却至关重要。

想象一下,如果你的IDE每写几行代码就卡顿,或者突然内存溢出崩了,即便模型再聪明,你也会忍不住把它卸载。

谁能把最先进的模型塞进有限的内存里?谁能在网络不稳定的环境中保证毫秒级的代码补全?

这些看不见的内功,才是真正让TRAE吸引600万用户的关键所在。

中国AI IDE领域的领军者

最后,让我们聊聊市场格局。

2025年,无疑是AI编程历史上一个重要的里程碑。它标志着AI从单纯的工具转变为协作伙伴。

在这个转折点上,TRAE的这份报告,实际上展现了它的领先地位。

它无疑是中国AI IDE领域的领军者,这一点已经没有任何争议。

- 用户规模:全球用户数达到600万,月活跃用户超过160万。

- 迭代速度:一年内更新超过100次。

加上SWE-bench Verified全球第一的成绩,侧面印证了它的实力。

更重要的是路径的选择。

TRAE的出现可谓是个大新闻,和GitHub Copilot早期单一的插件模式截然不同。它一开始就选择了更为复杂的方向:

打造一个结合SOLO、MCP和多智能体的端到端AI开发操作系统。

它的目标不仅仅是成为VScode中的一个小插件,而是想要创造出全新的开发环境。

TRAE通过实用技术回馈社区,组织了130多场线下活动,并通过8个官方社群连接起开发者,借助顶级学术会议来推动技术标准。它正在构建一个“开源、社区、学术”三位一体的生态系统。

这或许正是未来开发者生态的标准模板。

当大家还在讨论“程序员会不会失业”的时候,全球已有600万TRAE用户通过实际行动给出了答案。

他们发起了6000万个对话,发送了超过5亿条查询,消耗了无数Token,最终创造了那惊人的1000亿行代码。

他们没有被AI所取代,反而变得更强大了。

正如报告最后所说:

我们一起,把代码写得更好。

想了解更多,可以查看TRAE的年度产品报告:

https://mp.weixin.qq.com/s/8kdnWsxO3gKk8dzYJnqzJg

—完—

@量子位 · 追踪AI技术和产品新动态

如果你有同感,欢迎点赞、关注和分享哦~ ᕕ( ᐛ )ᕗ ❤