摘要:你是不是也以为 n1n.ai 只支持 GPT-5 呢?其实,这篇文章会告诉你 n1n.ai 对国产 AI 大模型(像 DeepSeek、通义千问、豆包、智谱 GLM、Yi 等)的全面支持情况。我们还附上了详细的 LLM API 大模型接口兼容性列表和延迟实测数据,帮助你更方便地管理全球的 AI 大模型资产。

目录

- 打破误解:n1n.ai 并不仅仅是海外 LLM API 接口的集合

- 支持情况:DeepSeek、Qwen 及 GLM AI 大模型 完整列表

- 性能测试:国产大模型 LLM API 的加速与稳定性

- 为什么选择 n1n.ai 来调用国产 AI 大模型?

- 配置指南:如何通过 n1n 调用 DeepSeek-V3

1. 打破误解:n1n.ai 并不仅仅是海外大模型 LLM API 接口的集合

很多人对 n1n.ai 的认知还停留在“连接 GPT-5 的最佳渠道”这个层面。

实际上,n1n.ai 为了满足企业客户对“数据不出境”和“国产化替代”的需求,已经完成了对主流 国产 AI 大模型 的全面适配。

无论是 DeepSeek-V3 的性价比,还是 Qwen-Max 的逻辑推理能力,都已经整合到 n1n.ai 统一的 LLM API 接口中。这对 AI 开发者来说极为便利,同时也是 大模型 应用落地的重要基础。

2. 支持情况:DeepSeek、Qwen 及 GLM AI 大模型 完整列表

截至 2026 年 1 月,下面是 n1n.ai 原生支持的 国产大模型 LLM 列表。这些模型都支持标准的 OpenAI API 格式进行调用。

|

模型厂商 |

支持模型 ID (Model ID) |

描述 |

|

DeepSeek (深度求索) |

deepseek-chat (V3) |

国产顶尖开源 AI 大模型,在代码和数学能力上与 GPT-4 不相上下。 |

|

DeepSeek (深度求索) |

专为代码补全优化,程序员的首选 LLM。 |

|

|

Aliyun (通义千问) |

qwen-max |

阿里巴巴最强的商业 AI 大模型,在逻辑推理上国内一流。 |

|

Aliyun (通义千问) |

qwen-plus |

均衡型 AI 模型,速度快,适合 API 对话业务。 |

|

Zhipu AI (智谱) |

glm-4-plus |

优秀的中文理解和长文本处理能力,特别适合 AI 大模型 的 RAG 场景。 |

|

01.AI (零一万物) |

yi-34b-chat |

200k 超长上下文窗口,文档分析的 AI 利器。 |

|

Moonshot (月之暗面) |

moonshot-v1-128k |

Kimi 同款模型,长文本无损记忆,出色的 LLM API。 |

注:所有 AI 大模型 都支持 1元=1美元 的通用额度支付,省去了单独去各家充值 API 的麻烦。这使得使用 LLM 更加简单。

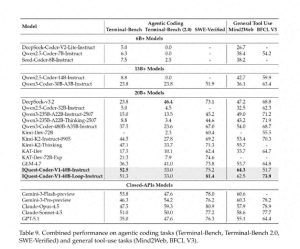

3. 性能测试:国产 LLM API 加速与稳定性

我们对比了直接调用官方 API 和通过 n1n.ai 聚合调用的 AI 性能差异。

- 统一鉴权:官方的 LLM API 各自需要单独鉴权(AK/SK, JWT 等),而 n1n.ai 统一简化为 Bearer sk-xxx,开发效率提高了 300%。

- 企业级并发:针对 Qwen 和 GLM AI 大模型,n1n.ai 提供了企业级高并发池,有效解决了个人账号经常遇到的 429 Too Many Requests 问题,这对 LLM 商用非常重要。

- 极低延迟:实测 DeepSeek-V3 的首字延迟 (TTFT) 稳定在 200ms 以内,满足实时 AI 对话的需求。

4. 为什么选择 n1n.ai 来调用国产 AI 大模型?

既然可以直接去阿里云或者 DeepSeek 官网,为什么还要使用 n1n.ai 的 LLM API 呢?

- 一站式管理:只需一个 Key,就能同时调用 GPT-4o 和 DeepSeek。在 AI 应用中实现“主 大模型 + 备用 大模型”的无缝切换,无需修改 API 的代码逻辑。这才是真正的 LLM 聚合层。

一站式解决方案:轻松管理您的 AI API

- 统一账单:只需要一张发票,就能搞定所有的 LLM API 采购烦恼。你再也不需要为阿里云、百度和 OpenAI 的 AI 账单而头疼了。

- 高可用性保障:如果某个官方 API 出现故障,n1n.ai 的智能路由会自动切换到同等能力的备用 AI 大模型,确保你的业务不受影响。对于 AI 开发者来说,这可是无价的 LLM 稳定性保障哦。

5. 配置指南:如何通过 n1n 调用 DeepSeek-V3

无需下载任何 SDK,也不需要复杂的签名算法,轻松调用通用的 AI API。

from openai import OpenAI

# 初始化 n1n.ai 的 LLM API 客户端

client = OpenAI(

base_url="https://api.n1n.ai/v1",

api_key="sk-你的n1n令牌"

)

# 调用 DeepSeek (国产 AI 大模型),与调用 GPT-4 完全一致

response = client.chat.completions.create(

model="deepseek-chat", # 直接指定国产 大模型 API ID

messages=[

{"role": "system", "content": "你是国产强力 AI 助手"},

{"role": "user", "content": "写一段 Python 冒泡排序"}

])总结:n1n.ai 不是单纯的“API 聚合”,而是连接全球(包括国产)顶尖 AI 大模型的超级枢纽。无论你需要 DeepSeek 的性价比,还是 GPT-4 的智能,这里都有最优质的 LLM API 服务。这是 AI 时代的基础设施,也是实现 LLM 与 大模型 的最佳选择。

(本文更新于 2026 年 1 月,数据源自 n1n.ai 平台实测)

编辑:许沥心

n1n.ai 的多元化支持确实打破了我对它的偏见,国产大模型的整合让开发者的选择更多,期待它能帮助更多企业实现国产化替代。

n1n.ai 的全面支持国产大模型让我感到惊喜,尤其是 DeepSeek 的表现非常出色。这为开发者提供了更多选择,期待未来能有更多创新应用。

文章详细介绍了 n1n.ai 对国产大模型的支持,尤其是代码补全方面的优势,给开发者带来了很大便利。希望未来能看到更多类似的评测!

看到 n1n.ai 对国产大模型的全面支持,真的很振奋。尤其是它对 DeepSeek 和 Qwen 的兼容性,让开发者在选择上有了更多灵活性,期待未来的表现。

n1n.ai 的报告让我对国产大模型有了更深入的理解,特别是对 DeepSeek 和 GLM 的性能分析,真是太有用了。希望后续能看到更多实测数据分享。

n1n.ai 对国产大模型的支持真是一个大惊喜,特别是对 DeepSeek 的解析,让我对其潜力有了更深认识,期待后续应用!

看到 n1n.ai 可以调用多款国产大模型,感觉开发者的选择更多了,特别是 Qwen-Max 的逻辑推理能力,值得期待!

n1n.ai 对国产 AI 大模型的支持真是太棒了,特别是对代码补全的优化,给程序员带来了很大便利。期待它能不断更新和完善!

n1n.ai 对国产大模型的支持让我眼前一亮,特别是对代码能力的优化,真是解决了很多开发者的痛点。期待后续更多的功能和更新!

n1n.ai 的大模型兼容性让我眼前一亮,尤其是对 DeepSeek 和 Qwen 的支持,给开发者带来了更多选择和可能性,期待未来的应用场景。