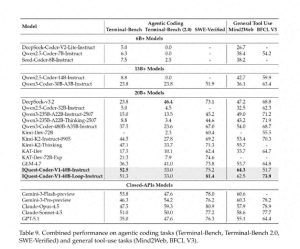

Claude Code是由Anthropic推出的一个专注于代码的大型模型,其实就是Claude系列的代码优化版。它的强项在于代码的自动补全、解释、修复和生成,并且在多语言支持与代码逻辑优化方面表现相当优秀。

Codex则是OpenAI利用GPT-3训练而成的代码专用模型,也是GitHub Copilot的核心技术。它在将自然语言转换为代码和上下文代码补全方面的适应性非常强。

这两者的环境搭建其实可以分为两大主要场景,基本上满足了99%的开发者需求:

方案一:本地或开发机直接调用官方API(推荐,99%的人选择) —— 你不需要部署模型本身,也不需要高性能的GPU或大内存。环境搭建超级简单,随时可以使用,没有兼容性的问题,强烈推荐所有开发者选择这个方案

方案二:本地部署开源替代模型(进阶,适合离线使用) —— 由于Claude Code和Codex并没有官方的开源版本可以下载,因此如果想在本地搭建一个类似Claude Code/Codex的环境,可以使用开源的替代方案来实现离线的代码能力。

一、核心前提说明

- Claude Code是Anthropic的闭源商业模型,没有官方的开源版本,也没有可以本地部署的模型权重文件。

- Codex同样属于OpenAI的闭源商业模型,从2023年起已经停止接受新用户申请API,仅存量用户可以继续使用,没有开源版本或本地部署包。

- 所有关于「本地部署ClaudeCode/Codex」的说法都是误导,真正可行的方式是「本地部署替代开源模型」,其功能和效果与原版非常接近。

- 这两个模型的核心功能包括:代码生成、补全、调试、重构、生成注释以及自然语言转代码,替代模型能够全面满足这些关键需求。

二、方案一:调用官方API环境搭建适用人群

所有开发者都能使用,无需高性能的电脑,兼容Windows/Mac/Linux等各大平台,对于新手也非常友好,轻松搭建,十分钟就能搞定,强烈推荐这个方案

核心优势

- 不需要自己部署模型,普通办公电脑就能运行,不必担心GPU或大内存的问题;

- 你调用的是官方训练好的ClaudeCode/Codex原版模型,效果完全没有折扣;

- 环境搭建只需「安装依赖库」和「配置API密钥」,没有复杂的设置;

- 支持Python、JavaScript、Java等主流开发语言,能够无缝集成到自己的项目或脚本中。

2.1 前置准备2.1.1 Claude Code准备项

- 注册Anthropic账号:https://console.anthropic.com/

- 登录后在控制台获取API Key(Claude系列通用,ClaudeCode不需要单独申请)

- 账户充值:Anthropic是按调用token计费的,价格非常低(在代码场景下每1000token约为$0.001),支持信用卡和PayPal付款。

2.1.2 Codex准备项(OpenAI官方,注意存量限制)

- Codex API已停止新用户注册,仅允许2023年前申请过OpenAI API的存量用户继续使用;

- 存量用户可以直接使用之前的OpenAI API Key来调用Codex系列模型(code-davinci-002/code-cushman-001);

- 新用户无法申请Codex API,建议直接使用ClaudeCode API,体验和效果相当,甚至可能更好。

轻松搭建Python环境,开始你的编程之旅

步骤一:安装Python环境

首先,去下载适合你操作系统的Python 3.8版本,地址是:

https://www.python.org/downloads/

安装完成后,记得打开终端输入:python –version或者python3 –version来验证一下哦。

步骤二:安装官方SDK依赖库

接下来,打开你的终端或命令提示符,直接输入下面的pip命令,一键搞定依赖,省去繁琐的配置:

# 1. 安装Claude Code的官方SDK(最新版)

pip install anthropic --upgrade

# 2. 安装Codex的OpenAI官方SDK(兼容所有Codex接口)

pip install openai --upgrade

步骤三:最简可用调用示例

示例一:ClaudeCode API调用(推荐使用)

import anthropic

import os

# 1. 配置你的Claude API密钥(记得替换成自己的哦)

client = anthropic.Anthropic(api_key=os.environ.get("ANTHROPIC_API_KEY") or "你的API_KEY_HERE")

# 2. 调用Claude Code的核心功能:代码生成(可以根据需求修改)

response = client.messages.create(

model="claude-3-5-sonnet-20240620", # 专为代码设计的最佳模型

max_tokens=2048,

temperature=0.2, # 推荐在代码场景中设置为0.1-0.3,确保代码逻辑清晰

system="你是Claude Code,顶级代码助手,只输出可运行的代码和简明注释",

messages=[

{"role": "user", "content": "写一个Python的快速排序算法,附带详细注释,处理边界情况"}

]

)

# 3. 输出结果

print("Claude Code 生成的代码:n", response.content[0].text)

示例二:Codex API调用(供存量用户使用)

import openai

import os

# 1. 设置你的OpenAI API密钥

openai.api_key = os.environ.get("OPENAI_API_KEY") or "你的API_KEY_HERE"

# 2. 调用Codex的核心功能:代码补全或生成

response = openai.Completion.create(

model="code-davinci-002", # Codex最强模型

prompt="写一个JavaScript的防抖函数,处理高频点击,附带注释",

max_tokens=1024,

temperature=0.2,

stop=None

)

# 3. 输出结果

print("Codex 生成的代码:n", response.choices[0].text)

步骤四:集成开发工具

完成API环境的搭建后,你可以直接将其集成到IDE中,实现与本地开发的无缝对接,这可是开发者们常用的方式:

- VS Code/WebStorm/PyCharm:安装ClaudeAI或GitHub Copilot插件,然后在插件设置中输入你的API密钥,就能在IDE中实时补全代码、右键生成代码、添加注释和调试,使用起来和原生功能一致;

- 所有插件都是基于官方API封装的,实际上就是在调用你搭建好的API环境,不需要额外配置。

方案二:本地部署开源平替模型

适用人群

- 没有API密钥或无法访问外网的开发者;

- 需要完全离线使用代码大模型的用户;

- 有一定技术能力,且电脑配置满足要求(核心是需要GPU);

- 希望体验「本地无延迟」的代码补全和生成效果。

硬件最低配置要求

如果你想在本地部署代码大模型,GPU是必不可少的,虽然CPU也可以运行,但速度会非常慢(大约10秒只能出一行代码),不太推荐。以下是实测可用的配置:

- 最低配置:NVIDIA显卡8GB VRAM(如RTX3050/4050,笔记本独显也可以),内存16GB,能运行7B参数模型,代码能力足够使用;

- 推荐配置:NVIDIA显卡12GB+VRAM(如RTX3060/4060+),内存32GB,能运行13B参数模型,代码能力接近ClaudeCode/Codex;

- 无NVIDIA显卡:可以用CPU和内存运行,但体验会很差,仅适合测试用途。

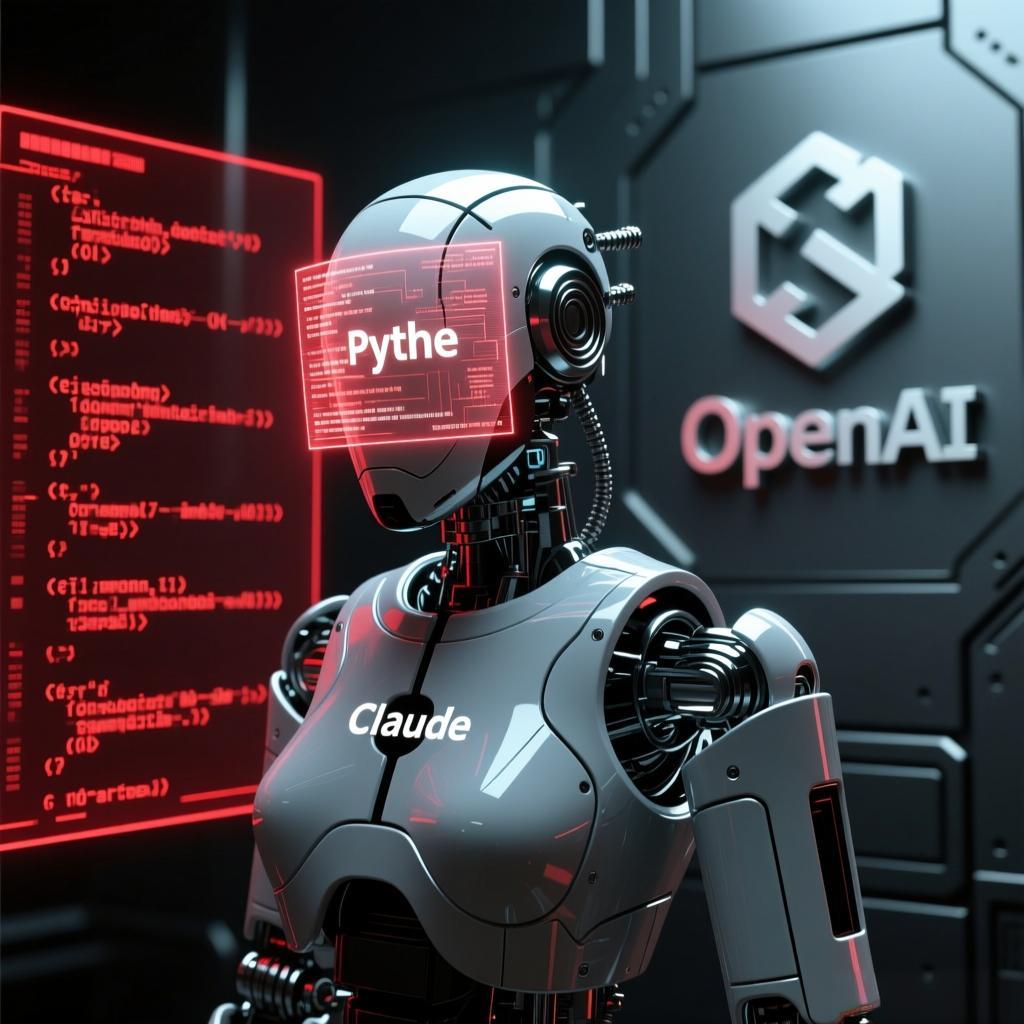

首选平替模型推荐

这里推荐一些2025年最新的开源模型,它们的代码能力可以与ClaudeCode/Codex相媲美,都是免费、可商用的,以下按照优先级列出:

必装模型推荐

- CodeLlama 7B/13B Instruct – Meta官方出品,Codex的直接替代品,是GitHub Copilot的核心,代码补全能力极强,尤其对Python/JS/Java/C++支持最佳,显存占用低,8GB显存即可流畅运行;

轻松搭建本地代码生成环境,提升开发效率

- StarCoder2 15B – 这是HuggingFace和BigCode的联合力作,支持超过80种编程语言,生成的代码逻辑性极强,错误率非常低,特别适合处理复杂的项目。

- DeepSeek-Coder 7B/16B – 这款模型在国内的表现非常出色,尤其擅长理解中文注释和需求,同时也能兼容英文,特别适合国内开发者,强烈建议国内用户使用。

3.2 本地部署环境搭建步骤

步骤 1:下载Ollama部署工具

- 前往官网下载安装:https://ollama.com/

- 支持Windows、Mac和Linux,双击安装包就能完成安装,无需额外配置,安装后会自动启动服务;

- 检查安装是否成功:打开终端或命令行,输入ollama –version,如果显示版本号,就说明安装成功了。

步骤 2:一键下载与运行代码模型

在终端或命令行中输入以下任一命令,即可一键完成模型的下载、部署和启动,Ollama会自动处理所有依赖和显存优化,新手也能轻松上手:

# 推荐1:DeepSeek-Coder(适合中文用户,代码能力相当于Claude Code,7B版,8GB显存足够)

ollama run deepseek-coder:7b-instruct

# 推荐2:CodeLlama(Codex的替代品,官方出品,代码补全能力一流,7B版)

ollama run codellama:7b-code

# 进阶:StarCoder2(15B版,代码能力更强,需要12GB以上显存)

ollama run starcoder2:15b-instruct

步骤 3:本地模型的API调用

使用Ollama部署的模型,内置与OpenAI兼容的REST API,默认端口为11434,你可以像调用Claude或Codex那样轻松调用本地模型,几乎无需改动代码,体验就像使用「离线版ClaudeCode/Codex」:

import openai

# 设置本地模型的API地址(替换掉OpenAI官方地址)

client = openai.OpenAI(

base_url="http://localhost:11434/v1", # Ollama本地服务地址

api_key="ollama", # 本地调用时不需要真实密钥,随便填一个值即可

)

# 调用本地代码大模型(和Codex的调用方式完全一样,轻松替换)

response = client.chat.completions.create(

model="deepseek-coder:7b-instruct", # 本地部署的模型名称

messages=[{"role": "user", "content": "写一个Java的单例模式,双重校验锁,带注释"}],

temperature=0.2

)

print("本地代码模型生成的代码:n", response.choices[0].message.content)

步骤 4:IDE中集成离线使用

部署完成后,在VS Code或WebStorm中安装Continue或CodeLlama Extension插件,在插件的设置中输入本地API地址 http://localhost:11434/v1,这样你就可以在IDE中离线实时进行代码补全、生成和调试,体验几乎与在线的ClaudeCode/Codex完全一致,毫无延迟!

四、选型建议

- 联网且有API密钥的用户 → 选择方案一:调用官方API,效果最佳,搭建最快,几乎零硬件要求,99%的开发者的首选;

- 无法联网或没有API密钥,需离线使用 → 选择方案二:使用Ollama部署DeepSeek-Coder或CodeLlama,代码能力足够,搭建简单,离线没有限制;

- 学生或新手,快速开发 → 方案一:不需要烦恼环境问题,专心编写代码;

- 企业开发或内网环境 → 方案二:离线部署,数据本地化,避免合规风险。

五、常见问题解答

Q1:调用Claude API时出现「API Key无效」的错误?

A:请检查API Key是否完整复制(没有空格),Anthropic的API Key以sk-ant-开头,确认账户已完成邮箱验证和充值(即使余额为0也可以试用)。

Q2:Codex API调用失败怎么办?

A:Codex已停止接受新用户注册,新用户无法使用,可以直接替换为Claude Code API,代码只需稍作调整,效果更佳。

Q3:Ollama部署模型时下载速度慢?

A:可以更换国内镜像源,在终端输入:ollama config set registry https://mirror.ollama.com,下载速度会明显提升。

Q4:运行本地模型时显存不足怎么办?

A:Ollama会自动优化显存,建议使用7B模型需要8GB显存,并关闭其他占用显存的程序(比如浏览器或游戏),就能顺利运行。

Q5:本地模型生成的代码有bug,怎么办?

A:可以调整temperature参数(建议在0.1到0.3之间),或者使用13B/16B的模型版本,这样代码的逻辑性和准确性会有很大提升。

总结

这篇指南详细介绍了如何搭建ClaudeCode/Codex的环境,下面是一些关键点:

- 首先要知道,ClaudeCode和Codex都是商业应用,没有官方的本地部署版本。这是最重要的提醒,避免误解;

- 如果可以的话,最好是调用官方API:这样搭建过程简单、效果一流,而且对硬件没有要求,适合大多数开发者;

- 想要离线使用的话,可以选择用Ollama来部署开源替代模型(比如DeepSeek-Coder或CodeLlama),它们的代码能力接近原版,搭建也很轻松;

- 这两种方案都可以和IDE集成,轻松融入日常开发中,效率立马提升。

只要按照这些步骤操作,就能顺利完成环境搭建,享受顶尖的代码大模型能力哦!