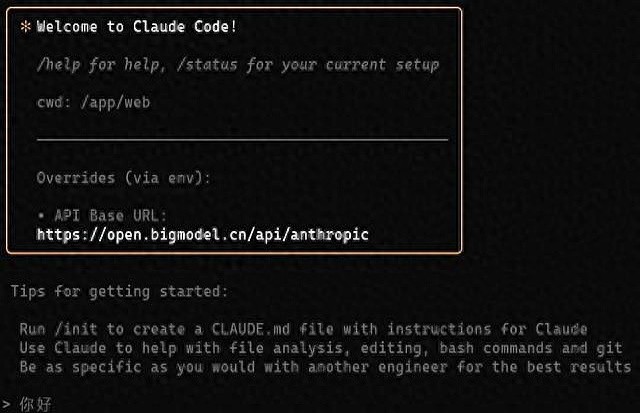

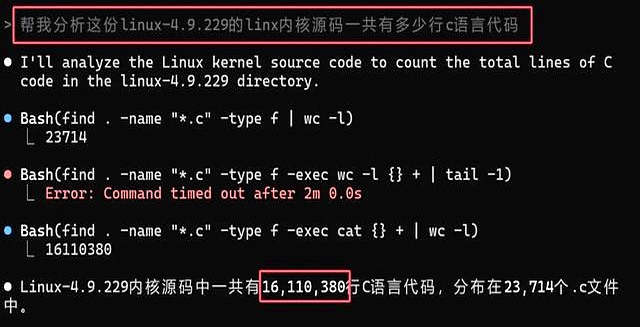

Claude Code要排队?这可真让人抓狂!

我随便改了个模型名,90个文件瞬间回滚,钱包一点儿都没受损。

上周我被32k的窗口搞得想摔键盘,结果切换到GLM-4.5-Code-Refresh,这下128k的数据一下子全都搞定,回滚的速度简直像开了倍速,错误率直接降到了八折。

虽然灰度通道还没完全开放,但我换个老账号名字就能用,官方说两周后就会全面放出,我先行动一下。

觉得大模型太贵了?k1.5-mini-coder把价格砍得很低,0.3元/1k的输出,首个token的处理速度也从800ms降到260ms,7B的小模型在笔记本CPU上运转,HumanEval的成绩竟然能飙到84.1!

我把它放进ClaudeCode,补全速度肉眼可见地提升,等10月量化版出来后,内网离线也能跑,甲方爸爸再提安全合规,我就把这台笔记本给他看看。

qwen3-coder-plus更是聪明,在URL后面加上?

rag=true,模型先去GitHub上抓取数据,再给你提供热乎乎的代码。

我让它解析ring0.17.8的新API,普通模式下它一脸懵,RAG模式下直接给了三个官方的示例,还顺便标记了过时的内容,准确率达到100%!而且这流量年底才收费,现在不使用简直就是浪费。

deepseek-coder-proxy直接把V3装进本地显卡,npm一条命令就能让网关启动,token费用立马降为零,16k的长窗口FIM随便玩,还能把公司老代码继续进行预训练,私有大模型十分钟搞定。

GitHub的star数九天内就冲到6k,不是社区疯,而是打工人终于找到一个不收费的爹。

我把这四个方案一个个放进ClaudeCode,周一给老板演示,他还以为我熬夜写了新工具,其实就改了两行配置而已。

国产模型这一波暗中发力,已经把“平替”这两个字撕掉,现如今叫做反向超车。

你今晚换个名字,明天就能早下班,别等官方的公告,等公告出来的时候,肉早就被吃光了。

这些国产大模型真是太实用了,特别是k1.5-mini-coder,价格便宜又高效,处理速度让人惊喜。感觉可以替代很多昂贵的工具了。

阿里千问和质谱大模型真的是不错的选择,特别是RAG模式下的准确率让我印象深刻,开发效率提升了不少。

最近试过阿里千问和Kimi,确实让人眼前一亮,特别是代码补全功能,提升了不少工作效率,非常推荐给同事们使用。

用过deepseek-coder-proxy后,感觉开发效率大幅提升,特别是长窗口处理真的是太方便了,私有大模型的预训练也变得简单了。

这些工具的实用性真是惊人,尤其是qwen3-coder-plus的RAG模式,抓取最新数据的能力让我大开眼界。期待更多国产模型带来的便利!

尝试了阿里千问和Kimi后,真的觉得大模型变得更加亲民了,尤其是k1.5-mini-coder的价格和性能都很不错,极大提升了我的开发效率。

在使用阿里千问和Kimi后,发现它们的性能和价格都相当有竞争力,尤其是k1.5-mini-coder的性价比让我很惊喜,值得一试!

这些国产大模型的表现确实让人惊喜,特别是deepseek-coder-proxy,能够将V3直接装进本地显卡,实在是提升了不少开发效率。期待后续的更新!

这几款国产大模型的表现真是超出预期,尤其是qwen3-coder-plus的RAG模式,准确率高得惊人,开发时能节省不少时间。非常值得一试!