编辑:编辑部 HYZ

【新智元导读】嘿,你知道吗?OpenAI的超级智能体居然被一家中国公司抢先发布了!智谱率先推出了L3级别的工具使用能力,发布了全球首个面向大众、即刻可用的电脑智能体GLM-PC。

春节假期还有4天就到啦,这个时候大家最期待的是什么呢?

当然是发拜年微信呀!

想象一下,你在微信上给xxx发送一些祝福,再附上一张新春的图片和祝贺视频。

听起来是不是比抢红包还要让人兴奋呢?

就在刚才,一个名叫GLM-PC v1.1的智能体悄然登场。

它可以当你的“手替”,帮你处理各种事情。

例如,你只需上传一张图片,然后给它下达指令——“识别图片信息并生成朋友圈文案,发送到朋友圈”。

它会把任务拆分成几个步骤,先识别图片内容,然后生成配文。

然后,AI就会自动打开微信,进入朋友圈,上传图片,再加上文案,一键发送,轻松搞定。

这个神奇的操作真让许多人惊呆了。

现在的AI竟然这么厉害吗?

没错,这个在去年11月就率先推出的“GLM-PC”,就是智谱发布的全球首个可供公众使用的电脑智能体,大家亲切称它为“牛牛”。

听说OpenAI的新超级智能体这周就要登场了

经过全新的v1.1版本更新,这个智能体不仅能像我们一样「看」和「操作」电脑,自主搞定一系列复杂任务,还增加了「深度思考」模式,并且专门针对逻辑推理和代码生成进行了优化。

值得注意的是,GLM-PC的Windows和Mac版客户端已经同步上线,大家可以体验一下了。

可以试用的地址是:https://cogagent.aminer.cn

左脑右脑,GLM-PC的智能体思维结构解析

2025年将会是智能体的一个新起点。

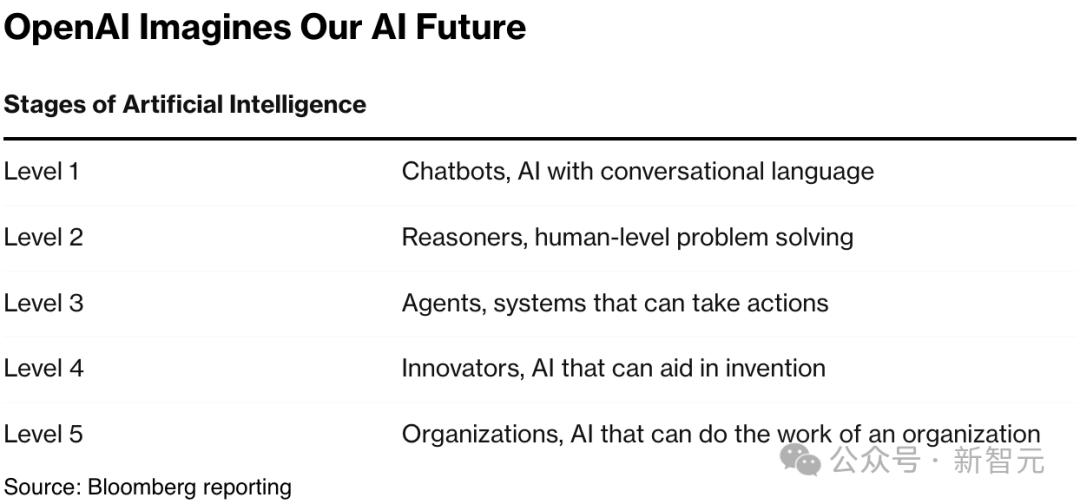

OpenAI内部曾披露过AGI的发展路线图,讲到这个最终目标的实现分为五个阶段。目前他们已经完成了第二阶段,接下来就会向自主AI智能体进发。

几周前,ChatGPT的「任务」功能已经让大家见识到了AI自主管理股票和日程的能力。

而且,像谷歌、微软、Ahthropic和亚马逊这些国际知名科技公司也开始在智能体领域加速布局。

与这些巨头相比,智谱在智能体方面早已展现出了不俗的实力,令人瞩目。

不得不提的是,他们在2024年10月推出的AutoGLM,凭借其流畅的智能手机操作,迅速引起了科技界的热烈关注。

智谱能在这个领域走在前面,得益于他们从一开始就制定的AI发展蓝图。

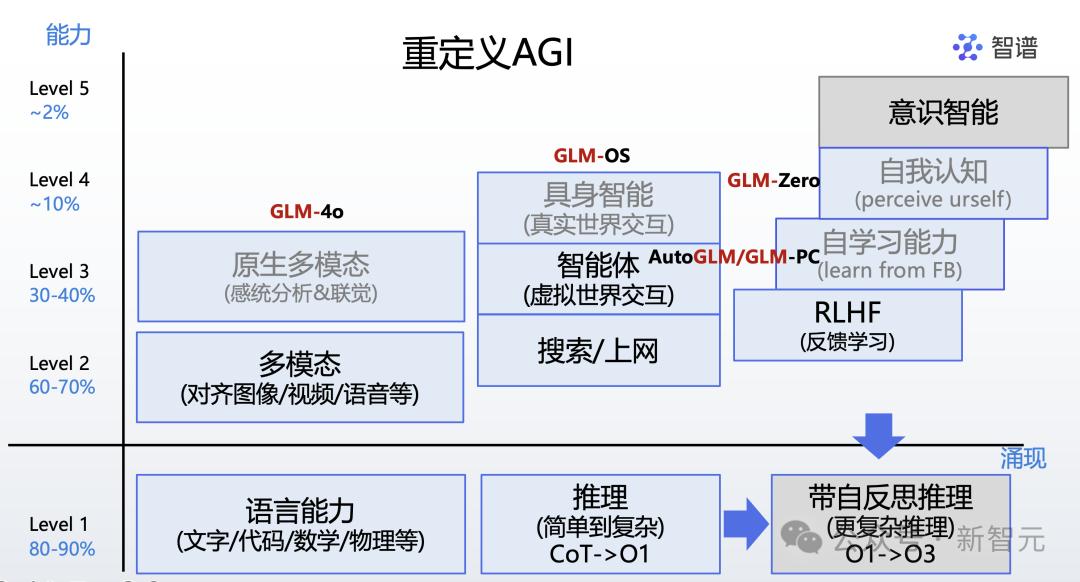

智谱在2024年把AGI的实现分成了五个阶段,从L1逐步提升到L5。

他们认为,AI的能力已经超越了传统的语言和文本处理。

眼下,AI的应用已经从简单的语言和文本,扩展到了多模态和工具的使用,未来还会有更多自我认知的能力出现。

最近,智谱的CEO张鹏在Agent OpenDay上再一次分享了他们对AI能力演进的战略思考:

目前,LLM已经具备了与人类和现实世界互动的初步能力。

智能体将大幅提升L3的工具使用能力,同时也将开启对L4自我学习能力的探索。

这项技术愿景,正是智谱独有的特色。

智谱新进展:多模态智能体的未来之路

GLM-PC v1.1的发布,标志着智谱在L3级智能体领域又向前迈出了一步!

到目前为止,智谱已经推出了手机智能体AutoGLM和电脑智能体GLM-PC,实现了工具使用能力的显著提升。

这两款系统分别针对移动设备和桌面端进行了优化——

在手机上,AutoGLM可以轻松控制各种应用,实现跨场景的智能互动;而GLM-PC则通过视觉语言模型VLM,将电脑操作提升到新的水平,结合逻辑推理与感知能力,让AI在复杂系统工具中展现出更强的掌控力。

这些功能并不是简单的叠加,而是对人机交互方式的深刻变革。

按照这个技术发展路线图,AI在实现L3后,通过不断优化工具使用,正在为L4阶段的自主学习与创新打下坚实的基础。

这也是智谱接下来要探索的智能领域。

多模态感知,开启全GUI空间交互新篇章

说到现在,LLM的一个明显不足之处是,能够公开使用的纯文本API工具非常有限。

这就大大限制了语言模型作为Agent的应用场景。那么,有什么办法可以打破这个局面呢?

智谱选择了一条走向全GUI空间交互的道路——依靠多模态感知!

这个思路体现在以CogAgent为代表的一系列基于视觉语言模型(VLM)的图形界面智能体(GUI Agent)上。

基于VLM的GUI Agent通过模拟人类行为,能够感知和理解交互界面中的视觉元素及其整体布局,并模拟人类进行各种操作(如点击、键盘输入、悬停、拖拽等)。

这样一来,Agent在虚拟交互空间中的应用边界就被大大拓宽——理论上,任何人类能够完成的GUI操作,这种多模态Agent都能做到!

接下来,我们需要解决的问题是,如何让这些智能体在实际应用中完成复杂任务。

为此,我们需要构建一个在感知、思维和执行层面都非常完备的Agent系统。

在感知层面,能够接收任务所需的多种信号,比如文字、图像、视频和音频。

在思维层面,具备严谨的逻辑思维和复杂任务规划的能力(类似左脑),同时又具备高效全面的感知能力和灵活的拟人操作能力(类似右脑)。

在执行层面,能够完成全GUI空间的操作,接收环境反馈并进行自我纠正。

在这其中,最关键的一点就是要在逻辑性和创造性之间找到平衡。

如今,智谱借鉴了人类「左脑」与「右脑」的分工,成功实现了逻辑推理与感知认知的深度结合,赋予了GLM-PC这样的能力。

Agent的左脑:逻辑思维框架与执行能力

智能体的大脑,就像人类的左脑负责逻辑、语言和数学等理性信息,而右脑则主要处理视觉、感知等感性信息。

因此,GLM-PC的「左脑」就承担着逻辑推理、编码以及任务执行的职责。

它主要专注于规划、循环执行、动态反思、纠错与优化。

规划(Planning)

想象一下,如果你有一个超级助手,能够根据你的需求,迅速把繁杂的任务拆分成简单明了的步骤,那可真是省心省力。

GLM-PC的「左脑」,正是如此出色的智能规划大师。

它通过全面分析目标和资源,能为你制定执行的路线图,把大任务自动分割成小的、易于管理的子任务,帮助你理清执行思路。

眼看春节就要到了,假设你需要购置一批年货,只需把整理好的图片链接交给牛牛,并告诉它——

提取图片里的商品信息,创建一个新Excel表格存储这些信息,并把商品加到淘宝购物车里。

牛牛获取到图片信息后,会把指令里的需求拆解,先保存Excel文件,然后列出将魔芋爽、薯片、猪肉脯、辣条加入购物车的具体步骤。

完成规划后,GLM-PC会启动代码生成模块,开始逻辑循环,逐步推进任务的完成。

接下来,就让我们见证这一切的奇迹吧。

循环执行(Looping Execution)

牛牛进入淘宝主页,开始搜索魔芋爽,点击加入购物车;然后回到搜索页,寻找薯片并加入购物车;接着继续执行,直到所有商品都成功加入购物车。

这一切都无需你亲自动手,AI全程帮你搞定。这是因为在规划阶段结束后,GLM-PC会启动代码生成模块,进行逻辑循环,逐步完成各项任务。

可以看到,GLM-PC的循环机制确保了任务精准执行与高度自动化,从而实现从输入到输出的完整闭环,不需要人工插手。

长思考能力:动态反思、纠错与优化

以上,仅仅是GLM-PC左脑基本操作的一个小例子。

除了能生成静态规划,它在执行任务时,还可以根据环境信息进行实时调整,反思并纠正错误,持续优化解决方案。

比如说,你和朋友们计划假期去看一场「春节贺岁档电影」,小红书上会有不少推荐。

这时候,你完全不需要自己去手动查找,只需打开牛牛,告诉它——

在小红书搜索「春节贺岁档电影」,引用第一篇图文帖的图片,把它发送到微信的{GGG}群聊,问问大家想看哪部。

就像之前的例子,牛牛收到指令后,会逐步分解任务,首先在小红书中查找「春节贺岁档电影」的第一个帖子。

接下来,牛牛又回到工作台,开始执行另一个任务——在微信中找到「GGG」群聊,发送一条消息。

这样一来,你就能省去大量手动筛选和分享的麻烦。

总之,通过这些自动化的操作,GLM-PC让我们的社交互动和决策变得更加轻松。

Agent右脑:图像与GUI认知

看过GLM-PC的「左脑」功能后,它的「右脑」同样让人惊艳,具备深度的感知和交互体验。

它的核心功能涵盖了很多方面,比如图形用户界面(GUI)的图像理解、用户行为的认知、图像的语义解析,以及多模态的信息融合。

以春节常见的场景为例,现在有了GLM-PC,我们就能向领导发送各种形式的祝福了!

给微信上的「大Boss」发送2025年新春祝福,再给他制作一张新春的图片。

GLM-PC会进入微信找「大Boss」,生成一条简单的祝福语,确认后就发送出去。

接着,再返回控制台,生成一张精美的图片发给老板。

有了这个新年祝福小工具,你就可以随意玩手机,想发多少祝福都能轻松搞定。

左右脑联动,提升你的能力!

正是因为这种左右脑合作的方式,GLM-PC被称为“代理中的代理”。

现在,它不仅能够处理复杂的逻辑问题,在面对开放式的问题时,适应性、创造力和泛化能力都变得更强了。

举个例子,即使是它从未见过的网站和任务,GLM-PC也能顺利完成。

有了这个AI,手动抄题的日子真是要结束了。

现在,简单将试卷的PDF文件上传,就能让GLM-PC提取出你需要的内容,简直轻松无比。

帮我打开桌面上的《排列组合与二项式定理练习.pdf》文件,提取当前界面上的前几道数学题,并放到一个新建的Word文档里。

成功提取文字后,AI会自动把信息保存到Word文档中。

再比如,如果我想追一部剧——「驿站」,我只需告诉GLM-PC:「腾讯视频搜索『驿站』电视剧,并播放」。

它会迅速跳转到腾讯的主页,搜索相关关键词,然后开始播放视频。

背后模型

GLM-PC的背后,实际上是智谱自己开发的多模态智能体模型CogAgent和代码模型CodeGeex在支撑。

在这个智能体工作的时候,首先会创建一个代码形式的思维框架,这个框架会引导GLM-PC的操作流程和工具的使用。

在这个期间,GLM-PC能够高效地处理各种复杂的场景和任务,真的是相当给力。

并且在具体执行中,GLM-PC会接收到来自图形用户界面(GUI)、程序执行环境和模型之间的多层反馈,这帮助它及时反思和自我修正,确保优化效果。

CogAgent-9B-20241220执行指令「标题设置为CogAgent」的过程

其实早在2023年8月,智谱就已经开始了首个基于视觉语言模型(VLM)的开源GUI智能体模型——CogAgent的研发。

经过一年多的不断迭代和升级,CogAgent在2024年12月迎来了重大的版本更新,升级到了「9B-20241220」,并且成功应用在了刚推出的GLM-PC上。

值得注意的是,最新的CogAgent-9B-20241220不仅应用于自家产品,团队还为了让研究者们可以共同探索与提升GUI Agent,已经迅速进行了全面开源。

开源项目:https://github.com/THUDM/CogAgent

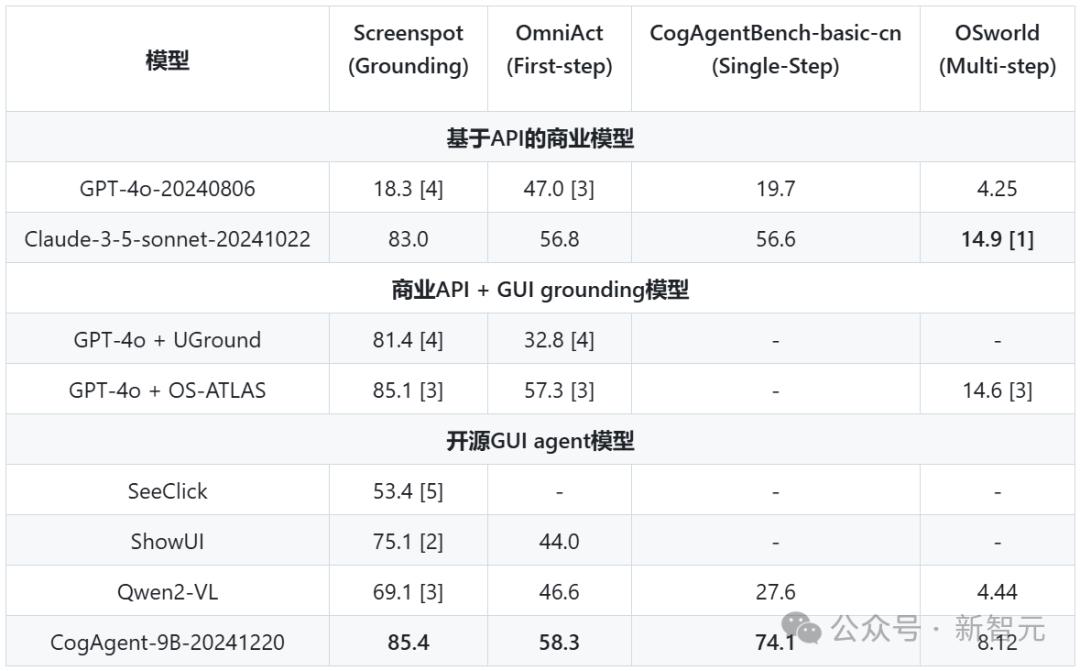

评测结果显示,CogAgent-9B-20241220模型在多个平台和多类别的GUI代理及GUI基础基准测试中,拿下了当前最佳的成绩。

CogAgent的领先表现与未来智能电脑的展望

在多个评测领域,CogAgent都展现出了相当不错的成绩。例如,在GUI定位、单步操作、中文step-wise榜单以及多步操作测试中,它都稳居前列。虽然在OSWorld的表现稍逊于针对计算机使用专门设计的Claude-3.5-Sonnet和结合外接GUI grounding的GPT-4o,但整体来看,CogAgent的表现依然值得称赞。

接下来的计划,AIPC的加入

接下来,GLM-PC将与AIPC进行深度整合,目标是让每个人都能轻松使用这些强大的功能。

据了解,智谱正在与联想、华硕等知名电脑品牌进行深入合作,探讨如何共同推动AIPC的创新与发展。

其实,AIPC不仅仅是一台普通电脑,它代表着智能助手在个人计算领域的全新应用模式。

未来的世界会更加智能。

想象一下,你的个人电脑能够完全理解你的需求,自动优化你的工作流程,甚至全天候待命,随时提供精准的智能支持。

如今,GLM-PC正在将这个美好的未来变为现实,而我们也正站在这场智能革命的最前沿。

参考资料:

https://cogagent.aminer.cn/