人工智能又有新进展!DeepSeek-OCR通过像素化处理文本,压缩比例低于1/10,基准测试中名列前茅。开源一天获得4.4k个星星,Karpathy也坐不住了,期待视觉输入的更多可能性。

DeepSeek再一次让人惊叹不已!

他们的新成果DeepSeek-OCR,可谓是一场革命——

文本不再是唯一的输入方式,视觉将主导一切!

而且,在光学字符识别(OCR)任务上,DeepSeek-OCR的表现也让人刮目相看——

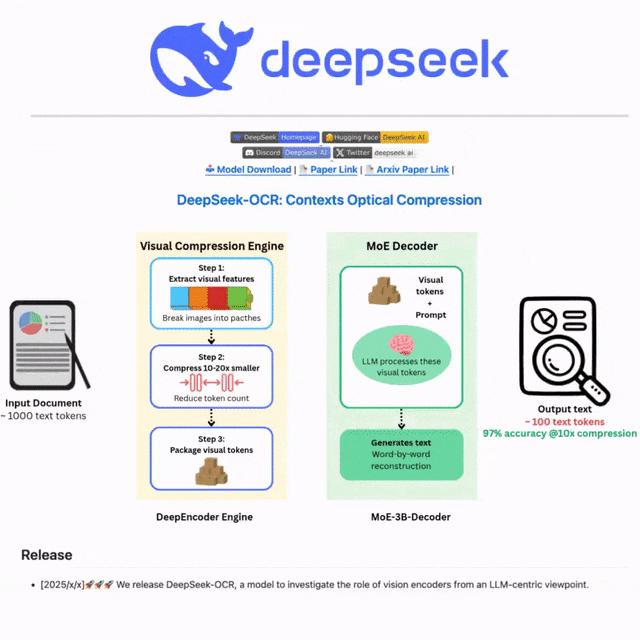

🚀在一块A100-40G显卡上,它的速度能达到每秒约2500个Token,真是飞起来了。

🧠在保持97%准确率的同时,能够将视觉信息压缩到原来的1/20,日常使用中压缩比也能轻松做到低于1/10。

📄 在OmniDocBench基准测试中,利用更少的视觉Token,它的表现甚至超过了GOT-OCR2.0和MinerU2.0。

那么,这个效果到底有多惊人呢?

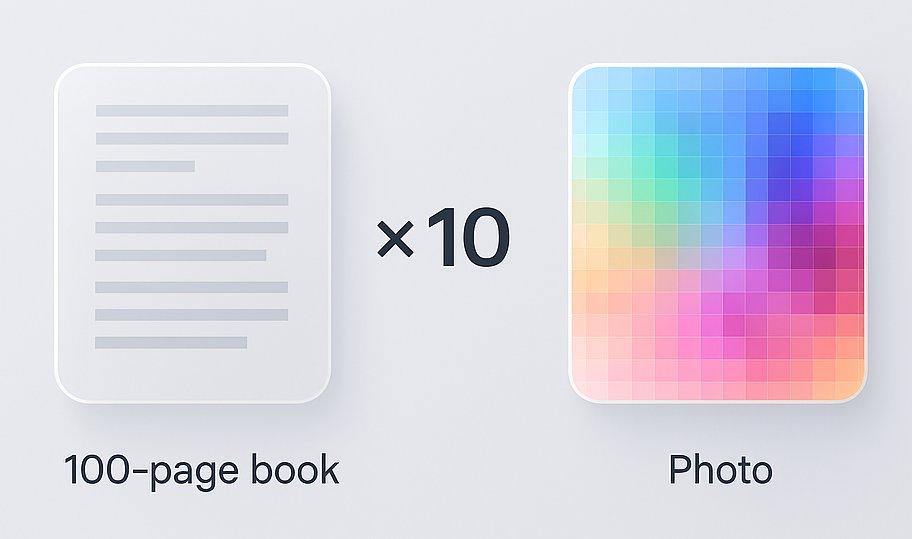

一整页密密麻麻的文字,竟然能压缩到仅100个视觉Token,在OmniDocBench上实现了最高60倍的压缩率!

DeepSeek-OCR简直就像把文字变成了像素点,仿佛是把一本100页的书浓缩成一张照片,AI依然能轻松理解。

参数少、压缩比高、速度快,还支持100种语言……DeepSeek-OCR简直是全能选手。

它不仅在理论上具有很高的价值,实际应用也相当广泛,用户的反馈更是好评如潮:

GitHub上的DeepSeek-OCR项目,吸引了4.4k颗星星🌟

说到DeepSeek-OCR这个开源项目,它的表现真的是让人刮目相看。想象一下,把一本厚厚的书简化成一张图片,AI却能轻松搞定。这款工具的参数设置简单,压缩效率高,速度也飞快,甚至能支持多达100种语言,简直是个多面手!

它不仅在理论上有着惊人的潜力,实际应用中也是大显身手,用户们对它的评价更是好评如潮。DeepSeek-OCR用真实的案例告诉我们,像缩微胶片、书籍这样实体的页面,才是训练AI模型的最佳素材,而不是那些质量参差不齐的网络文章。

特斯拉前AI总监、OpenAI创始团队成员Karpathy简直乐开了花,他对DeepSeek的新模型赞不绝口。

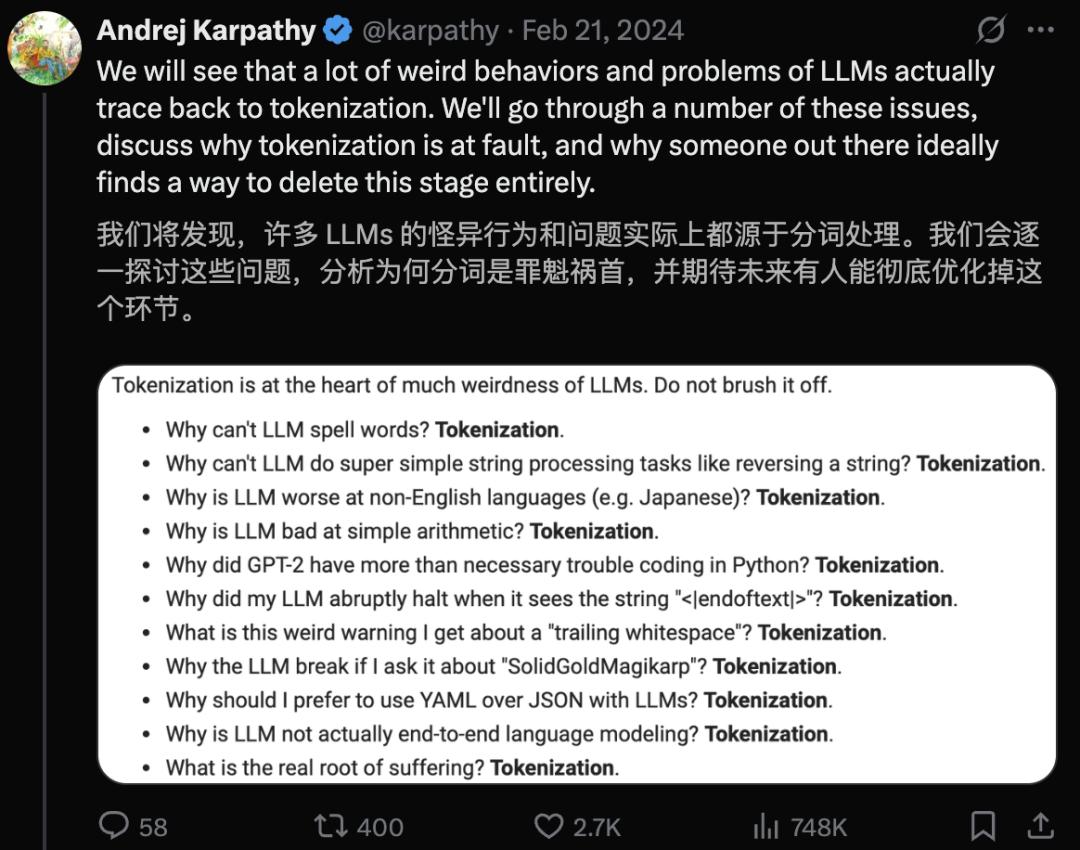

Karpathy迫不及待,早已厌倦分词器

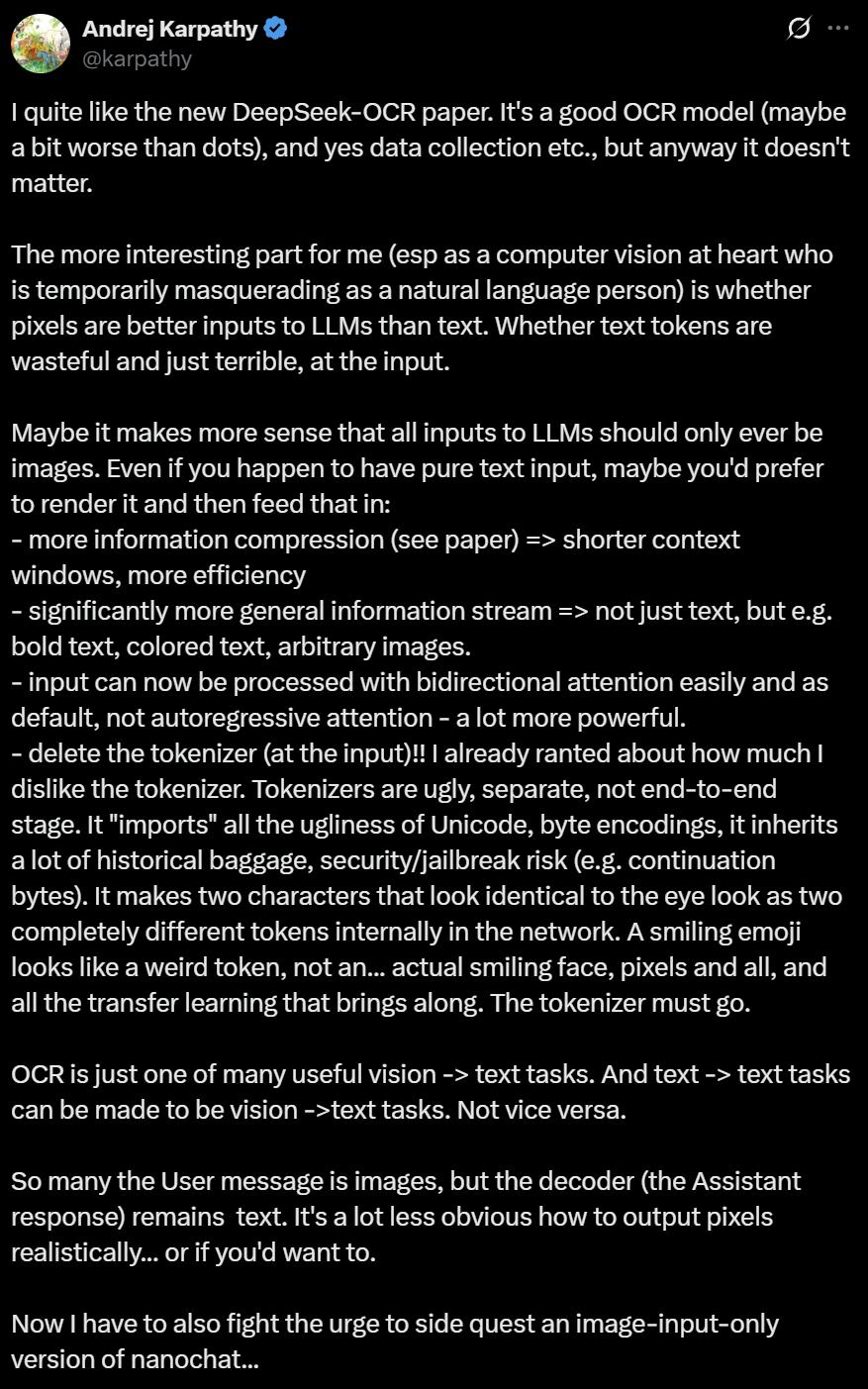

Karpathy对DeepSeek-OCR的新论文非常感兴趣。

更有趣的是,对于大型语言模型而言,使用像素作为输入真的比文本好么?文本Token是否让输入变得既浪费又低效呢?

DeepSeek-OCR正在挑战「文本主导AI的传统观念」,视觉可能会重回风口!

Karpathy自称「从骨子里就是做计算机视觉的」,不过他目前暂时在自然语言处理领域徘徊,所以对这些问题格外关注。

或许,未来的大语言模型输入只需要图像,这样的想法才更为合理。即使你手上有纯文本,先把它转成图像再喂给模型,可能效果更好:

更高的信息压缩率 => 更短的上下文窗口,高效得多。

信息流的适用性大幅提高 => 不仅限于文本,还能处理粗体、彩色文本以及各种图像。

现在的输入可以轻松且默认地用双向注意力机制进行处理,而不是自回归注意力——这可要更强大得多。

要把(输入端的)分词器tokenizer干掉!!

特别是最后这一点,Karpathy早就忍无可忍,反复吐槽分词器的缺陷——

分词器既丑陋又独立,根本不是端到端的过程。

它「引入」了Unicode和字节编码的种种糟粕,背负着沉重的历史包袱,同时还带来了安全和越狱的风险(比如连续字节问题)。

它让两个看似完全一样的字符,在网络内部变成了完全不同的Token。

比如一个微笑的表情符号😄,在大型语言模型眼里,只是个奇怪的token,而不是一个具备像素、承载丰富信息、能够进行迁移学习的真实笑脸。

总之,Karpathy坚信,分词器的问题太多,这次必须把它打发走。

而且,他还展望了视觉作为通用输入的未来:

OCR只是「视觉到文本」众多实际应用中的一种。「文本到文本」的任务也完全可以被转化为「视觉到文本」的任务,反之就不一定。

所以,用户输入的内容可能是图像,而解码器(即「智能助理」的回应)依然是文本。

至于如何真实地输出像素,或者说你是否真的想这样做,目前还没那么清晰。

现在,Karpathy表示,他正在拼命克制,不去搞一个只用图像输入的「nanochat」支线任务。

为什么图像输入对AI更友好?

有网友提问:

首先,为什么图像能轻松获得双向注意力,而文本却做不到?

再者,虽然图像没有像文本那样的「Token化」过程,但我们在将输入图像切割成一个个图像块(patches)时,难道得到的结果不也是类似,甚至可能更糟糕吗?

### 网友对Karpathy的提问与讨论

最近,Karpathy提到了一些关于文本生成的想法。他表示,理论上是可行的,但为了提高效率,通常生成文本时会采用比较简单的自回归训练方法。

想象一下,如果有一个中间训练阶段,能够利用双向注意力机制来微调那些不需要预测或生成的用户消息Token,这样会更高效。

理论上,可以对整个上下文进行双向编码,目标只是为了解析下一个Token,但这样做的缺点是训练过程无法并行化。

至于另一种观点,他认为这与“像素和Token”的关系并不大,关键在于像素是经过编码的,而Token则是被解码的。

不过,关于Karpathy提出的“nanochat支线任务论”,一些网友却不太赞同:

DeepSeekOCR的研究表明,这不仅仅是个压缩的问题,更涉及到语义的提炼。

分词器的时代意味着我们学会识字,而像素的时代则关乎我们的感知能力。

所以,Nanochat不应被看作支线任务,它实际上是“光学认知”的起点。

在评论区,网友们纷纷呼吁Karpathy:赶紧开发一个只用图像输入的“nanochat”吧!

### 马斯克的光子猜想:未来的AI将与光子密切相关

马斯克,这位Karpathy的前老板和好友,给出了一个相当科幻的预测:

从长远来看,AI模型的输入和输出中,有超过99%将会是光子。

他甚至让Grok来算了一算,已知宇宙中光子的总数量。

马斯克的光子预测:未来的AI与光子息息相关

估算可观测宇宙中光子的总数其实并不是一件简单的事情,但我们可以通过一些关键的因素来得到一个大概的数字。这些因素包括宇宙微波背景辐射(CMB)所产生的光子、来自星星的光子,还有其他一些微弱的光源。

在这些因素中,宇宙微波背景辐射(CMB)占据了绝对主导地位,因此我们可以推测,整个可观测宇宙中的光子总数大约为1.5×10⁸⁹个。这个数字虽然是个粗略的估算,但它与宇宙学的计算结果大致吻合,具体数值还会受到可观测宇宙体积和其他微小来源的影响。

哇,1.5×10⁸⁹这个数字简直让人惊叹!没有其他东西能达到这样庞大的规模,这正是马斯克思考的逻辑。

毕竟,人类自身就是一个通用的“光学计算系统”,我们的眼睛帮助我们感知这个世界:

作者介绍

这篇论文的作者有三位,分别是Haoran Wei、Yaofeng Sun和Yukun Li。

论文地址:

https://github.com/deepseek-ai/DeepSeek-OCR/blob/main/DeepSeek_OCR_paper.pdf

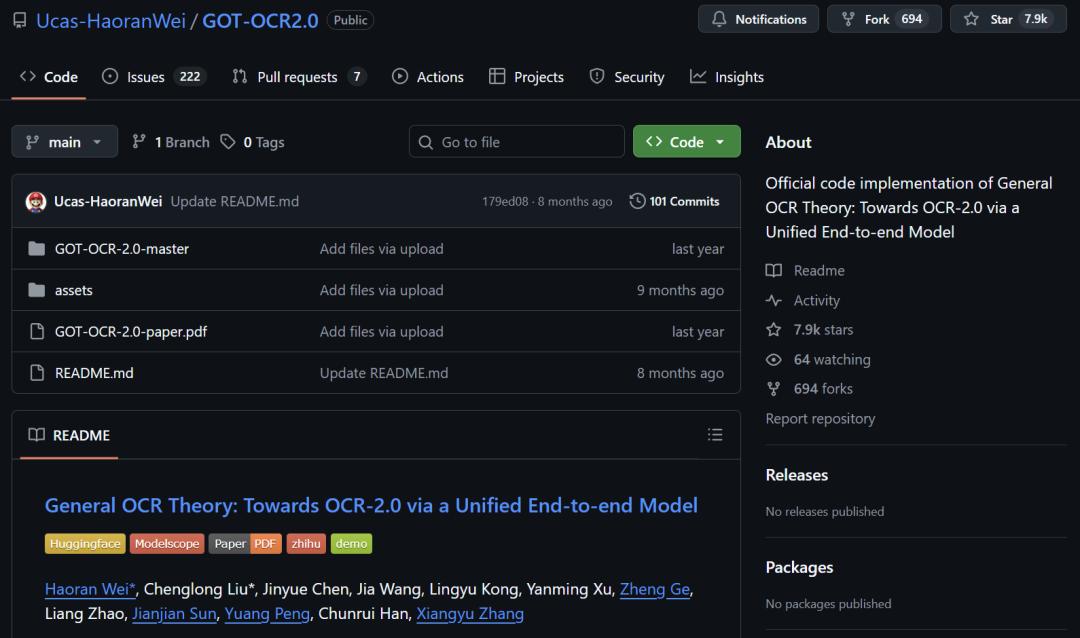

作为第一作者的Haoran Wei,之前还参与了一个在GitHub上备受欢迎的项目GOT-OCR2.0,项目名为「通用OCR理论:通过统一的端到端模型迈向OCR-2.0」。

项目地址:

https://github.com/Ucas-HaoranWei/GOT-OCR2.0

论文地址:

https://arxiv.org/abs/2409.01704

### 深入了解AI人才:Yaofeng Sun与Yukun Li

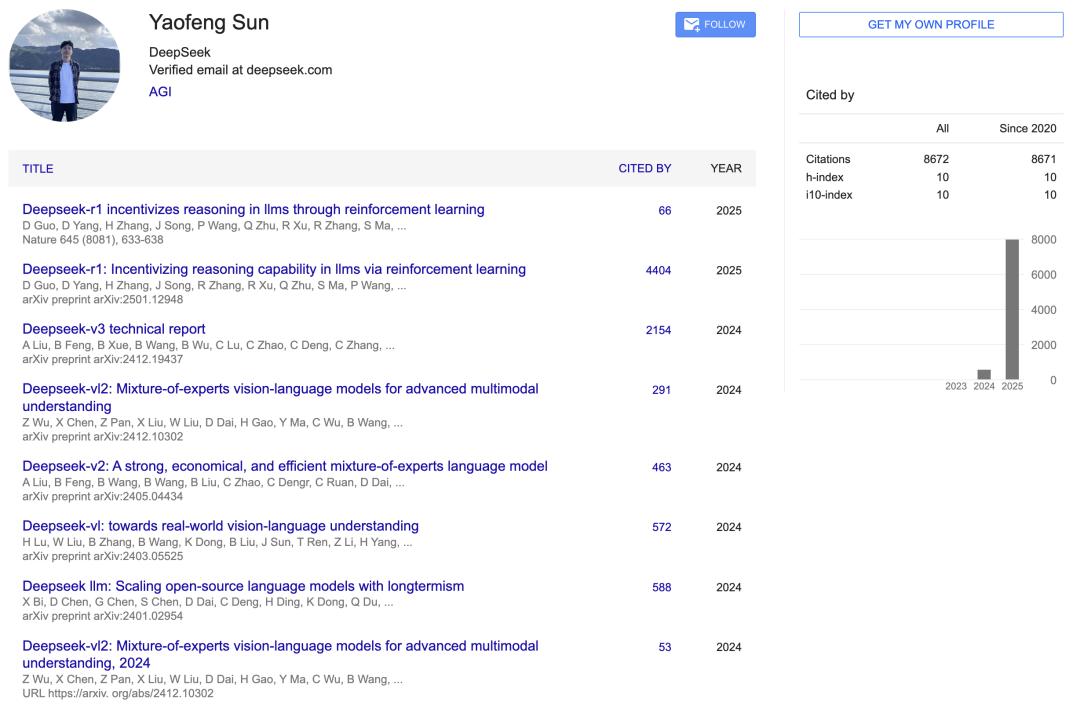

Yaofeng Sun是DeepSeek的一名软件工程师,他在2023年加入了幻方AI/DeepSeek这个大家庭。

根据谷歌学术的资料,他参与了多个模型的研究,包括DeepSeek-r1、DeepSeek-v3、DeepSeek-vl2等。

他本科毕业于北京大学的图灵班,专业是计算机科学。

在校期间,他代表北京大学参加了ACM-ICPC亚洲区域赛,并连续三年获得金牌,参赛的地区包括EC总决赛(2017)、青岛、西安、上海和南京等地。

此外,他还曾在全国信息学奥林匹克竞赛(NOI)中拿到金牌,时间是2015年和2016年。

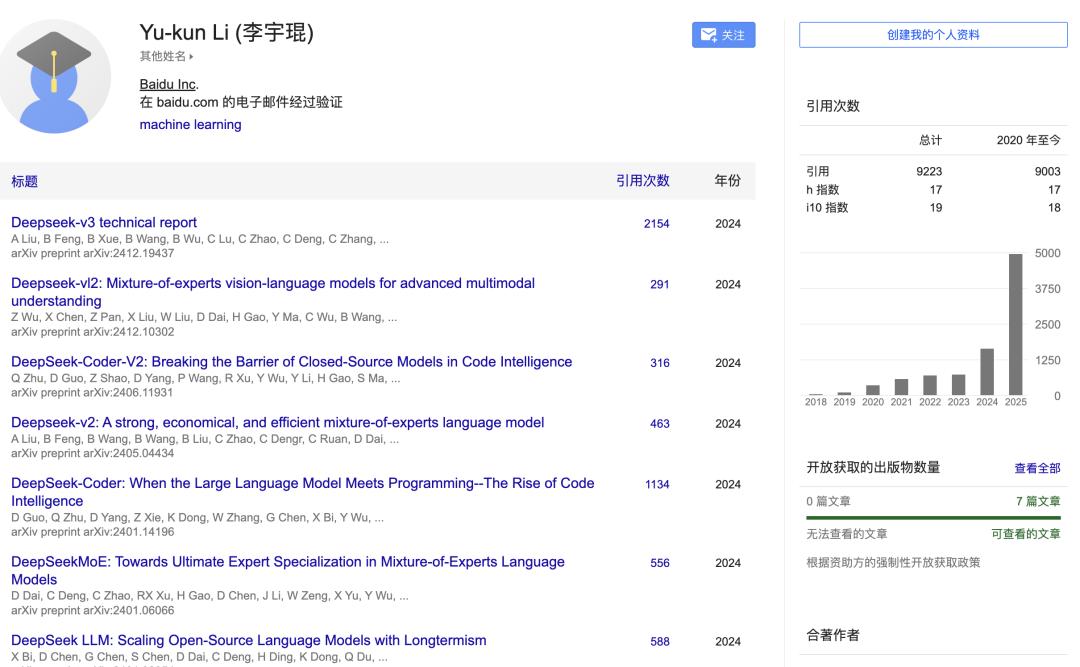

而Yukun Li同样是一位活跃的AI从业者——

自2020年以来,他的引用次数已经突破了9000,参与的项目包括DeepSeek-v3、DeepSeek-vl2、DeepSeek-v2等。

我们一同见证这些伟大的AI突破,还能亲眼目睹开源AI的快速发展!

参考链接:

https://x.com/karpathy/status/1980397031542989305

https://x.com/teortaxesTex/status/198023417556435798

https://www.linkedin.com/in/sunyaofeng/

本文由“新智元”微信公众号提供,作者:新智元,经过36氪授权发布。

DeepSeek-OCR的技术进步真是让人惊叹,能把大量文字压缩成少量视觉Token,未来的AI输入方式或许真的会全面转向视觉。期待更多应用落地!

DeepSeek-OCR的表现让我大开眼界,尤其是它的高压缩比和支持多语言的能力,未来视觉输入真有可能取代传统文本!

DeepSeek-OCR的压缩能力和速度令人震撼,视觉输入的未来展现出无限可能,非常期待它在实际应用中的表现。