我有个疑问:为什么国内的大模型总是喊着领先,但在实际编码中,程序员们却更倾向于使用 GPT、Gemini 等国外模型,而不是我们自己的模型呢?

首先,聊聊AI在编程方面的能力以及评估的难点。现在主要有三个问题:

1. 随着模型能力的增强,评估它们的方式也变得越来越复杂。现在的模型,无论是国内还是国外,能在对话交互、产品演示或简单的数据分析脚本上表现不错,这些任务的完成度差别不大。真正的挑战在于处理复杂项目和解决棘手的bug。

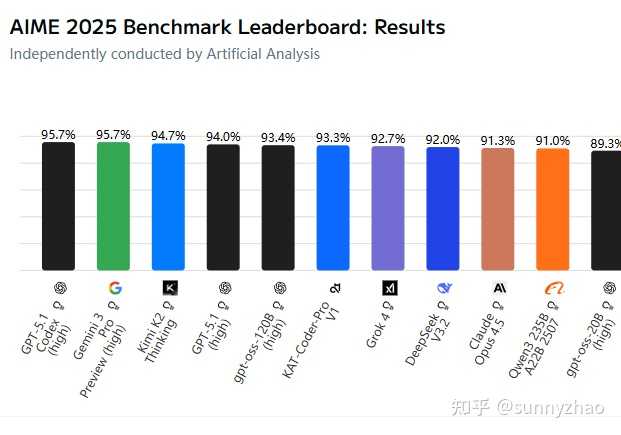

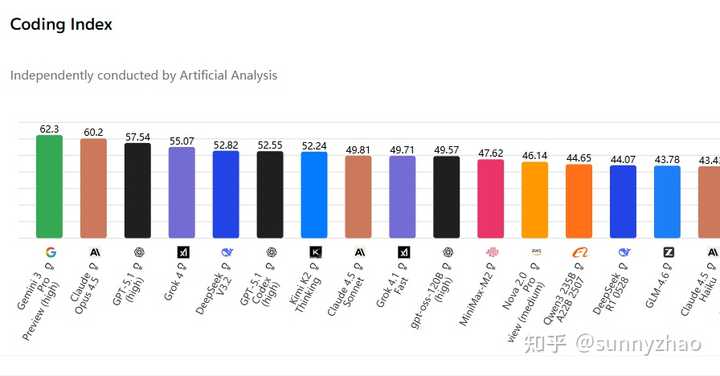

2. 性能评估的基准开始出现饱和问题。就拿MMLU来说,当它的分数达到饱和后,新的MMLU-Pro几乎所有模型的分数都突破了80。而在AIME2025的榜单上,已有10个模型的分数超过90。所以光看某个评测的分数,已经无法真实反映模型间的差距。

3. 测评场景和实际应用场景之间有很大不同。特别是在编程方面,模型训练的数据大多来源于开源代码的issues和pr,这些问题通常是局部的,而真实场景面对的挑战更为复杂。再加上目前强化学习的训练成本高,针对真实问题的训练方案还不够成熟,模型在解决真实编程问题时的表现比较薄弱。

基于以上几个因素,我们可以从两个角度来分析,为什么国产模型在实际应用中不如国外模型普遍受欢迎。

首先,模型能力的差异是根本原因。在评估编程能力的基准中,swe-bench verified是专门用于处理真实github issues的评测,这是衡量模型编程能力的重要基准(不过这个评测实际上只有500个经过人工验证的样本,覆盖面有点小)。目前得分最高的是claude opus 4.5(80.9),接下来是claude-sonnet-45(77.2)、gpt-5..1(76.3)和gemini-3-pro(76.2),而国内模型中表现最好的DeepSeek-v3.2得分为73.1,其他国内模型的排名依次是kimi-k2 thinking(71.3)、qwen3-max(69.6)、minimax-m2(69.4)和glm-4.6(68.0)。可以看出,国内模型与国外75+的模型之间还是有不小的差距。

再看看综合的scicode(科学编程)、livecodebench(新兴的竞赛编程)和terminal-bench-hard(复杂终端编程)测评,前四名全是国外模型(得分均在55以上),而DeepSeek-v3.2(52.82)排名第四,也算是个不错的成绩,超过了gpt-5.1-codex(高)。所以,通过评测真实编程任务的成绩,可以比较直观地判断出能力差异。

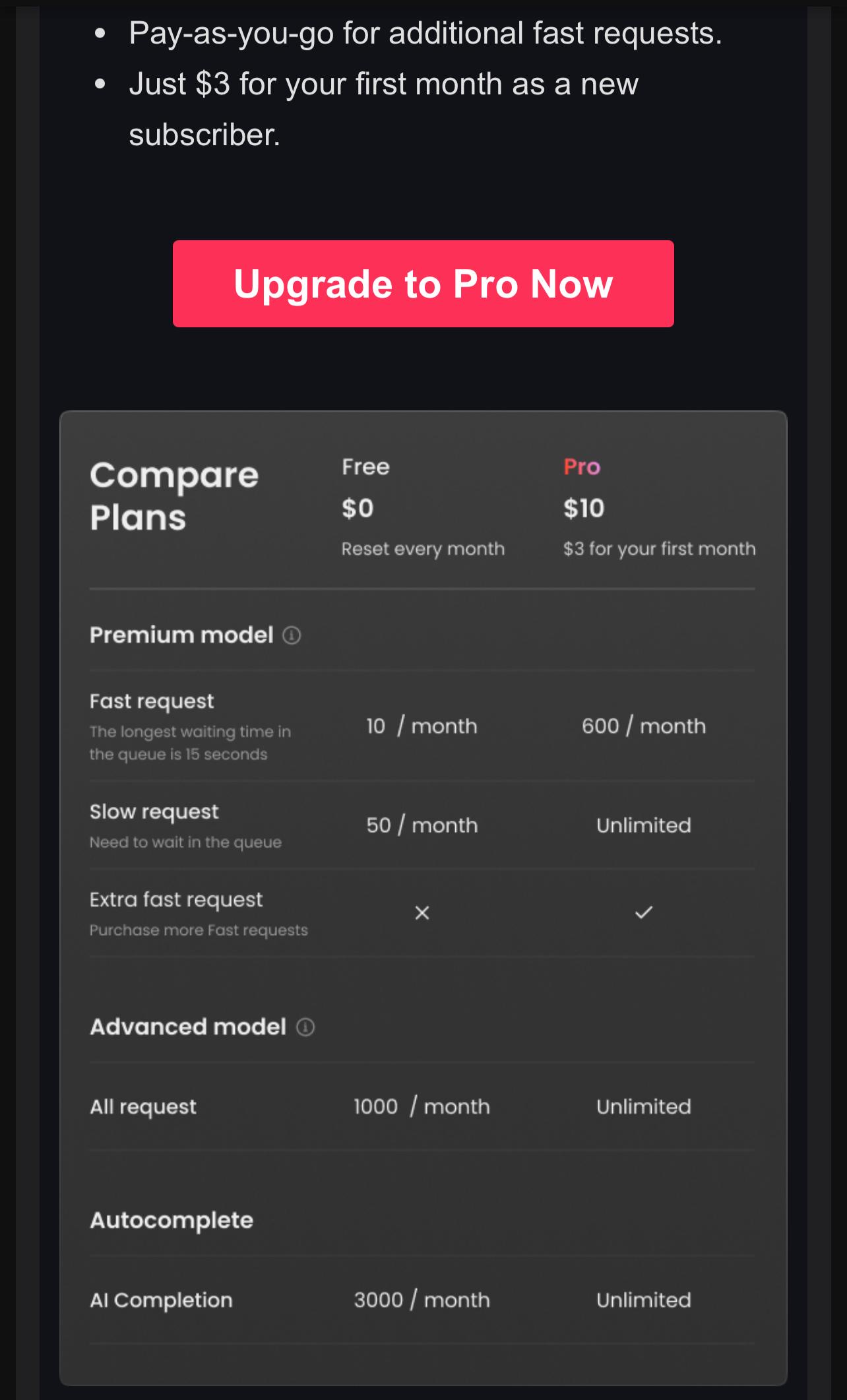

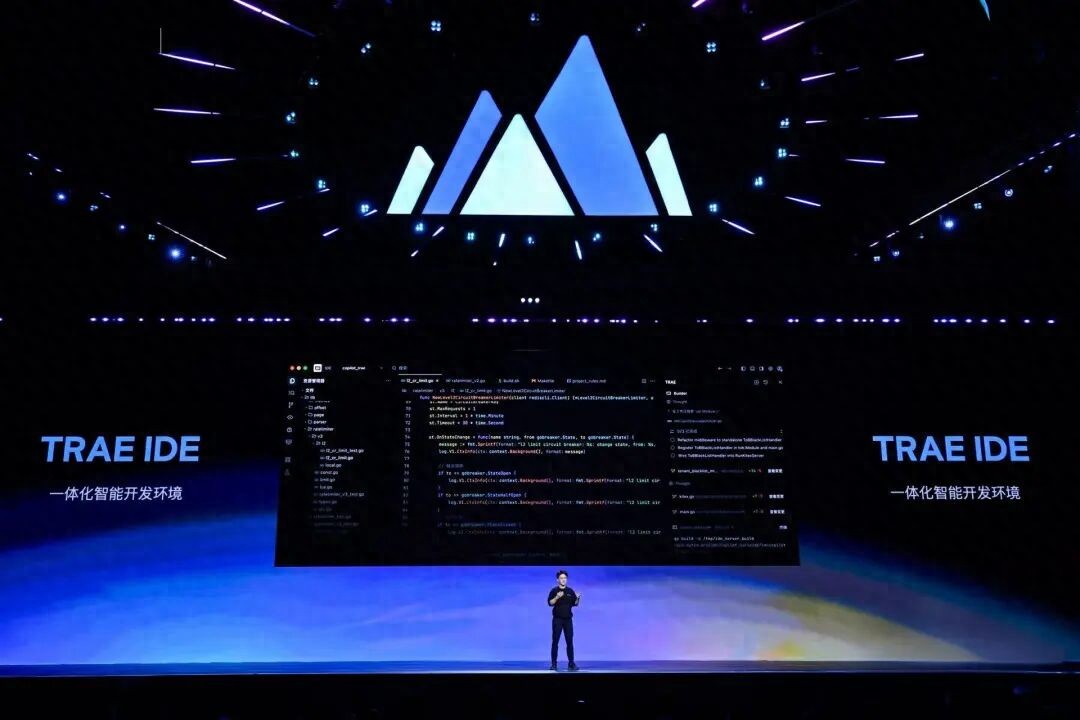

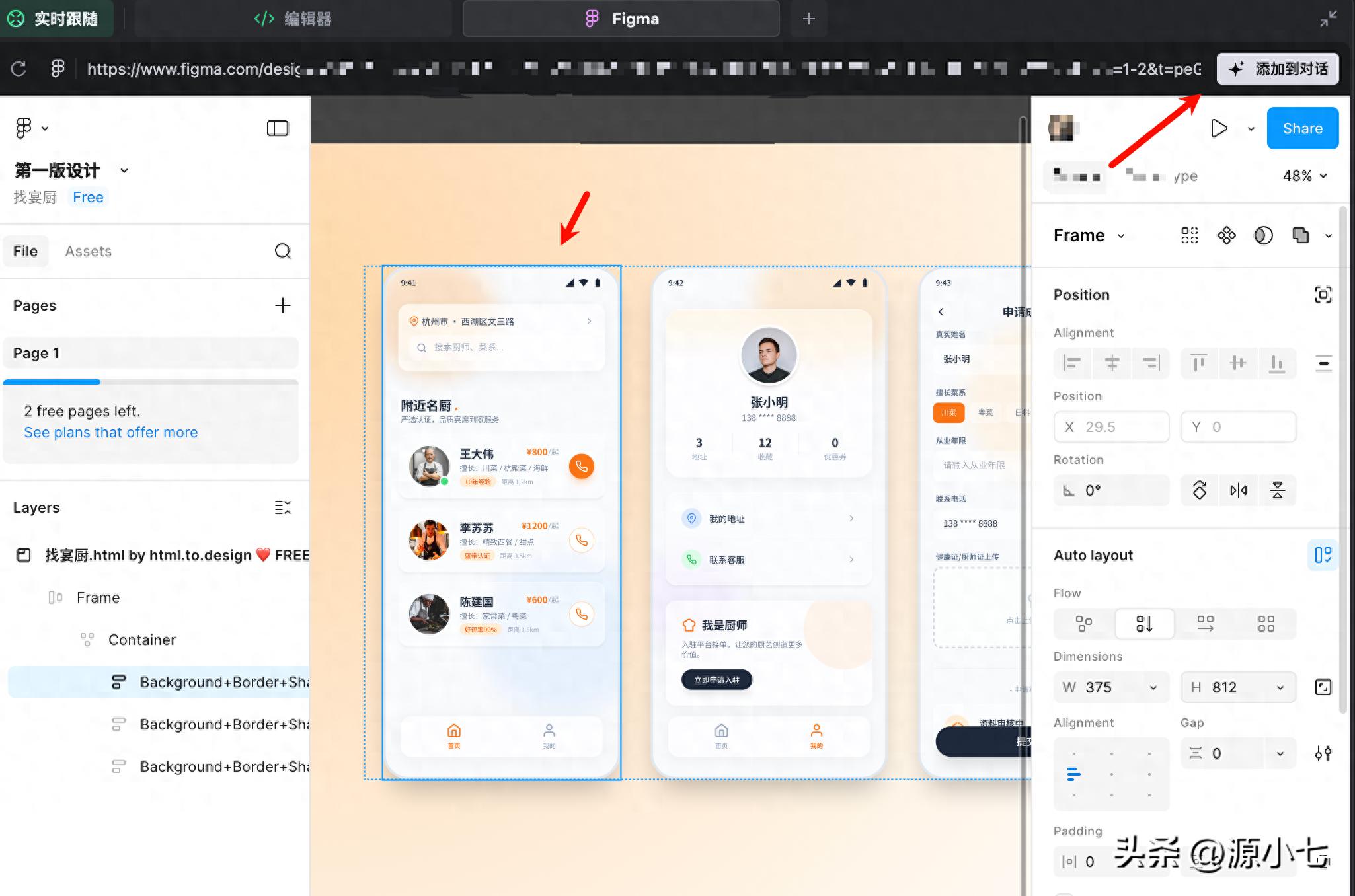

第二个问题是技术栈和生态的差距。claude和codex很早就开始建立自家的命令行编程工具,而国内的qoder、atra和codebuddy等工具都是最近三个月才发布的。在编程场景的经验积累、产品优化和强化训练方面,国内确实存在一些后发劣势,仍需不断追赶。

总的来说,虽然大部分模型在处理简单编程问题时都没什么问题,但即使是最前沿的模型在应对复杂编程任务时的能力也还不够。而国内模型在代码生成方面依然和国外顶尖模型存在差距,但这个差距正在逐渐缩小。

有时候用国内模型也会遇到一些意想不到的问题,尤其是在处理特定语法时,效果不如预期。

看到国内模型在评测中落后,心里有点失落。其实我们应该加大对开发者的支持,才能逐步缩小这个差距。

看到国内大模型的能力差距,真心希望能有更多的资源投入到研发中。

看到这些评测数据,真心希望国内开发者能多些勇气和耐心,慢慢会有突破的。

有谁能分享一下使用国内模型的具体体验吗?我对它的实际应用效果很感兴趣。

目前国内模型在复杂项目上表现不佳,看来还需要更多的实战训练和经验积累。

使用国外模型的程序员们,真的有谁尝试过国内的?效果如何呢?

有谁试过国内模型的命令行工具?效果如何?感觉这方面的积累还不够。

国内模型的命令行工具是不是有点晚了?感觉已经落后国外很多了。

文章提到的评测基准真的有点小,如何能更全面反映模型能力呢?