最开始Cursor就像是个粘合剂,而现在它的Cursor2.0已经拥有了自己的编程模型。

不过,这也只是杯水车薪,因为在编程AI的领域,目前最强的竞争者依然是GPT和Claude。

TRAE虽然不如Cursor,但因为有Claude和GPT的支持,也能分到一杯羹。

这一切发生在Claude Code和GPT5-Codex还未问世的时刻。

如今,随着Claude Code和GPT5-Codex的推出,AI编程正逐渐用原生的大模型来击败那些依赖外壳和粘合剂的编程工具。

目前,GPT还在继续供货,因为缺钱的缘故,但只要它能保持领先并盈利,GPT和Gemini也有可能会停止供货。

不仅是Claude在努力,GPT也希望能继续独占市场。

而Claude因为不受地域限制,最重要的是它已经有了自信,不再需要依赖其他编程产品进行推广。

它完全可以靠自己。

在AI编程中,最大的挑战就是Tokens的高成本。

任何AI编程都避不开这种高成本的Tokens。

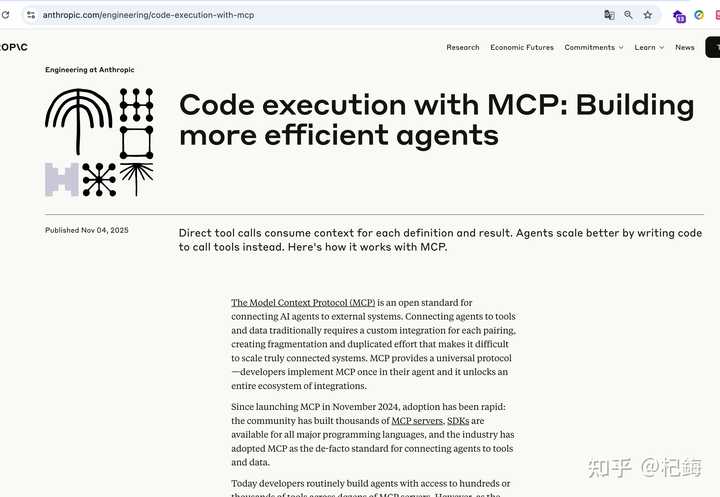

从Claude的角度来看,11月Claude Code已经实现了突破,原本需要150K Tokens的任务,现在只需2K Tokens就能完成。

成本直接降低了98%!

前几天我看到Anthropic发布的新技术指南,老实说,看完第一遍我简直无言以对。

150,000个tokens直接降到2,000,这可不是简单的优化,而是降维打击啊!

这甚至比Deepseek的3.2降价还要震撼……

既然自己都能做到,为什么还要为别人辛苦呢?

说真的,这可能是2025年我见过的最牛的AI Agent优化方案。

我之前做的那些多工具Agent项目,API账单简直让我心惊——一个月居然高达$360,000,这可真是让人无法承受。

现在,Anthropic直接把这个成本降到了$4,800,节省了98.7%。

而且响应时间也从20秒缩短到了5.5秒。

以往的做法是把AI模型当成数据中转站,所有中间数据都要经过上下文,这不是自掘坟墓吗?

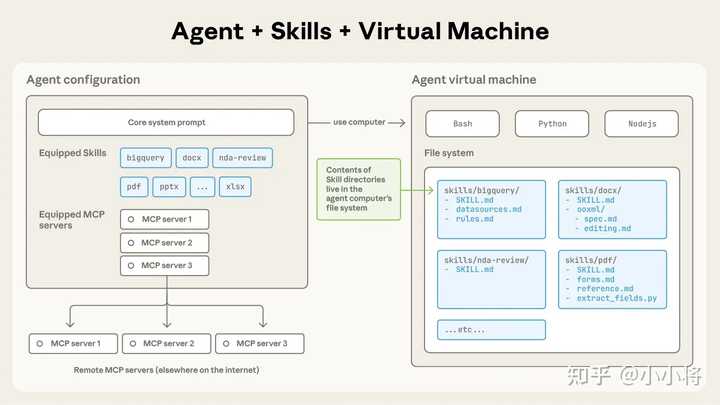

这次,Anthropic直接把数据处理放到了执行环境中,模型只负责生成代码和获取结果,决策层和执行层彻底分开了。

看完之后,我总结了三个最牛的点:

- 环境内处理 – 中间数据根本不进模型,Tokens直接省了99%+

- MCP代码API化 – Agent变成了程序员,想要什么工具自己import

- 真金白银的验证 – 不是空谈,生产环境月省$355,200

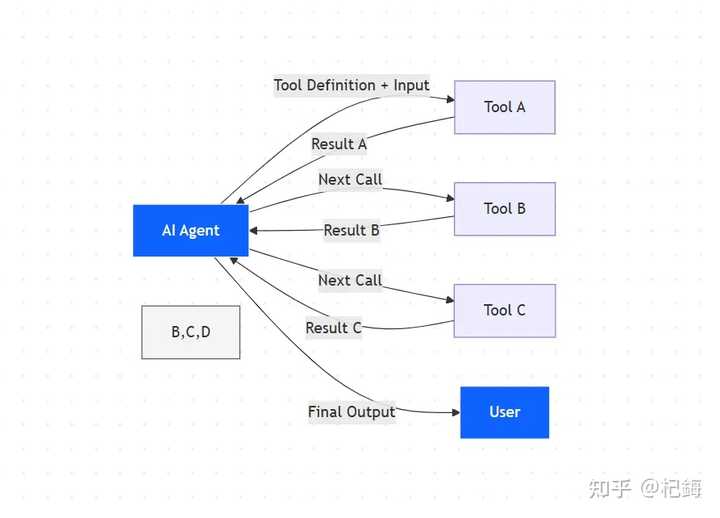

搞过多工具Agent的朋友都明白,现在的问题根本不是优化能解决的,而是架构性bug。

你想要功能齐全,就得接一堆工具;想省Tokens,就只能牺牲功能。

这不是选择题,而是个死循环。

说实话,企业级Agent没有50到200个工具根本无法运转。

数据库查询、发送邮件、对接Salesforce、Slack协作、GitHub集成,这些都是必备的。

我之前的项目,光是工具接入就花了两个月的时间。

更麻烦的是调用频率。

一个复杂的工作流动辄需要10-30次工具调用,链式依赖那个让人心累——工具A的输出给工具B,B的输出再给C,每次都要在上下文中传来传去。

传统架构无法并行,只能老老实实串行执行,眼睁睁看着延迟不断增加。

调用次数和成本的关系:

| 任务复杂度 | 调用次数 | 数据量 | Token消耗 |

|---|---|---|---|

| 简单任务 | 3-5次 | 2K-5K | |

| 中等任务 | 10-15次 | 10-50KB | 20K-50K |

| 复杂任务 | 20-50次 | 100-500KB | 100K-500K |

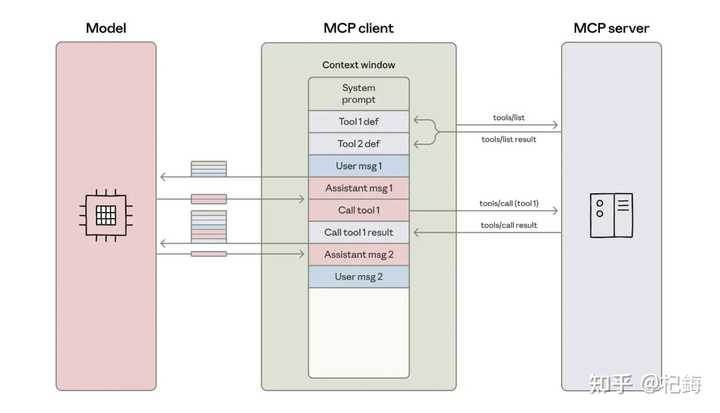

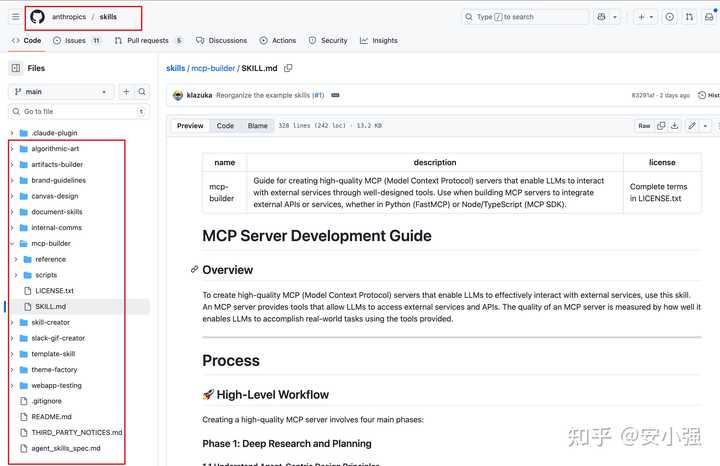

MCP (Model Context Protocol)协议的出现确实是个好消息,它统一了工具接入的标准。

以前每个服务都要搞独立的SDK、认证和数据格式,现在用JSON Schema来定义工具签名,list_tools() API自动发现工具,省了不少麻烦。

但是!

MCP虽然解决了接口碎片化的问题,理论上想接多少工具就接多少,实际上还是被上下文窗口限制得死死的。

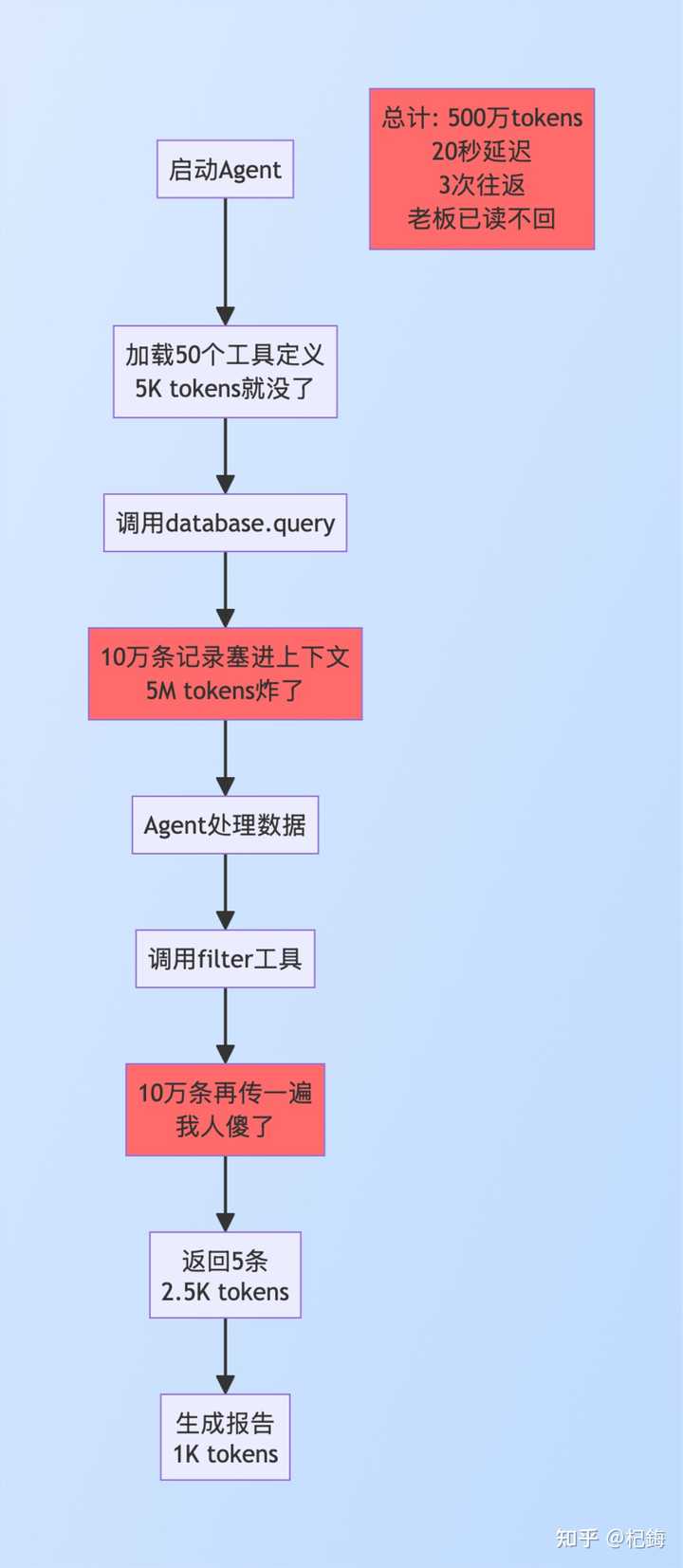

比如说搞个项目需要从10万条记录中筛选出5条生成报告。

传统方式的流程真是个天坑:

阶段1 – 工具定义预加载:

- 50个工具定义全都塞进上下文

- 还没开始干活呢,5,000 tokens就没了

- 我当时就觉得不对劲

阶段2 – 数据检索(这里是重灾区):

- Agent调用database.query()

- 100,000条记录 → 全部进上下文

- Token消耗:100,000条 × 50 tokens = 5,000,000 tokens

- 延迟:序列化、传输、解析,15秒跑不掉

- 问题是:10万条里99,995条都是垃圾数据,全都进上下文了

阶段3 – 数据过滤:

- 调用filter()工具

- 10万条数据再传一遍(没错,又得传一遍)

- 返回5条结果

阶段4 – 生成报告:

- 终于只传5条了

- 但前面的已经爆炸了

总账单:

- Token:5,006,000(约500万)

- 往返:3次

- 延迟:20秒

- 最搞笑的是:10万条数据走了一圈,真正有用的仅有5条

流程为:

这说明了什么呢?

传统架构把AI模型当成数据总线,所有数据都得经过模型这一关。

模型既要做决策,又要当搬运工,Tokens的消耗和数据量成正比,这能不炸吗?

工具定义预加载是第一个大坑。Agent一启动就要把所有工具定义塞进去:功能描述、参数说明(类型、必填项、默认值、验证规则)、返回格式、2-3个使用示例。

50个工具算下来:50 × 100 tokens = 5,000 tokens的基础开销。但规模效应是最恶心的:

200个工具直接就得20,000 tokens起步。

更搞笑的是工具利用率。

统计下来,单次任务平均只用3-5个工具,利用率仅有2.5%。

这意味着97.5%的工具定义tokens纯粹是浪费。

为什么不能按需加载呢?

因为传统架构要求预先声明所有工具,模型得”看到”所有选项才能选择。

中间结果的传递:数据重复传输的天坑。

Salesforce的真实案例:

# 传统方式的痛苦旅程——每次调用都是折磨

首先,我们得从搜索开始。调用一次工具,想查找“活跃账户”,结果一出来就是1000条记录,整整20,000个tokens,看了真让人心疼。

接下来是过滤步骤。又一次调用,重复传输20K tokens的数据,条件是“收入超过100万”,结果只筛选出50条,消耗了2,500个tokens。

最后一步是汇总。又得把经过过滤的数据传过去,最终的结果耗费了500个tokens。这样算下来,光是这三次调用就用了51,000个tokens,我看得心里直打鼓。

而且每次往返都要500毫秒,三次加起来简直就是在网络上无谓浪费1.5秒。而且数据序列化也有隐性成本。原本1KB的数据转成JSON格式,居然要膨胀到1.5到2KB,真是让人无奈。

而且模型还得花时间去理解这个JSON的结构。Anthropic提出的解决方案其实很直接:不再优化,而是直接换个架构。模型的角色从工具的使用者变成了代码的编写者。MCP服务器不再是函数调用的接口,而是代码模块。

听起来好像简单,但实际上实现起来可不容易:模型不再执行工具,而是生成执行工具的代码。代码在独立的环境里运行,数据处理也都是在这个环境内完成,模型只需接收最终结果。

MCP服务器转变为代码API,从函数调用变成了模块导入,这个变化可不小。

看看传统方式,每次调用都像是在经历一场灾难:

“`javascript

agent.call_tool(“search”, {query: “…”})

“`

而现在,代码执行的方式就简洁多了:

“`javascript

import { search } from ‘mcp-server’

“`

技术实现方面,TypeScript和Python都支持哦!TypeScript的版本看起来就像这样:

“`typescript

// mcp-servers/salesforce/index.ts

export class SalesforceClient {

async search(params: SearchParams): Promise {

const results = await this.api.query(params);

return results;

}

async update(id: string, data: object): Promise {

return await this.api.update(id, data);

}

}

“`

Python版本也不落后:

“`python

# mcp_servers/salesforce/__init__.py

from typing import List, Dict

class SalesforceClient:

def search(self, query: str) -> List[Dict]:

results = self._api_call(query)

return results

def filter_high_value(self, records: List[Dict], threshold: float) -> List[Dict]:

return [r for r in records if r[‘revenue’] > threshold]

“`

类型提示功能真是太棒了,IDE自动补全、类型检查、文档悬停,开发体验直接提升。async/await也原生支持,提升了并发性能。

再说说按需加载的懒加载机制,真的能节省不少token!传统方式是预加载50个工具,消耗5K tokens,而新的代码执行方式只需导入2个工具,竟然是0 tokens。你没听错,0 tokens,因为导入语句不占用模型上下文!

动态导入的实现方式也很灵活:

“`javascript

const toolName = determineRequiredTool(task);

const module = await import(`mcp-servers/${toolName}`);

const tool = new module.Client();

“`

说到工具发现API,这个设计真是聪明:

“`javascript

async function search_tools(query: string): Promise {

// 轻量级元数据,每个工具

tool.tags.includes(query) ||

tool.description.includes(query);

return matches.sort(byRelevance).map(t => ({

name: t.name,

summary: t.summary

}));

}

“`

元数据索引在启动时构建,后续查询响应时间仅需10毫秒,性能真是拉满。

具体应用场景也很实用,比如Agent要“发邮件”,调用`search_tools(“email”)`返回3个邮件工具,选一个“Gmail Sender”后,只加载这一个工具,其余的完全不受影响。

工具选择的逻辑是:描述匹配度 + 历史使用频率 + 上下文相关性。

Agent的角色变了,模型从执行者变成了编排者,生成代码但不执行工具调用。为了保证代码质量,这里也有一些措施:

– ESLint、Pylint自动检查语法

– TypeScript/Python类型系统做类型校验

– 代码模板库复用最佳实践

模板库能减少错误,比如数据库查询的标准模板和API调用重试模板,都是经过验证的。

最后,执行环境的数据处理还是在内部完成,确保数据不出环境。

安全方面,架构上采取了沙箱、资源限制和实时监控的策略。

沙箱技术结合Docker和seccomp多层防护,确保网络隔离,只能访问MCP服务器,其他外部连接全禁。同时,文件系统也是隔离的,代码库只读,只有`/tmp`能写,避免破坏。

资源配额也明确规定,CPU限制在2核,内存限制4GB,执行时间60秒超时,超时会用SIGALRM信号强制终止,内存溢出也有cgroup限制,保护宿主机。

核心技术在于数据流的重定向!通过以上的改写,我们能清晰看出Salesforce案例的改进效果,真是对比强烈!

让我们聊聊Salesforce的高效数据处理方法

// 这段代码是个小能手,简单明了

import { salesforce } from 'mcp-servers';

async function getSalesforceSummary() {

// 第一步:数据获取(这部分模型可不知道)

const results = await salesforce.search({

query: "active accounts",

fields: ["name", "revenue", "status"]

});

// 环境中有1000条记录

// 但模型对这些数据毫不知情

// 第二步:数据过滤(在环境中使用原生JS)

const filtered = results.filter(record =>

record.revenue > 1000000

);

// 这时候只剩下50条了,环境内存里

// 模型依旧没察觉

// 第三步:聚合计算(用原生的reduce和sort)

const summary = {

total_accounts: filtered.length, // 统计数量

total_revenue: filtered.reduce((sum, r) =>

sum + r.revenue, 0), // 收入总和

top_account: filtered.sort((a, b) =>

b.revenue - a.revenue)[0] // 找出收入最高的账户

};

// 第四步:返回结果(只给模型这个小对象)

return summary;

// 模型最终接收到的就是:

// { total_accounts: 50, total_revenue: 150000000, top_account: {...} }

}

// 消耗的Token:大约100(仅这个summary对象)数据流向一览:

数据库 → 环境内存(1000条,模型不可见)

↓ 过滤操作

环境内存(50条,模型不可见)

↓ 计算聚合

环境内存(summary对象)

↓ 返回

模型上下文(仅summary,~100 tokens)执行时间统计:

- 数据库查询:2秒

- 环境内过滤:0.05秒

- 环境内聚合:0.05秒

- 总计:2.1秒

Token节省:1000条数据没有被序列化,50条没有传输,最终只返回了summary。51K → 100 = 节省99.8%。

在内存管理上,我们能处理100K条记录而不会让模型察觉。数据结构的选择也很重要:JavaScript数组、Python列表都是性能优越的选择。

如果处理超大数据集,可以用Generator逐条处理,避免一次性加载:

function* processLargeDataset(data) {

for (let item of data) {

yield transformItem(item); // 一条一条处理,节省内存

}

}想实时监控内存使用情况,可以这样做:

const memUsage = process.memoryUsage();

if (memUsage.heapUsed > threshold) {

// 内存快撑不下了,切换到流式处理

}将50次调用合并为1次(这个优化太给力了)

// 传统方法:50次调用 = 50次往返 = 25秒的浪费

// 代码执行:用一个循环搞定

const results = [];

for (let i = 0; i 进阶的并发处理:

// 50个并发请求,0.5秒搞定

const results = await Promise.all(

items.map(item => processItem(item))

);并发控制以防服务器过载:

import pLimit from 'p-limit';

const limit = pLimit(10); // 最多10个并发请求

const results = await Promise.all(

items.map(item => limit(() => processItem(item)))

);错误重试以增强容错能力:

async function retry(fn, times = 3) {

for (let i = 0; i 效果对比:真金白银的数据分析:

Token节省率的计算:

延迟改进:

Claude这一招,真是优势明显啊!

现在你也能自己搞定,不用再指望别人帮忙了……

1. Token效率:成本直接降低到一半又一半

不同规模的真实成本对比,这个表格让很多老板心疼!

实施成本一览:

- 环境搭建:$50K(一次性费用)

- 每月维护:$5K

中型企业的回本0.14月 ≈ 3.6天

3年总拥有成本(传统 vs 代码执行):

传统方式:$360K × 36 = $12.96M

代码执行:$50K + ($4.8K + $5K) × 36 = $402.8K

3年节省:$12.96M – $403K = $12.56M(节省高达96.9%)

2. 渐进式工具发现:彻底告别预加载

search_tools的完整实现,这个API设计真是太巧妙了!

标题:让数据处理变得轻松:一步到位的高效工具

“`html

我们来聊聊元数据索引结构吧!你知道吗,其实它的设计非常简单易懂。举个例子,像是工具的名字、分类、标签、描述和摘要等信息,都可以通过一个简单的接口来管理。

首先,我们需要加载一份轻量级的索引,假如有200个工具,每个工具占用50个tokens,那么总共只需要10K的tokens,这样的加载只需做一次,真是省心。

接着,我们就要进行关键词匹配了。其实就是通过筛选,找出那些标签或描述中包含你输入的关键词的工具。这样一来,能快速锁定相关工具。

然后,我们会用TF-IDF来计算相关性。可以理解为给每个匹配的工具打分,越相关的工具分数就越高。这样,我们就能基于得分来排序了,相关性和流行度结合,得出最符合你需求的工具。

最后,我们只需要返回前10个最符合的工具,简单吧?

说到相关性的计算,实际上就是把查询的关键词拆分成单词,然后逐个对比。比如工具的名字、摘要、标签中有没有这些词,匹配得越多,分数就越高。这样一来,评分就出来了。

在启动时,我们会构建一个倒排索引,查询的速度可以快到10毫秒,简直快得让人惊讶!

这个倒排索引其实是一个映射关系,能够把工具的标签和描述中的每个词都与相应的工具名关联起来。这样一来,查询的时候只需找出相关的工具名就行,效率极高。

谈到Token的对比,这里真的是省得让人咋舌。传统方式加载200个工具需要20K tokens,而使用search_tools返回3个匹配结果只需150 tokens,动态导入的import语句甚至是0 tokens,整体节省达到了惊人的99.25%!

接下来,我们说说大数据处理的问题,数据量大也不怕了!

从性能曲线来看,数据量越大,优势就越明显。性能的拐点出现在100行,其实小于50行时传统方式反而更简单,但一旦超过100行,代码的执行速度就能胜出。

在数据处理策略上,我们会根据数据源的大小来动态选择处理方式。

构建数据管道时,我们采用链式操作,确保内存使用峰值低。比如数据清洗、格式转换、聚合和指标计算都可以通过这种方式来完成。

对于超大数据,我们还可以使用流式处理。这样,数据源中的每一批次都可以逐步处理,确保内存使用可控。

处理100K行的数据时,内存峰值只需500MB,而不是全量加载的5GB,这可真是大大减轻了负担。

除此之外,还有很多优势,比如编程控制流的灵活性,循环、条件和错误处理都是原生的,调用次数从50次减少到1次,延迟也降低了25倍;隐私安全方面,敏感数据不会进入模型,GDPR、HIPAA合规也没有压力;状态持久化和检查点机制支持长任务跨会话处理,3小时的任务可以拆分成3次来执行;团队效率也因此提升了3到5倍,这些都是不容忽视的好处呢!

“`

Claude最近的创新真是让人刮目相看,特别是Tokens成本的巨大降低,实在是个颠覆性的进展。

从文章看,Claude和GPT在市场上的竞争越来越激烈,未来的AI编程领域将会更加精彩。

Claude的技术突破让人惊叹,Tokens成本的降低实在是个好消息,未来的开发效率将大大提高。

看到Claude Code的优化方案,感觉AI编程的未来充满希望,尤其是高效与低成本的结合。

这次Claude的创新确实让人耳目一新,特别是将数据处理放到执行环境中的做法,真是解放了模型。

文章提到的架构性问题很有道理,现阶段AI编程的挑战依旧巨大,期待Claude能持续推动行业进步。

Claude的优化方案真是令人震惊,特别是Tokens成本的降低,未来的AI开发将更加高效。

看到Anthropic的技术进步,觉得AI编程的架构问题确实需要重新审视,期待更多突破。

Claude Code的创新让人兴奋,特别是中间数据不再通过模型处理,这样的思路很值得借鉴。