文心大模型4.0 Turbo正式上线,用户数量也突破3亿!

据智东西6月28日的报道,今天在2024年WAVE SUMMIT深度学习开发者大会上,百度正式推出了文心大模型4.0 Turbo,同时也在网页和API接口上同步上线,App版本也会很快跟上。

▲文心大模型4.0 Turbo API开放

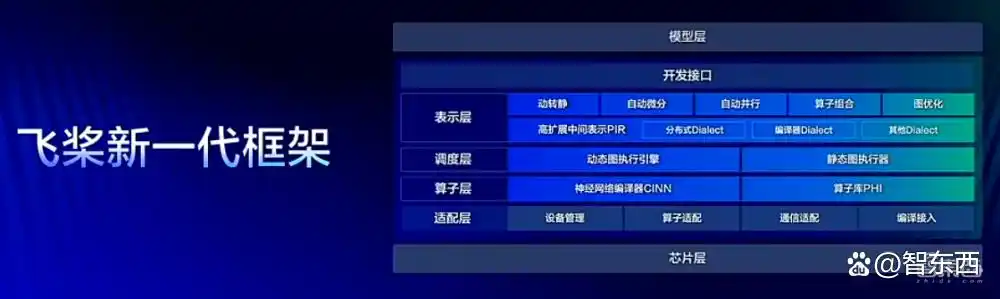

同时,飞桨平台也发布了新一代的飞桨框架3.0 Beta版本,带来了大模型训练和推理的一体化、动态与静态自动并行、编译器自动优化等多项新特性,非常值得期待。

另外,百度的智能代码助手Baidu Comate也升级到了2.5版本,开发和业务迭代速度有了显著提升,新的中文名“文心快码”也正式加入了百度的“文心大家族”。

百度的首席技术官王海峰透露,文心一言的用户已经超过3亿,每天的调用量更是超过5亿;而飞桨平台的开发者人数也达到了1465万,服务了37万企业,构建了超过95万个模型。

一、用户规模突破3亿,文心大模型4.0 Turbo上线

经过多年的演变,AI技术已经从早期的人工规则撰写,经过统计机器学习,发展到如今的深度学习和大模型时代,算法和模型变得越来越通用和统一。

王海峰提到,大模型技术为AGI(通用人工智能)带来了新的希望,可以从两个方面来理解:一是AI技术变得更加通用,二是AI能力的全面性,包括理解、逻辑推理、内容生成和记忆等多个方面。

百度又出大招!文心大模型4.0 Turbo来了

2019年3月,百度首次推出了文心大模型1.0,经过几轮更新,现在已经来到了4.0版本,去年10月正式发布。说到用户,文心一言的用户总数早已突破了3亿,每天的调用次数也达到了5亿次,真是个庞大的数字!

今天,百度又带来了文心大模型4.0 Turbo版,用户们现在就可以在网页端和API上进行体验,App端也会陆续推出。企业用户可以通过百度智能云的千帆大模型平台来调用这个API服务,真是太方便了!

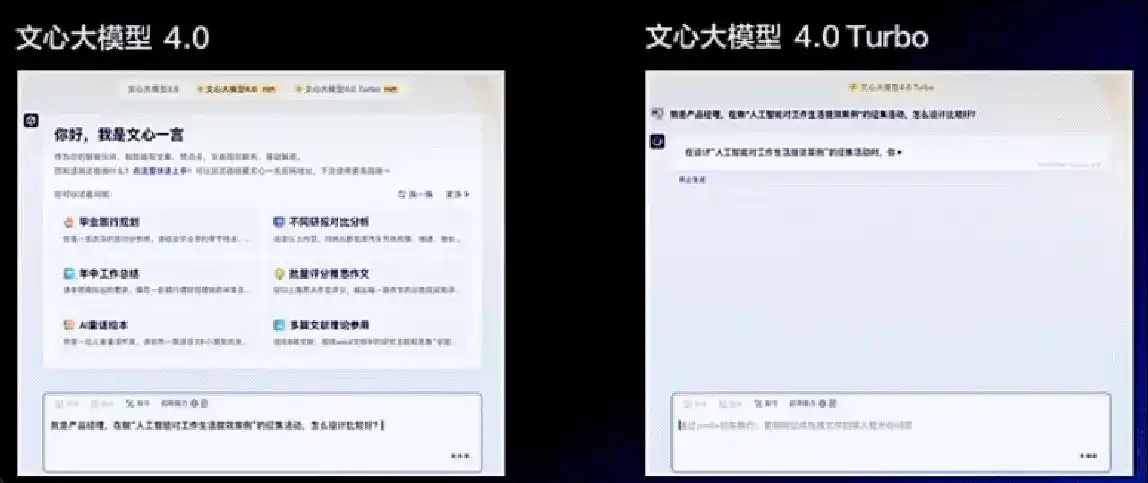

▲新发布的文心大模型4.0 Turbo

这次的文心4.0 Turbo在生成速度和效果上都有了显著提升。王海峰现场展示了Turbo与4.0版的对比,结果一目了然:在同样的提示下,Turbo的生成速度快了不少,内容的条理性也更强,真是让人惊叹!

▲文心4.0 Turbo与文心4.0的速度对比

在基础模型方面,百度还进一步研发了智能体(Agent)机制,涵盖理解、规划、反思和进化。这一机制使得智能体能更可靠地执行任务,自我进化,并在一定程度上让这个大模型的思考过程变得透明,仿佛它也能像人一样思考和行动,利用工具自主完成复杂任务,并在环境中不断学习,达到自主进化的效果。

▲基于文心大模型的智能体升级

此外,百度还与中国工程院的朱有勇院士及其团队合作,推出了首个农业智能体“农民院士智能体”。这个智能体基于文心智能体平台开发,结合了朱院士的研究成果和丰富的农业知识,能为农民们解决在生产和生活中遇到的各种问题。

▲农民院士智能体

文心大模型的惊人进展与飞桨框架的新动态

最近,百度的副总裁吴甜分享了一些令人振奋的消息。过去半年里,使用文心大模型的用户提问量每天增加了78%,而提问的平均字数更是上升了89%。这说明大家对文心的依赖越来越深,提问也变得更加丰富和具体。

文心大模型的应用遍地开花,截至目前,它已经创作了惊人的5.9亿篇文章,还绘制了2.4亿张图片,生成了70亿行代码,帮助了1.3亿人次完成各自的工作。

▲文心大模型的累积成果

吴甜还提到,文心大模型的星河共创计划自去年8月启动以来,已经推出了超过1000个大模型工具,并且开发了超过55万个AI应用,积累了超1000B的优质数据。

举个例子,百度和长光卫星技术有限公司合作开发的智能助手,在上线的第一个月就服务了3.1万用户,解答了超过3.8万次有关遥感技术的问题。

飞桨3.0测试版新鲜出炉,优势尽显

说到飞桨,这可是百度推出的开源深度学习平台。王海峰表示,飞桨已经服务了1465万开发者和37万家公司,创建了将近95万个模型。

今天,飞桨3.0 Beta版本正式上线,带来了动静统一自动并行、编译器自动优化等四大亮点,适配大模型的多种硬件,简化了训练和推理的过程。

▲飞桨3.0 Beta版本

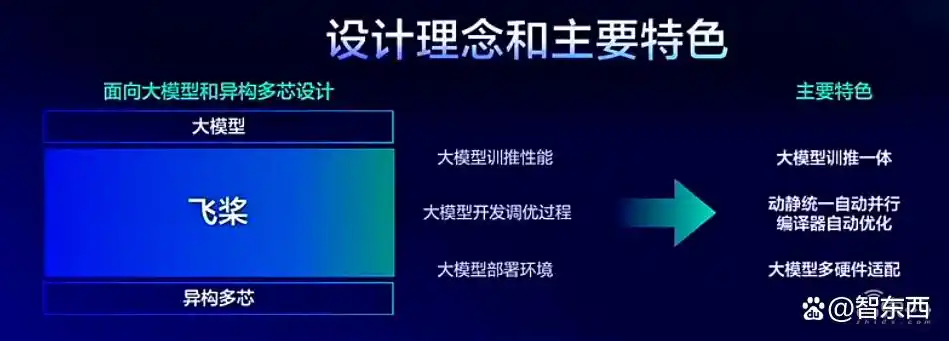

在设计上,飞桨充分考虑到了大模型和多芯片的趋势,旨在提升训练和推理的性能,同时简化大模型的开发和调优过程。为此,它与文心进行了深度合作,确保了更好的适配性。

飞桨3.0:让大模型训练变得简单

▲飞桨框架设计理念

说白了,飞桨在设计上特别注重让动静结合的自动并行变得简单易用。这意味着大模型的混合并行训练可以轻松实现,分布式训练的核心代码量能减少超过一半,典型模型的训练性能甚至提高了20%呢。

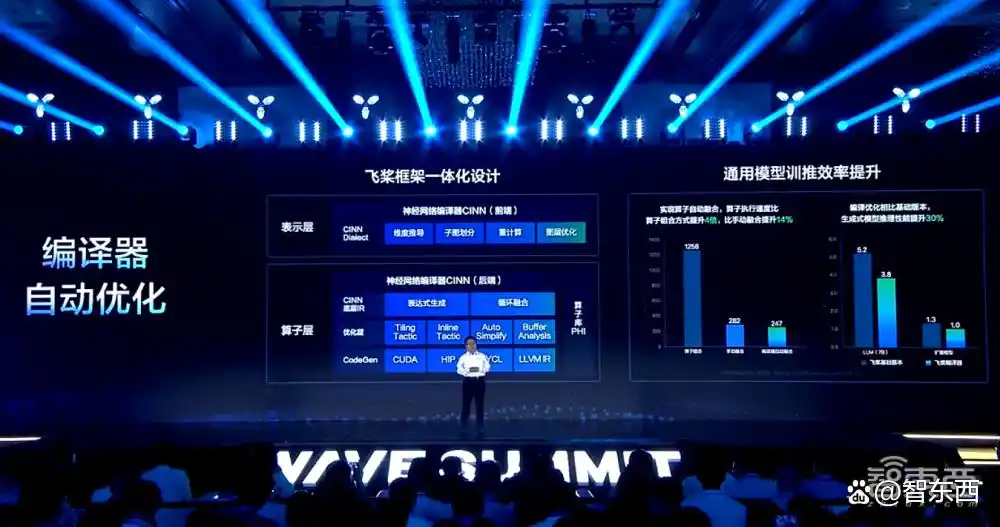

再来聊聊编译器的自动优化。这家伙可厉害了,它能高效支持大模型和AI科学计算,通过一体化设计,显著提高通用模型的训练效率。比如说,大模型的推理性能能提升30%,而典型的科学计算模型求解速度更是快了71%呢!

▲编译器自动优化

在适配多种硬件方面,飞桨也没闲着。通过低成本的硬件接入,开发者只需调整30多个接口,就能全面支持大模型的训练、压缩和推理,轻松实现软硬件的协同优化。

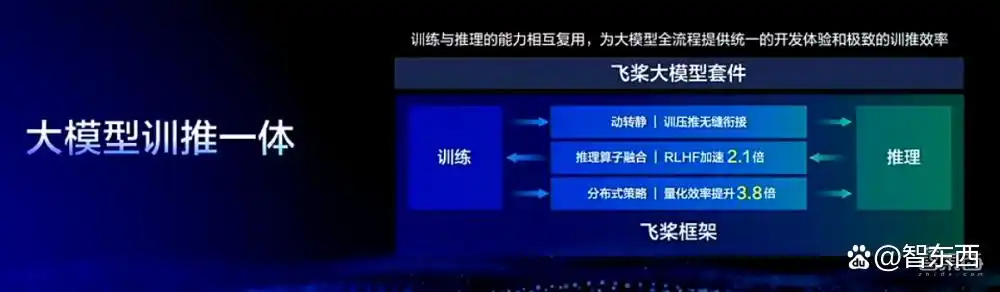

飞桨框架3.0的最大亮点就是它的训推一体化。通过无缝连接训练、压缩和推理的过程,竟然能让RLHF训练复用推理引擎的速度提升2.1倍,而量化压缩复用分布式策略的效率更是提升了3.8倍!

▲大模型训推一体

从整体的架构来看,飞桨3.0分为四个主要层级:表示层、调度层、算子层和适配层。值得一提的是,飞桨3.0的开发接口完全兼容之前的2.0版本,用户根本不需要重新编写代码,真是省时省力!

▲飞桨3.0框架

飞桨优化与文心快码的全新升级,你了解多少?

飞桨最近对AI for Science进行了不少改进,能兼容超过130个主流科学计算库的模型,支持各种科学问题的分析。这些模型在处理数据、机理和数理融合方面的表现都很不错,尤其是那些基于高阶自动微分和编译优化技术的方程求解类模型,竟然比PyTorch快了71%呢!

智能代码助手Comate迎来重大升级,覆盖百度80%程序员

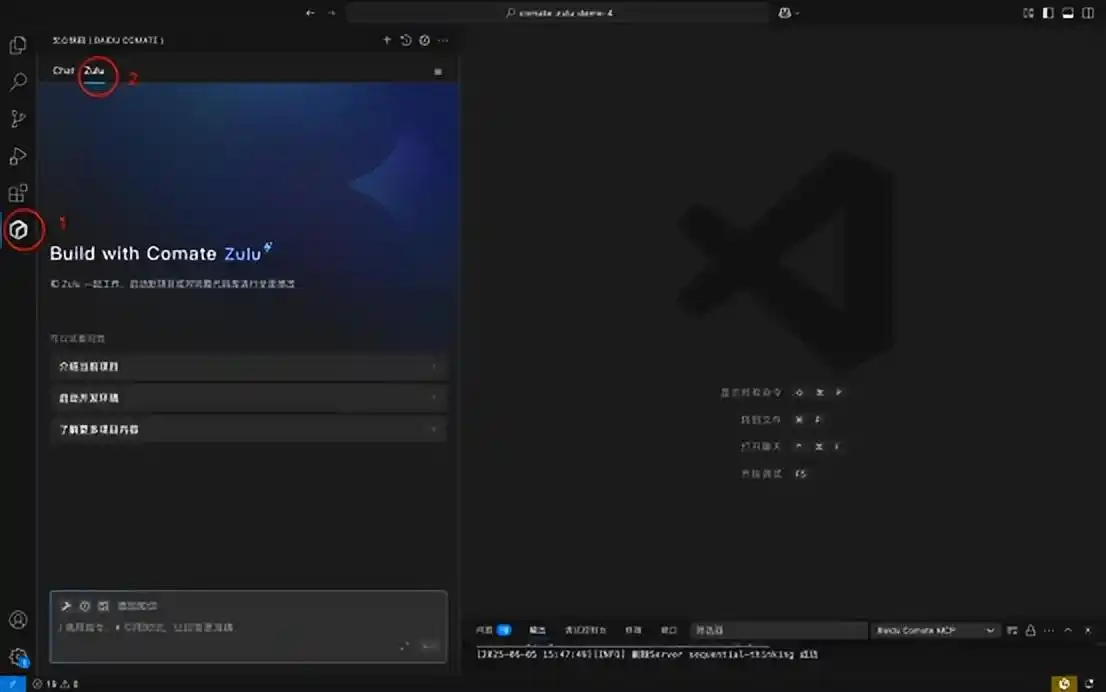

最近,百度的副总裁陈洋宣布了智能代码助手Comate的2.5版本升级,增加了很多研发知识,让整个流程变得更全面。

▲全新升级的百度智能代码助手

而且,这个助手现在还有了一个中文名——文心快码,正式加入了百度文心大家庭。

陈洋还提到,文心快码的“快”主要体现在三个方面:开发速度快、业务迭代快、企业落地快。

▲文心快码2.5版本的亮点

具体来说,文心快码在开发速度上也大有提升,它汇聚了数百位技术专家的经验,还有十亿级的研发知识,覆盖了上万家企业的实际研发场景。

在百度内部使用的反馈显示,基于文心快码生成的开发框架代码准确度达到了80%,而且在同样的时间内,提交的代码数量提升了35%!

▲文心快码的开发速度大幅提高

文心快码,让开发变得更简单

说到文心快码,它可真是把研发的各个环节整合得无缝对接。从需求调研、设计,到代码编写、测试和发布,几乎没有缝隙!

陈洋提到,在百度的研发流程中,文心快码大大提高了效率。比如,写一行代码的时间缩短到1.74秒,连部署脚本的生成也能在瞬间完成,线下环境的部署时间节省了超过10分钟。总的来说,这让每个工程师的工作效率提升了超过14%呢!

▲文心快码让业务迭代飞速提升

在企业实际应用方面,文心快码针对行业规范的不同、公司内部的知识管理以及如何更好地结合代码助手和内部工具这些痛点,提供了可靠的解决方案,确保业务能够顺利运行。

经过一年的实践,在百度的上万名工程师中,文心快码的使用率已经达到了80%。而且,生成的代码被采纳的比例也达到46%,新增代码的生成占比为29%。

再说说喜马拉雅这个标杆客户,他们只花了一个季度,就让90%的工程师开始使用文心快码,代码采纳率达到了44%,新增代码生成的比例也有33%。

▲文心快码的企业落地效果

喜马拉雅的CTO姜杰表示,文心快码和他们积累的研发能力、知识相结合,显著缩短了技术调研和代码编写的时间,极大地提升了整体的研发效率和产品质量。

目前,文心快码提供四种版本:标准版、专业版、企业版和企业专有版。特别是专业版,专为专业开发者限时开放,基础和高级功能都可以随意使用,不设上限。

总结:AI助力工业化进程

从历史看工业革命与AI的演变

回顾一下历史,我们会发现前三次工业革命的核心动力,像机械、电气和信息技术,其实都有着很强的适用性。王海峰提到,当这些技术开始展现出标准化、自动化和模块化的特征时,它们就进入了一个全新的工业大生产阶段。

现在,你可能会注意到,AI技术中的算法、数据、模型和工具等,也开始具备类似的通用性。这些技术同样展现出标准化、模块化和自动化的特点,正在为AI迈入工业大生产阶段铺平道路。

文心大模型4.0 Turbo的速度提升确实惊人,但在实际应用中,是否能稳定支持这么高的用户量呢?

文心大模型4.0 Turbo的升级确实让人期待,但对于普通用户来说,如何快速掌握这些新特性还有待进一步的教学支持。

文心大模型4.0 Turbo的速度和效果提升让人印象深刻,但在实际应用中,能否保持一致的性能表现仍需观察。希望后续能有更多稳定性测试的结果分享。

文心大模型4.0 Turbo的发布确实令人兴奋,但我对其在不同场景下的实际稳定性还有些疑虑,希望未来能有更多真实案例分享。

文心大模型4.0 Turbo的性能提升确实让人期待,但希望百度能提供更多的使用案例,帮助用户更好地理解其实际应用场景。

文心大模型4.0 Turbo的速度和效果提升让我很惊喜,不过我对它的实际稳定性还有些担忧,希望能看到更多的真实使用案例来验证。

文心大模型4.0 Turbo的速度提升确实引人注目,但希望百度能够提供更详细的使用案例,以帮助用户了解其在实际应用中的表现。

文心大模型4.0 Turbo的速度提升确实很让人期待,但希望百度能在用户界面上做出更友好的调整,让新手用户更容易上手。

文心大模型4.0 Turbo的速度提升让我很期待,但希望百度能在新手指导方面做得更好,让更多用户能轻松上手。

文心大模型4.0 Turbo的速度和效果提升确实让人印象深刻,但我对其在复杂任务中的表现还有些疑虑,希望能看到更多真实案例以验证其稳定性。

文心大模型4.0 Turbo的速度和效果提升确实令人振奋,但我对它在长期使用中的稳定性还有些担心,希望能有更多实际案例来验证其可靠性。

文心大模型4.0 Turbo的生成速度和效果提升确实令人惊喜,但希望能更详细地展示其在各行业的应用案例,帮助用户更好理解如何使用。

文心大模型4.0 Turbo的速度和效果确实令人印象深刻,但我对其在实际应用中的复杂任务处理能力还有些疑虑,希望能看到更多相关案例。

文心大模型4.0 Turbo在速度和效果上都取得了很大进步,但我担心它在处理复杂任务时的准确性,希望能看到更多相关的验证案例。

文心大模型4.0 Turbo在生成速度上确实很快,但希望百度能加强对复杂任务的处理能力,以确保使用时的准确性和可靠性。