轻松给大模型做MBTI测试,20分钟搞定!

在这个AI飞速发展的时代,各种模型的能力不断提升,像长文本处理、多模态理解和复杂推理等领域都有了新的突破。无论你是大模型的算法工程师,还是产品经理,评估大模型的能力已经成为了AI应用行业的一部分日常工作。接下来,我将用五句话教你如何在20分钟内,利用文心快码轻松创建一个大模型的MBTI性格测试器,完全不需要任何基础!

一、需求背景

你可能会问,为什么要为大模型做MBTI性格测试呢?在社交平台上,MBTI就像是人们的社交名片,可以反映出个人的性格、价值观、沟通方式等特点。既然大模型能够模拟人类思维,那它们是否也能被归类成MBTI类型呢?很多人在职业发展和人际交往时都会参考MBTI,换句话说,MBTI测试不仅能帮助我们理解AI模型的行为模式,还能预测它们的倾向和潜在局限。

对于算法工程师和产品经理而言,了解模型的MBTI类型,可以帮助提升人机交互体验、选择合适的模型、揭示模型的内在偏好和指导模型的开发。而对于使用AI的用户来说,给模型打上“MBTI标签”可以帮助他们更快地理解模型的特点——知道模型适合做哪些任务,和它交流时怎样更轻松。总之,给大模型做MBTI测试不仅有趣,而且非常实用。

大家应该知道,MBTI测试有93道题,做完大概需要半个小时。如果用人工方式进行测试,我们得在客户端或者网页上逐一跟大模型对话,输入问题并记录答案,这样时间成本就会大大增加。而且在实际应用中,我们不可能只测一个模型,也不可能只测一次。当手头有多个模型需要测试,且还要多次测以确保稳定性时,人工测试的效率就显得非常低下。即使测试完成,为了比较不同模型的表现和观察稳定性,我们还得花时间整理报告,整个过程繁琐得让人抓狂。总结一下,人工测试的痛点主要有:

场景设计耗时:构思有效的测试用例费时费力;

样本生成低效:手动构建高质量的输入输出样本效率低;

执行繁琐易错:手动调用不同模型API,运行多轮并记录结果容易出错,且难以规模化;

报告缺乏洞察:难以直观比较模型的差异,难以发现稳定性问题。

不过,幸运的是,我们有文心快码这样的工具,编写自动化脚本变得不再困难。接下来,我会详细介绍操作过程。

二、明确你的需求

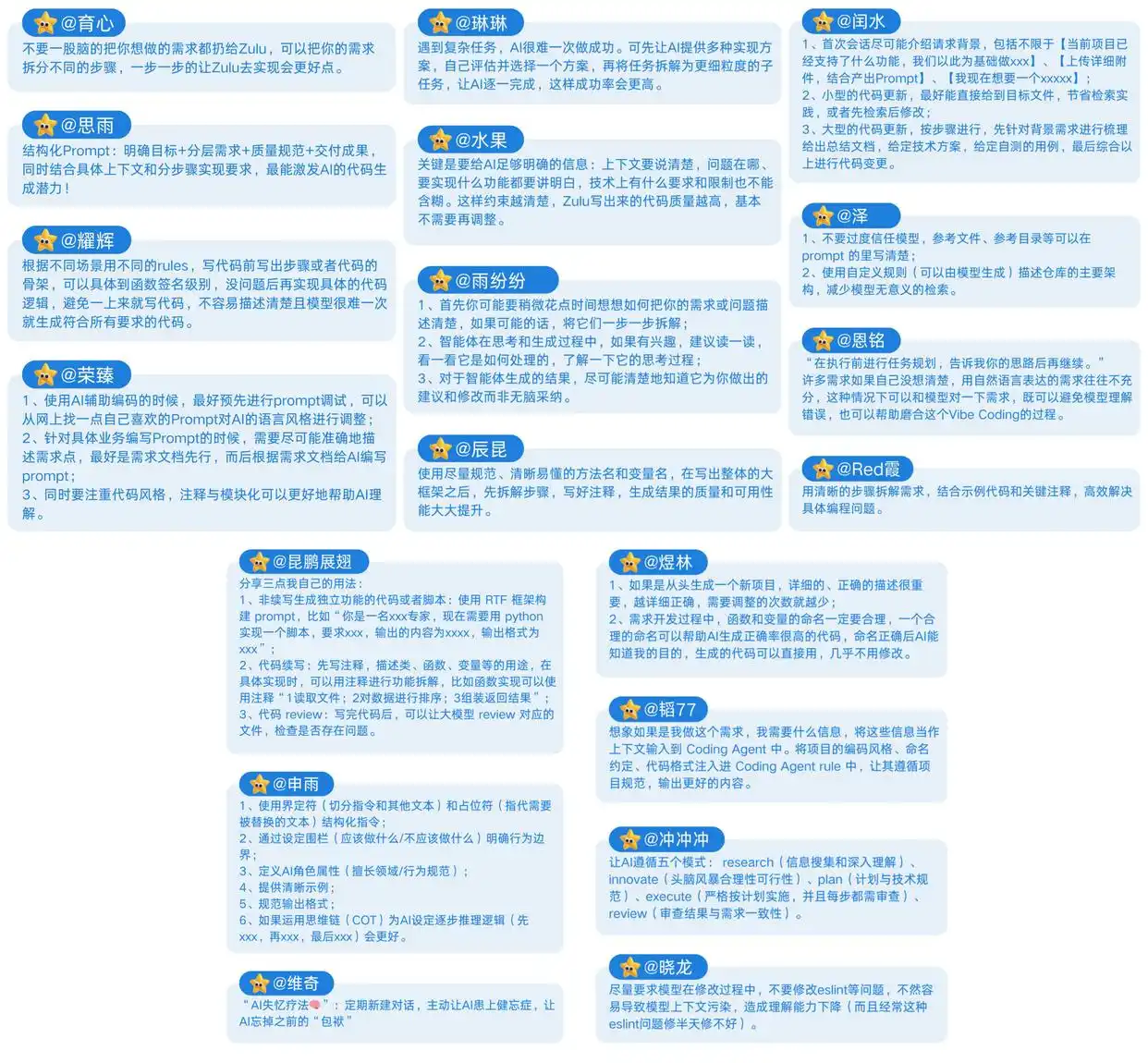

文心快码的强大之处在于:它不仅能生成代码,还能根据我们的需求自动补全场景设计、分解任务,并输出可运行的结果。为了充分发挥它的作用,首先要把需求描述清楚。在表达需求时,最好将背景、目标、交付标准和执行步骤都交代清楚,这样文心快码才能理解我们的意图,准确完成任务。以下是一个示例:

你可以先准备一个文档,里面写上模型名称、域名、API Key,告诉文心快码需要测试哪些模型以及调用哪些API,并给出相应的MBTI测试题目。接着,提出测试要求,比如需要测五次以观察稳定性。再告诉它交付的标准,最后给它提供一个初步的行动指南:让它先写一个项目设计文档,以了解它的思路;进行单模型测试,以验证项目是否能正常运行,降低试错成本;只要求先测试一个模型,为后续的整体测试做好准备。

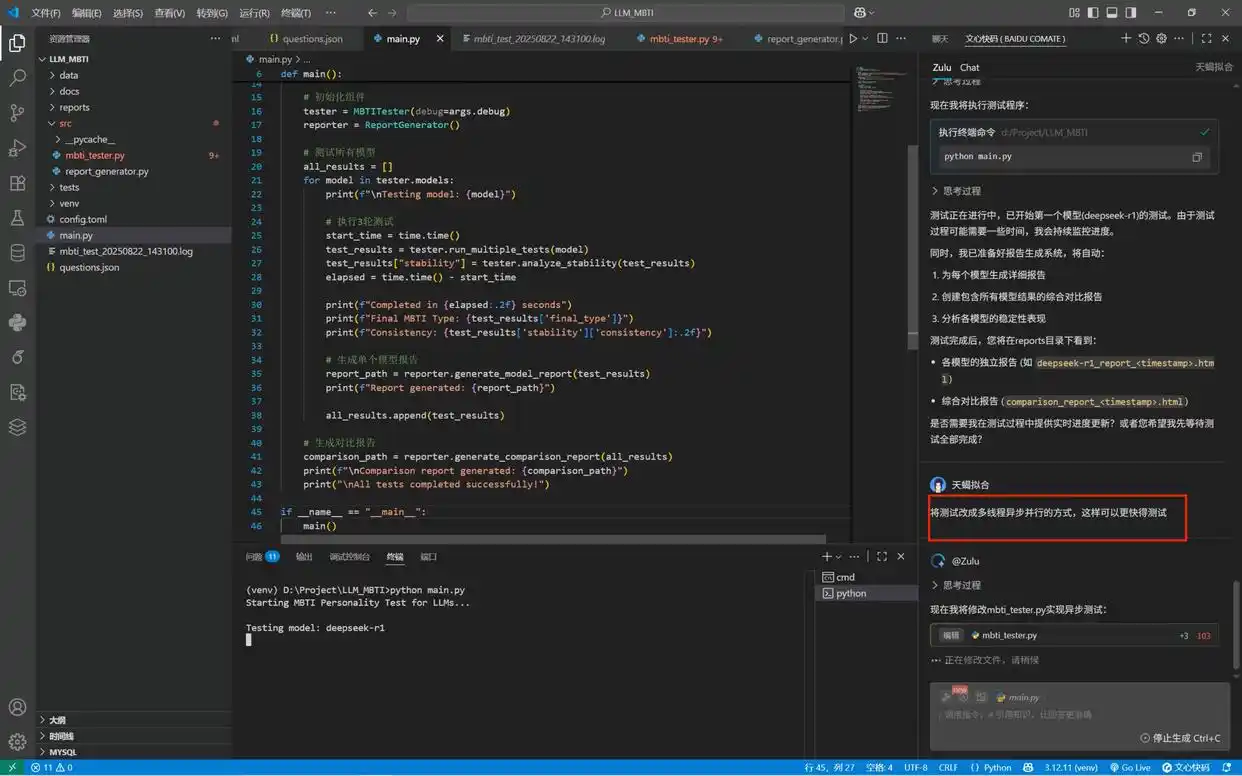

三、观察执行过程

将需求输入到文心快码的Zulu对话框后,Zulu就开始执行任务了。在这个过程中,我们只需观察它的操作:

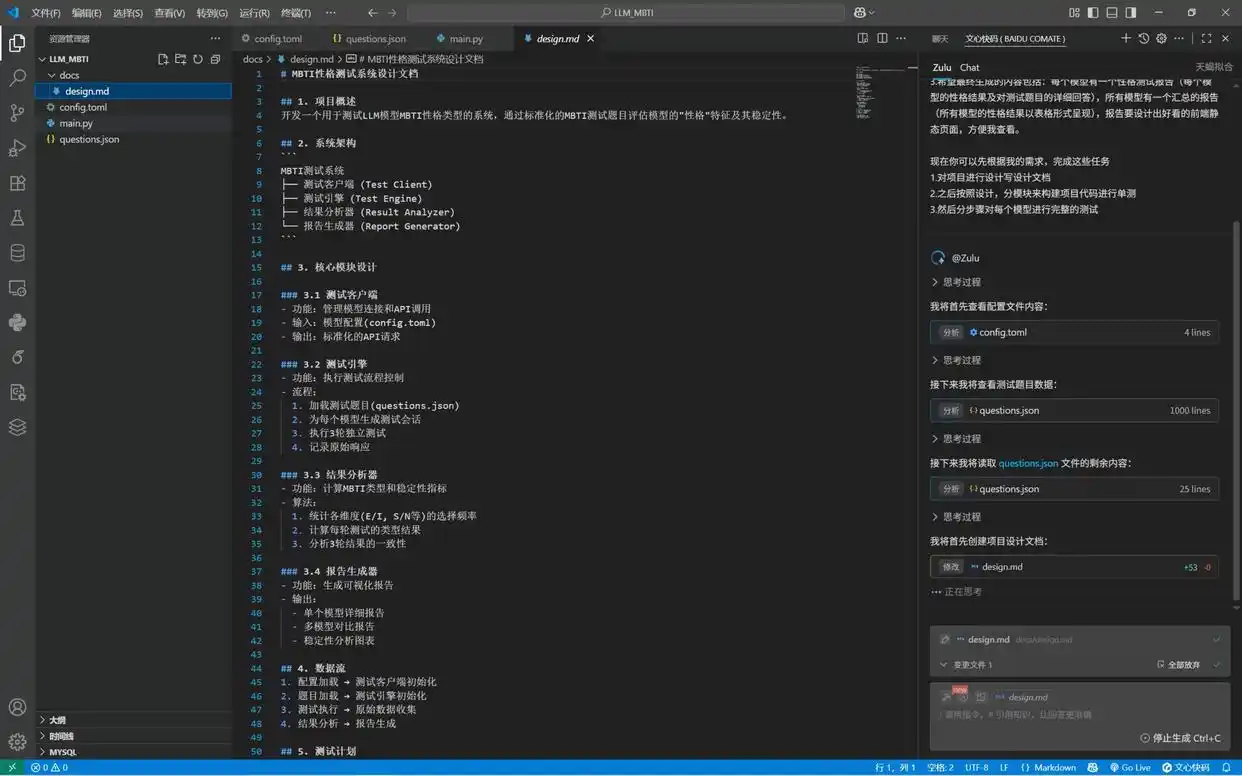

第一步:编写项目设计文档design.md,涵盖系统架构、核心模块设计、数据流和测试计划等内容。

第二步:开发核心测试模块。

第三步:开发报告生成模块。

第四步:开发主程序模块。

第五步:运行单模型测试,以确认逻辑与输出没有问题。

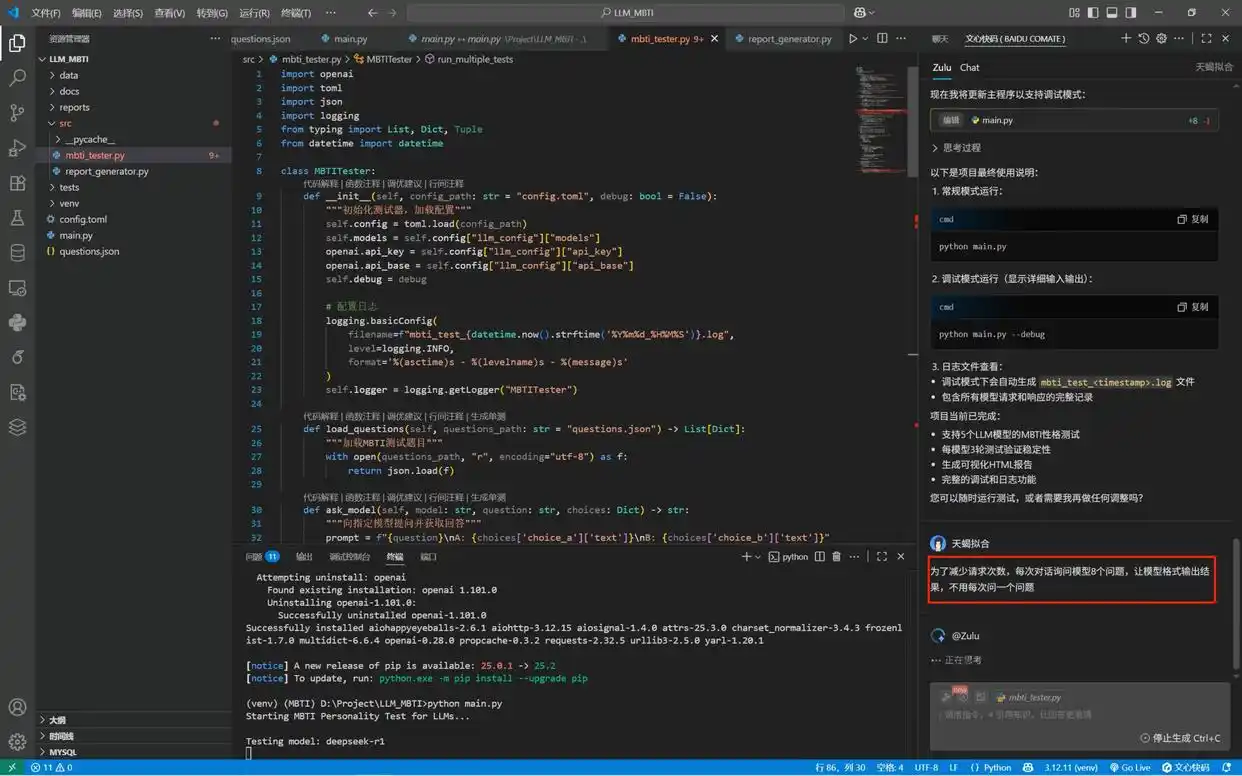

在这个过程中,可以看到Zulu能够自动调用相关工具,复用相同的终端,帮助完成环境搭建和服务启动,整个过程完全不需要我们操心。

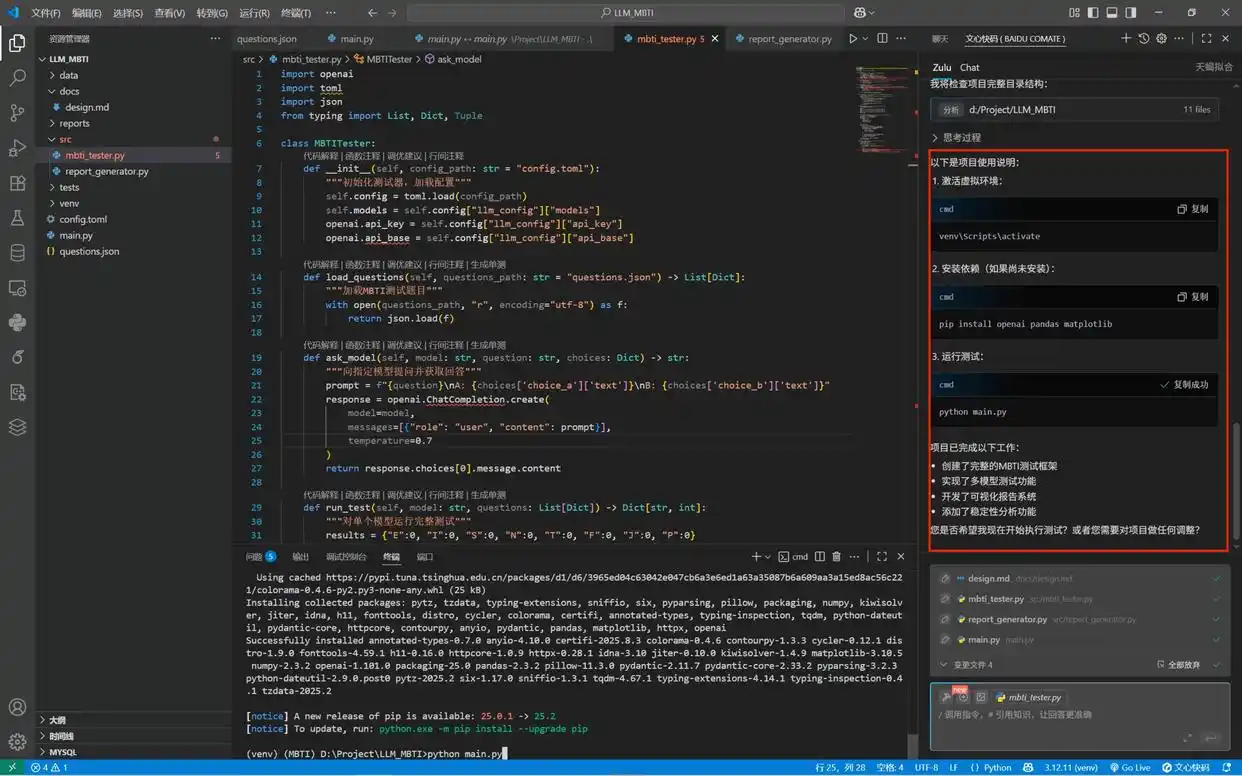

【依赖自动安装】Zulu会自动识别项目中的依赖文件,然后创建一个干净的虚拟环境,并安装所有必要的依赖。

【服务自启动】Zulu能聪明地识别项目的启动命令,并自动运行它,让开发环境启动变得简单无比。

【错误自修复】如果在搭建环境或启动服务时出现问题,Zulu会主动检测错误并给出修复建议。比如,如果缺少某个依赖,它会自动尝试安装,甚至直接解决问题。

举个具体的例子:在运行测试时,终端出现了错误提示:ModuleNotFoundError: No module named ‘toml’。Zulu立刻捕捉到这个异常,自动执行了pip install toml命令来修复缺失的依赖,无需用户干预,之后继续执行后续任务。

项目初步完成后,Zulu会给出清晰的使用说明和总结。

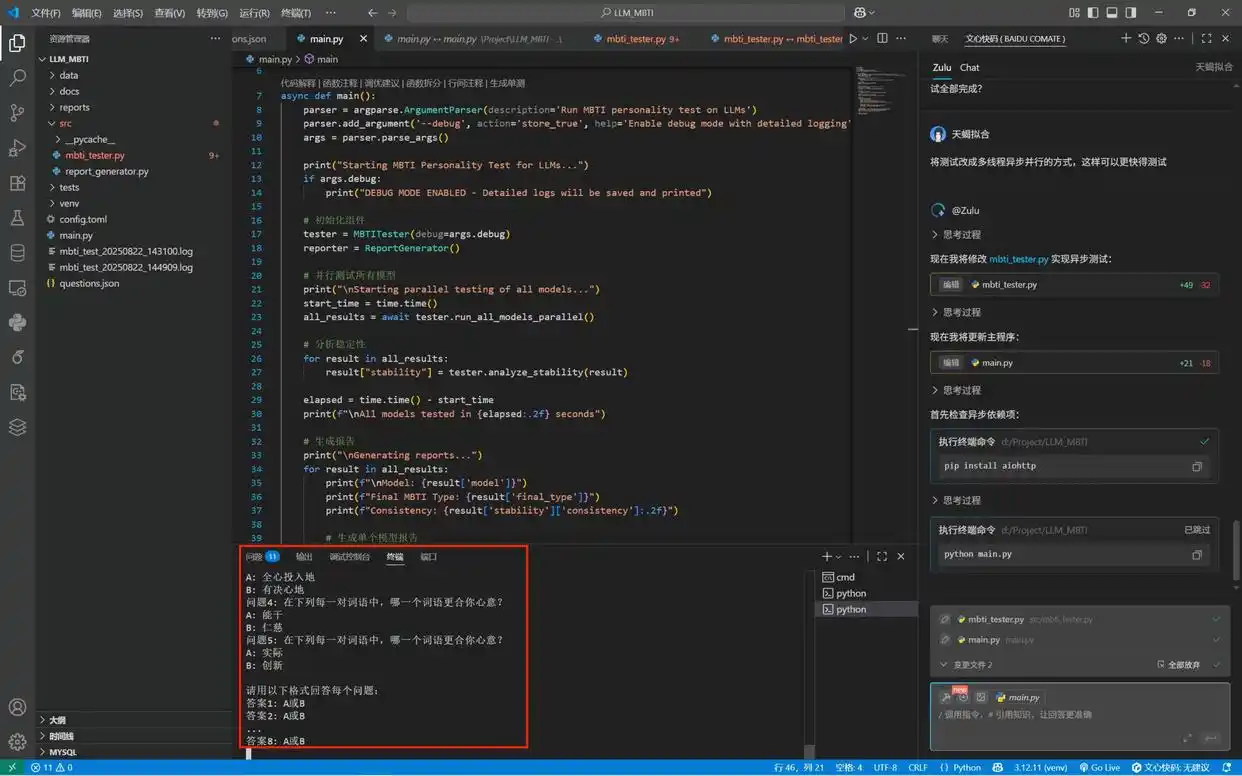

四、持续优化工作流

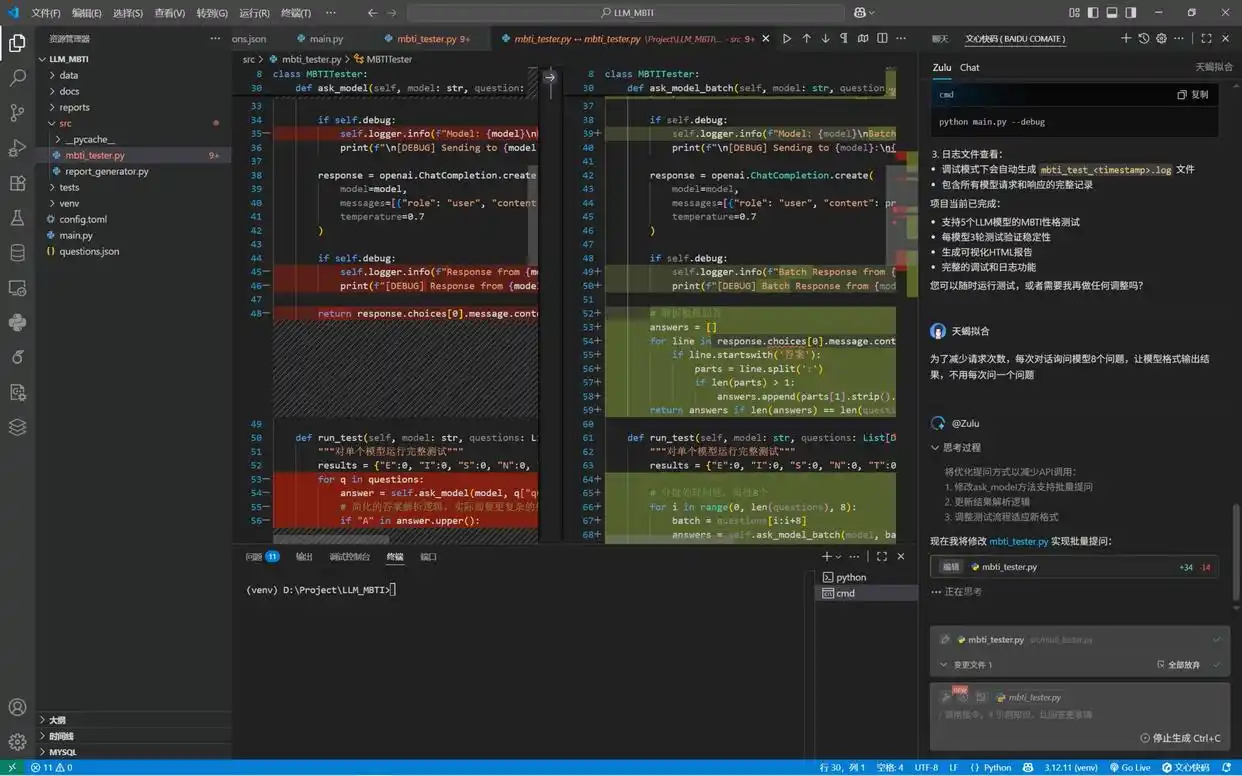

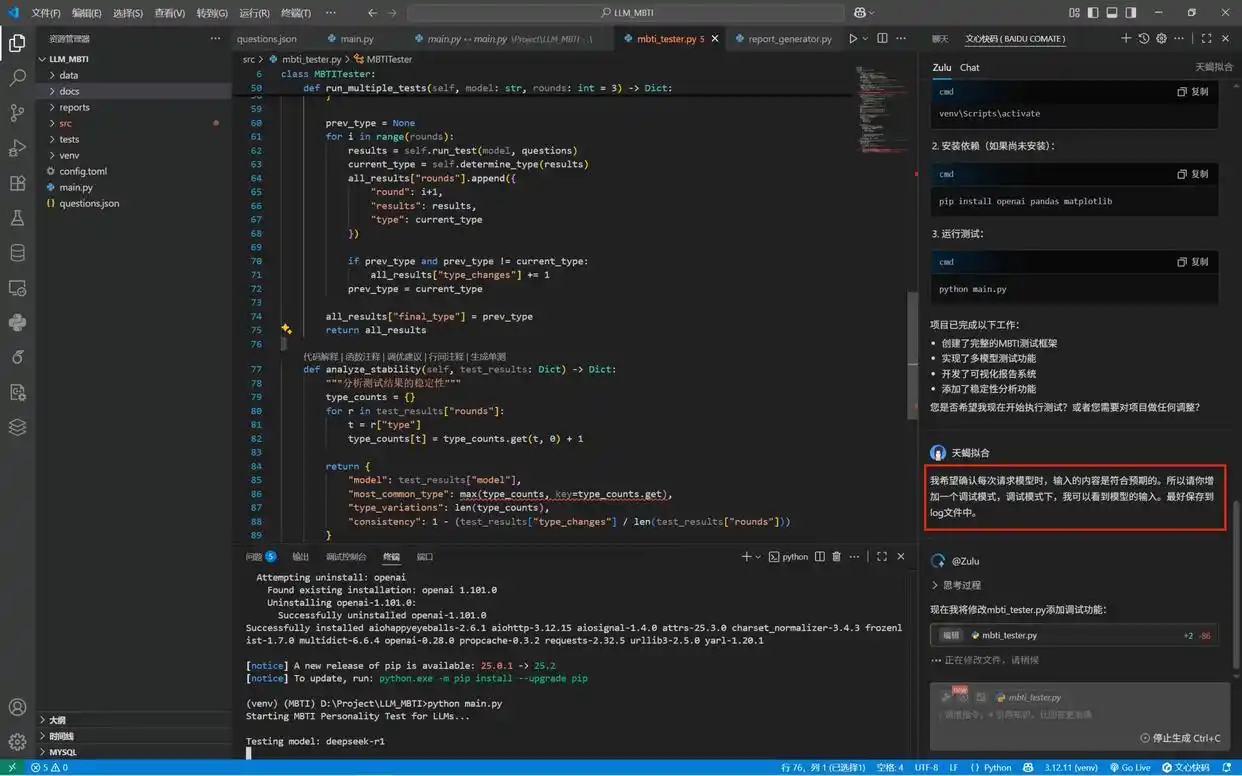

Zulu为我们创建的自动化脚本几乎已经完成了。但如果整个过程都是“黑盒”,难免让人产生疑虑:模型都完成测试题了吗?三次测试都测完了吗?那么该怎么办呢?可以添加一个调试需求,让我们实时看到模型的输入,从而使测试过程更加透明。

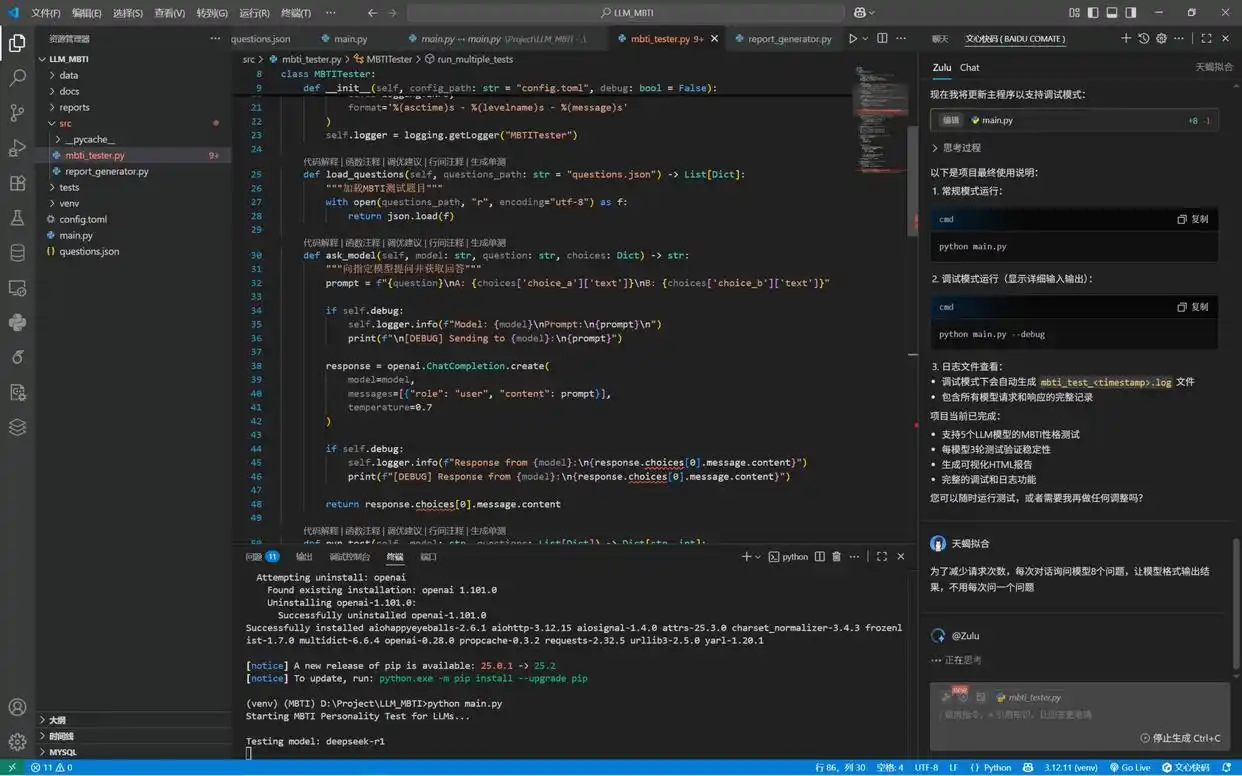

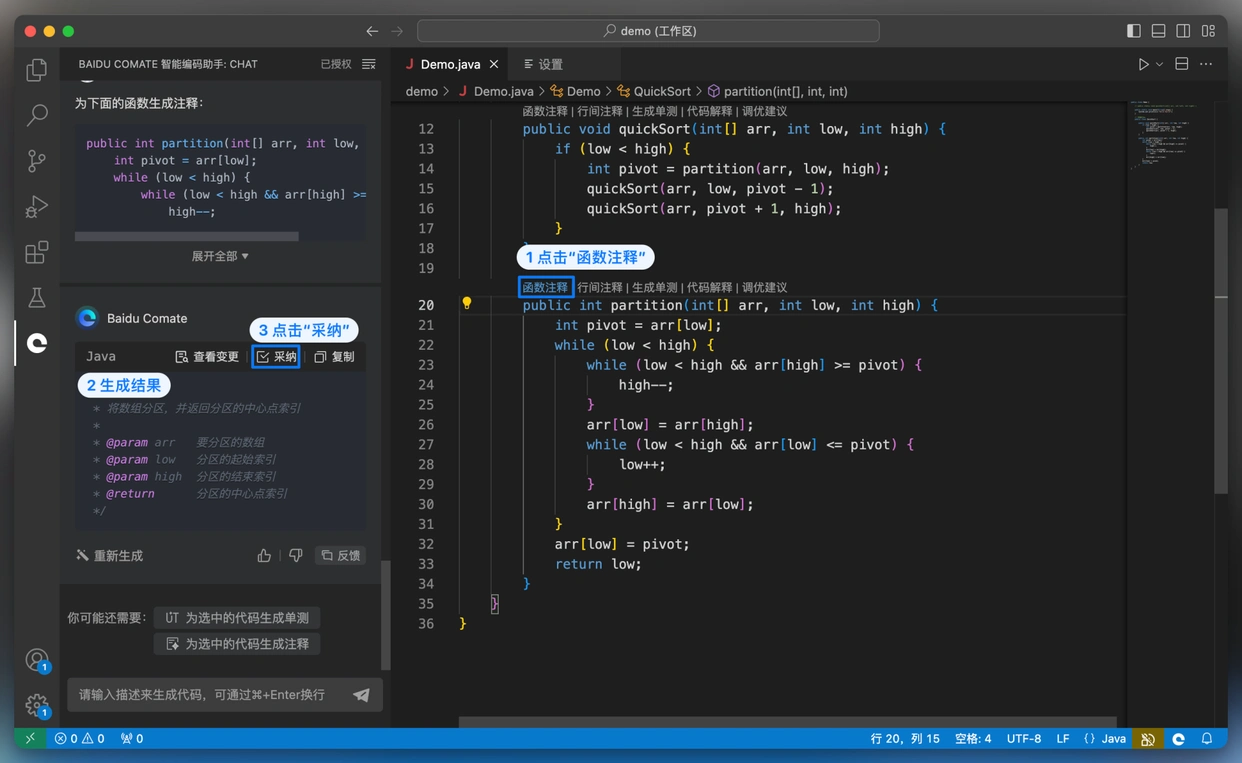

Zulu可以基于当前的上下文,在原有代码库中找到合适的位置进行修改。即使你不懂代码,也不知道该在哪里修改,只要输入需求,Zulu凭借强大的理解能力,结合当前的代码库,能快速定位到要修改的地方。而且修改过程完全透明清晰:被删去的代码用红色标示,新增的代码用绿色表示。

轻松调试与报告生成,让你的项目事半功倍

想要确认每次调用模型的输入是否符合预期?别担心,只需简单输入需求:“我想要一个调试模式,这样我就能看到每次请求的内容,并且最好能保存到日志文件里。”这样做的好处是,你不仅可以验证请求的正确性,还能方便后续的问题追溯。Zulu很快就理解了这个需求,并在修改后给出了调试模式的测试命令。

其实在这个项目中,我们可以借助Zulu来不断优化工作流程。

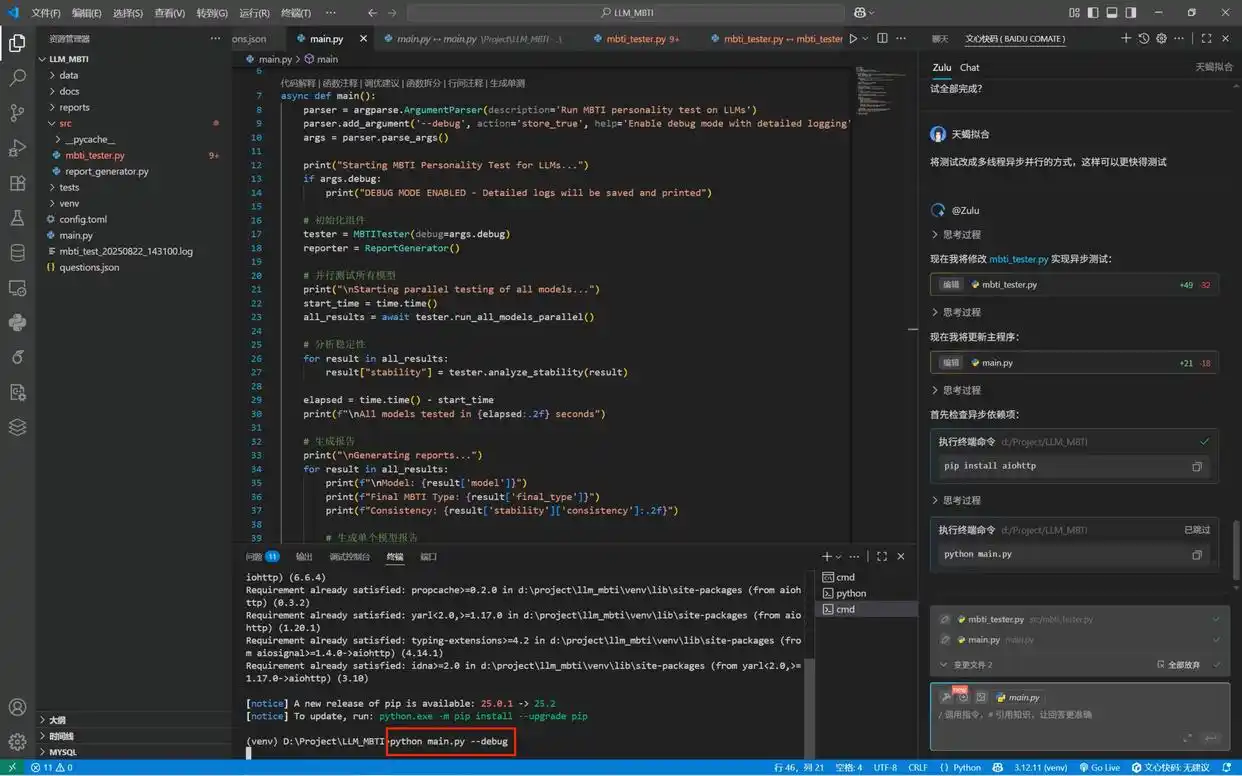

1. 提升工作效率

在实际的测试过程中,我们发现一个个问题测试起来太慢了,于是我告诉Zulu:“为了效率更高,每次和模型对话时一次性问8个问题,让它批量输出结果。”你猜怎么着?Zulu马上就明白了,调整了程序逻辑,把原本的逐个请求改成了批量处理,测试速度大大提升。

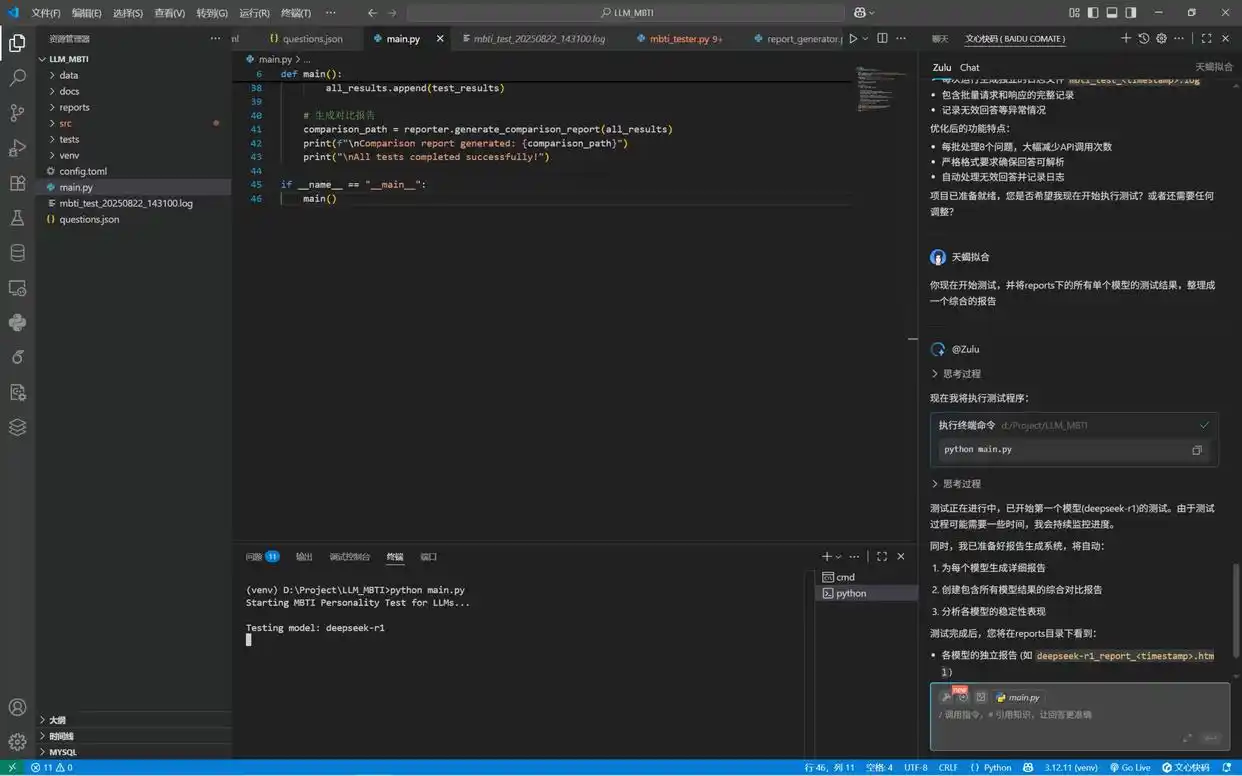

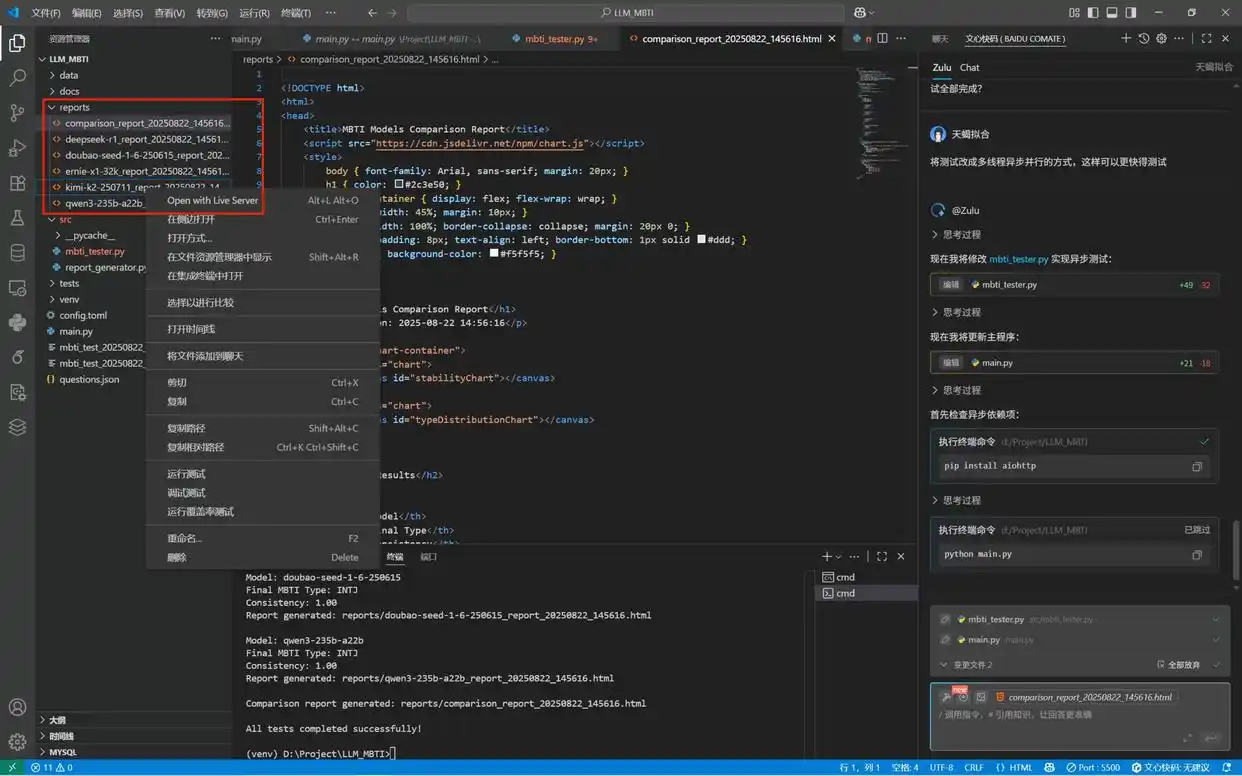

2. 自动生成报告

当我们确认单个模型的MBTI测试没有问题后,可以让Zulu来生成一个综合报告:“请把reports文件夹下所有模型的测试结果整合成一份完整报告。”这样就能快速得到一个全面的总结。

3. 优化性能

如果测试速度依然不够快,我们可以提出更高的要求:“能不能用多线程异步并行请求来测试模型,这样会更快。”Zulu会根据这些建议重构代码,从而大幅度缩短测试时间。

一旦Zulu完成了这些修改,项目就快要完成了。我们可以在终端输入调试模型的运行指令“python main.py –debug”,开始测试并生成报告。调试模式下,整个测试过程都能清晰地展示在终端上。

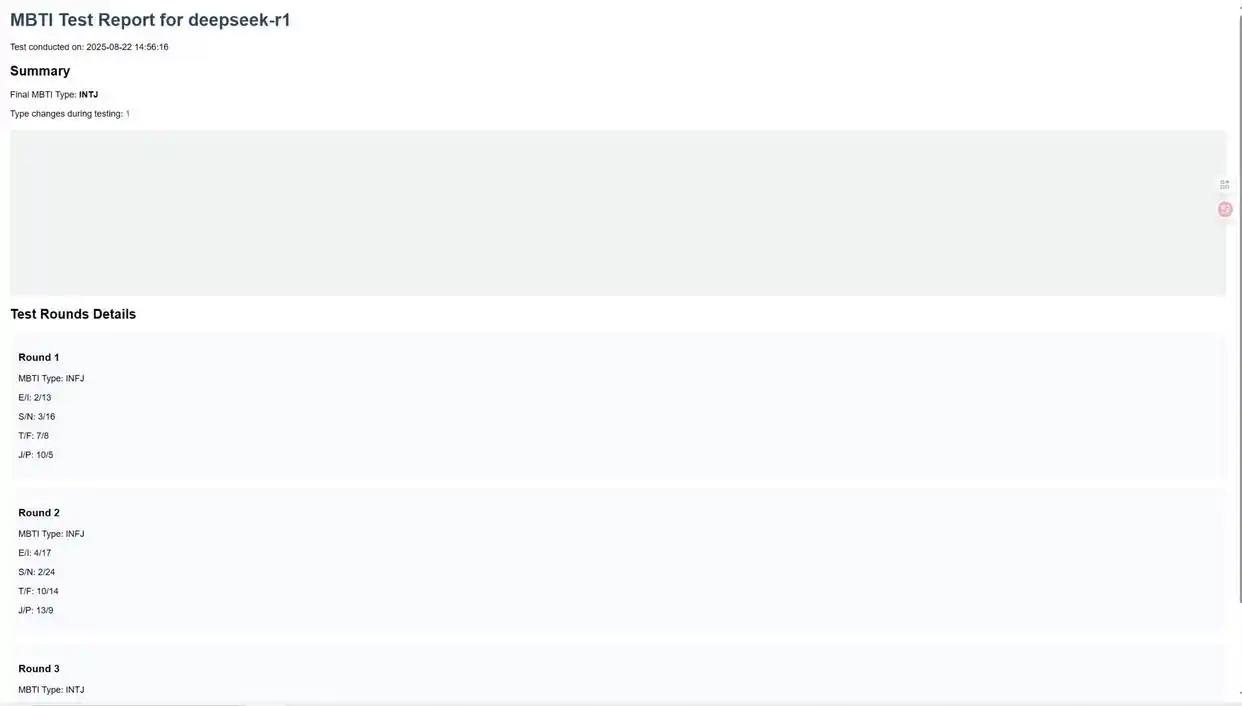

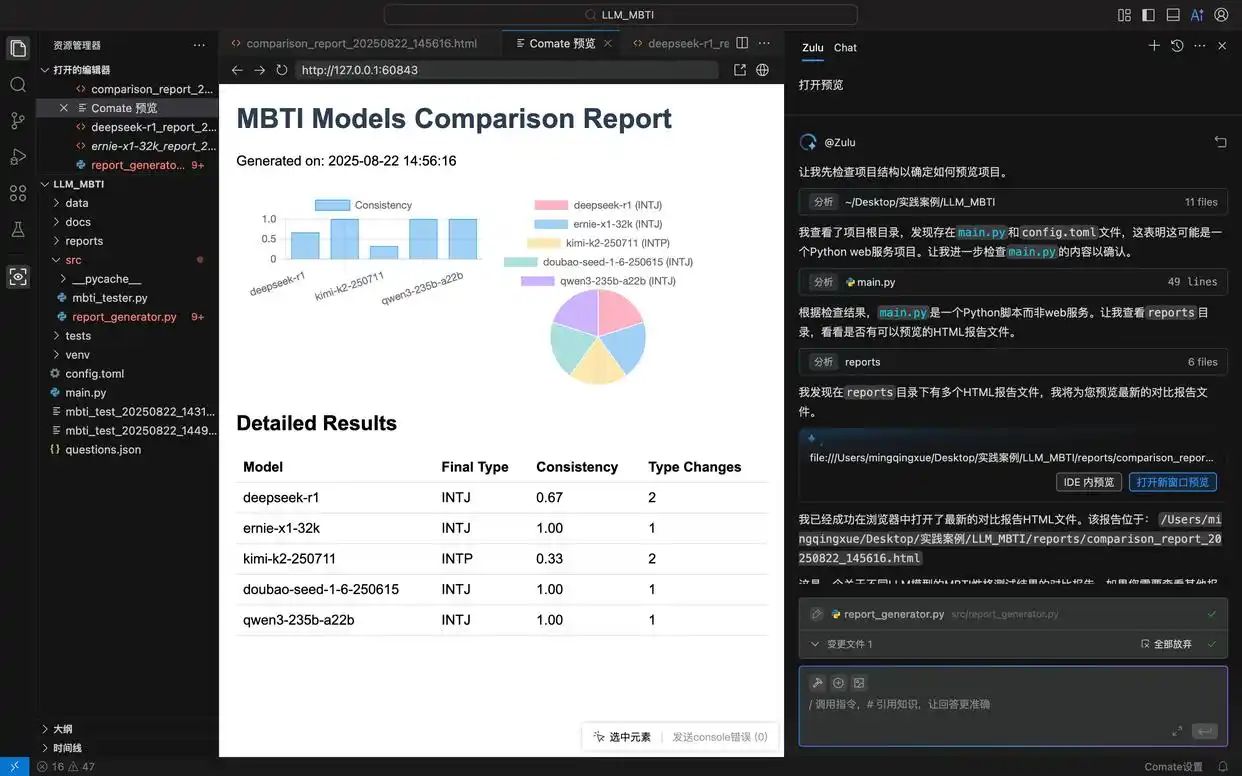

五、通过预览调试功能完善报告

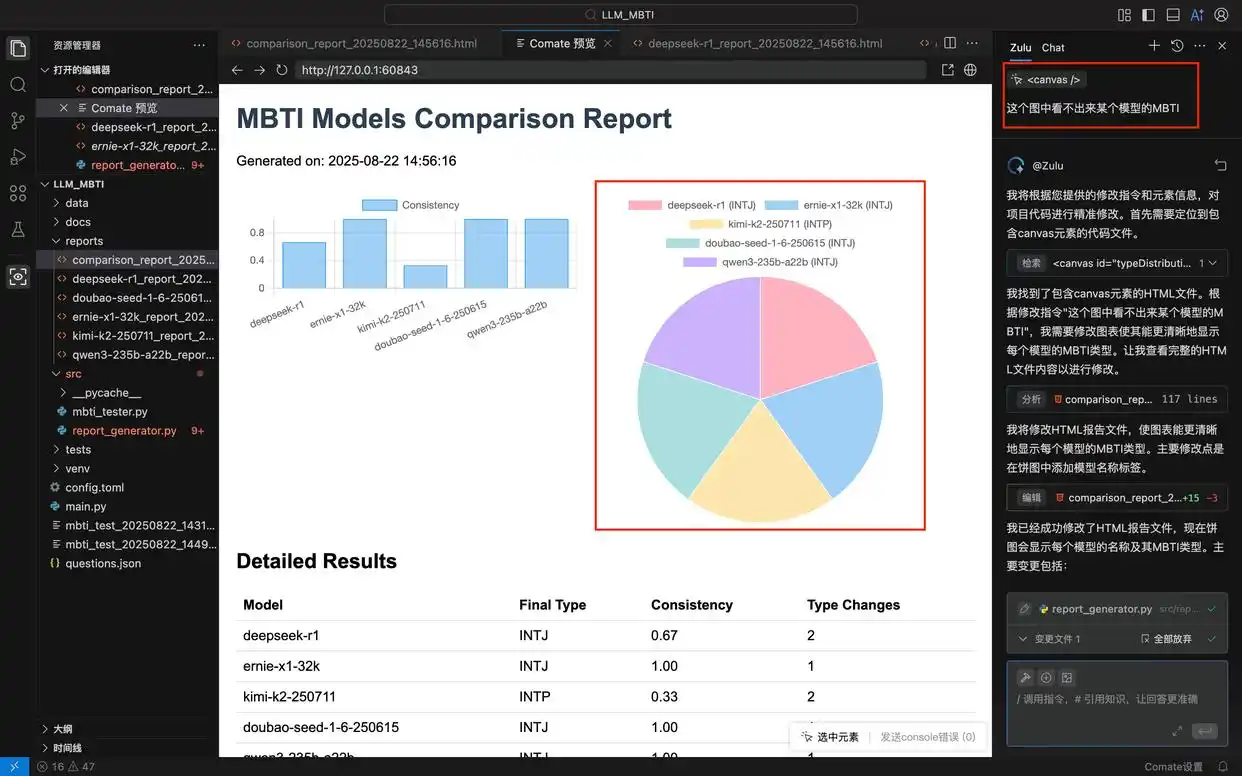

到目前为止,测试报告已经生成,在reports目录下,你可以找到一份综合报告,以及每个模型的历史测试报告。点击预览网页查看成果,如果发现问题,随时可以进行修改。

如果你正在使用文心快码插件,Zulu的多模态能力可以帮助你修改。它支持上传图片,并根据指令识别图片内容或者将图片转成代码。只需截图问题界面,上传到对话框,输入修改需求。如果你用的是Comate AI IDE,预览调试功能也可以协助你轻松进行修改。在IDE左侧的侧边栏点击预览按钮,打开预览调试界面,圈选问题位置,在Zulu对话框输入修改需求,就能完成修改。

在这个项目中,我希望报告中的饼状图能够展示每个模型的MBTI类型。于是,我在Comate AI IDE中选中这个组件,输入调整需求,结果Zulu就针对性地修改了报告的html文件。刷新预览窗口后,就能看到最新的报告样式。

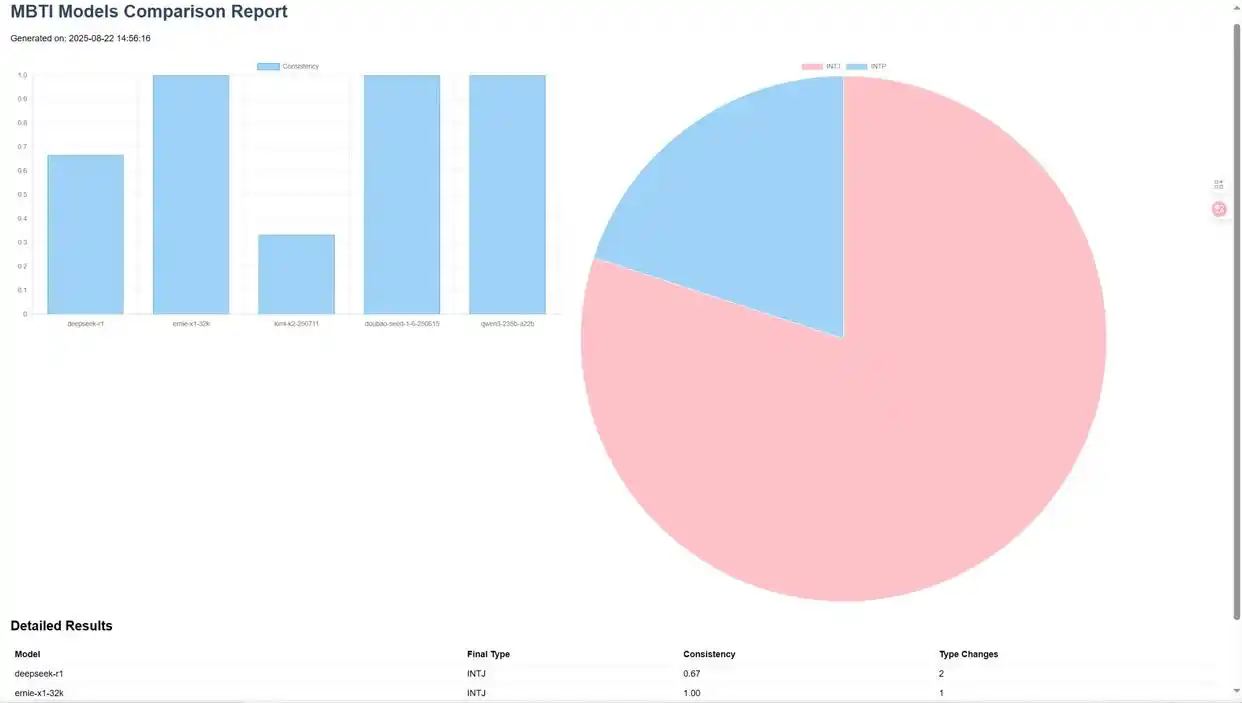

六、展示成果

最后,我们借助Zulu的代码解读功能来总结我们的项目成果:我们成功实现了一个测试不同LLM模型MBTI性格类型的Python项目,主要功能包括:

1. 核心测试功能:

-

使用标准MBTI测试题目评估LLM模型

-

支持批量测试多个模型

-

异步执行提高测试效率

-

多轮测试评估结果稳定性

2. 报告系统:

-

生成单个模型的详细HTML报告

-

创建多模型对比报告

-

包含可视化图表展示测试结果

-

记录历史测试数据

3. 技术特点:

-

基于Python 3.12开发

-

使用aiohttp等异步库

-

集成Chart.js进行数据可视化

-

完善的日志记录系统

4. 测试结果示例:

轻松搞定大模型测试器,效率提升不再是梦

-

我们测试了五种主流的LLM模型。

-

结果显示,大多数模型都倾向于INTJ性格类型。

-

不同模型的测试结果在稳定性上各有差异。

从构想到实现,只需要短短5句话和不到30分钟,在文心快码的支持下,我们成功打造了一个大规模MBTI测试器,用于自动化评估模型。这种事情过去可能需要几位同事一起合作,花费几天时间才能搞定,而现在一个人就能轻松完成。尽管这个项目的代码量不小,但整个过程即使是不懂编程的人也能顺利完成。AI编程已经不再是开发者的专属工具,它变成了日常工作中的效率提升助手,可以帮助自动化处理那些繁琐的任务,让大家更专注于有价值的方案设计和策略规划。

这种方法挺有创意的,能帮助我们更好地理解AI的特性。

能不能分享一下如何设计有效的测试用例,避免耗时的问题?

文心快码真的能自动生成代码?那以后工作是不是轻松很多?

用文心快码自动生成代码,有点像科幻小说中的情节,真让人期待。只希望别在实践中遇到坑。

我之前手动测试模型的时候,确实觉得费时费力,希望文心快码能解决这个问题。

能不能提供一些文心快码的具体使用案例?这样更方便我们理解。

文心快码的需求明确性很重要,能否提供一些具体的需求示例?这样更容易上手。