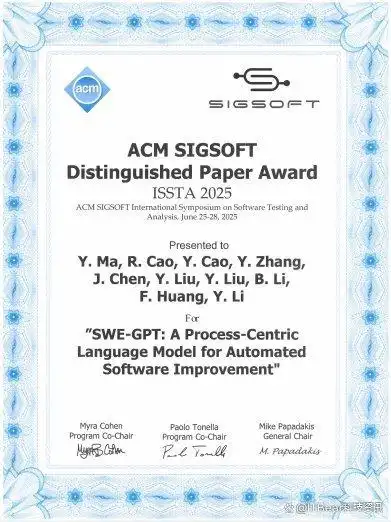

通义灵码的SWE-GPT在国际软件大会上获奖,揭示AI在软件开发的潜力

7月3日的消息,国际知名的软件领域会议ISSTA 2025(国际软件测试与分析研讨会)刚刚颁布了最高荣誉——杰出论文奖。而通义灵码的SWE-GPT软件工程大模型从500多篇投稿中脱颖而出,成为唯一获得这一奖项的企业论文,真是令人振奋。

说到软件开发,其实是大模型应用最迅速的领域之一。不过,现有的大多数模型主要是通过静态代码进行训练,缺乏对软件开发过程中动态互动、工具使用、迭代问题解决以及演变特性的深入理解,这让它们在实际应用时常常力不从心。

据说,通义灵码的SWE-GPT是基于通义千问Qwen2.5模型构建的。在后期训练中,团队特别模拟了人类程序员的思维过程,学习如何解决软件工程中的复杂问题,进行端到端的多步骤处理。而且,他们还创新性地使用合成数据进行模型训练,模拟真实软件开发过程中的动态交互和迭代问题解决,比如代码库的理解、故障排查和补丁生成,这些都有效克服了当前大模型的局限。

在训练阶段,通义灵码团队采用了课程学习的方法,随着训练的推进,逐渐引入当前模型未能解决的新问题,确保模型可以稳步提升其基础能力,真的是个不错的策略。

之前的实验显示,在权威基准SWE-bench-Verified(包含500项真实GitHub任务)的测试中,SWE-GPT 72B的解决率达到了30.20%,刷新了开源记录,较Llama 3.1 405B提升了22.76%。这一成绩几乎与同一时期的闭源模型GPT-4o相媲美。而轻量化的SWE-GPT 7B模型以18.20%的解决率超越了Llama 3.1 70B(17.20%),展现了小模型在复杂软件维护任务中的价值。

更值得一提的是,SWE-GPT是一个通用框架,可以不断扩展。比如,基于它可以引入更强的思考能力和测试时扩展(test-time scaling)。而小尺寸(32B)的模型在SWE-bench-Verified上的解决率达到了46%,接近业界领先的闭源模型Claude 3.5 Sonnet v2(46.20%)和OpenAI o1(45.60%)。

ISSTA的评审委员会专家对此评价道:“SWE-GPT是一种创新的以‘软件开发流程为中心’的大语言模型,它提出的数据合成方案真实模拟了实际软件开发过程,这在AI辅助软件开发领域具有重要意义。”

通义灵码算法的负责人李永彬表示:“基于大模型的软件工程智能化研究和应用正在快速发展,但单靠现有的基础模型仍无法满足真实场景的需求。SWE-GPT为AI辅助软件开发提供了新的范式。”

值得一提的是,ISSTA是软件工程领域最具影响力的学术会议之一,汇聚了学术界和工业界的前沿研究与应用。今年的ISSTA共收到550篇投稿,最后录用了107篇,其中只有9篇被评为杰出论文,竞争可想而知。