AI 编程 IDE 的 Plan 模式大比拼

现在的开发需求越来越复杂,为了帮助大家更轻松地应对这些挑战,许多 AI 编程 IDE 都推出了新的 Plan 模式。这种模式的目标是自动分解任务,规划开发步骤,同时生成代码框架,减轻开发者的负担。

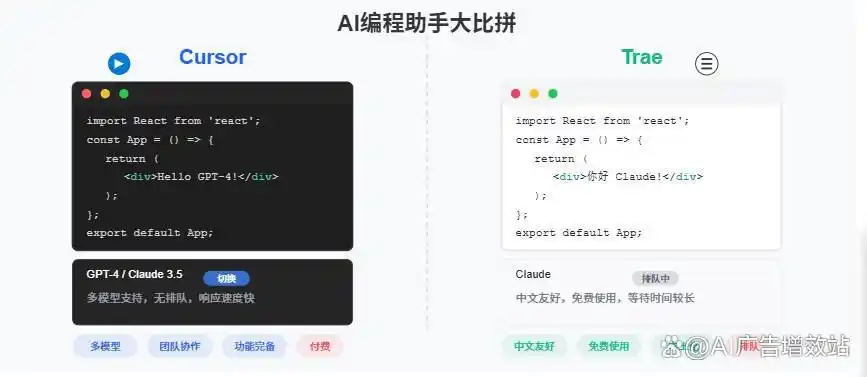

除了阿里的 Qoder Quest 是收费的,腾讯的 CodeBuddy、字节跳动的 Trae 和百度的 Comate 免费版都具备这个功能。而 Cursor 在10月发布的2.0版本中已经相对成熟了。接下来,我们就来看看这些工具的 Plan 模式和 Cursor 之间的对比。

我们在测试中使用了一些提示词来评估这些工具的规划能力:

开发一个完整的HR管理后台系统,包含员工信息管理、考勤记录、薪资计算、绩效评估和招聘管理模块。

系统需要实现用户权限分级(管理员、HR专员、普通员工)、数据可视化报表生成、以及Excel导入导出功能。

界面设计要简洁现代,确保响应式布局适配不同设备。

提供完整的API文档和单元测试覆盖。测试结果概览

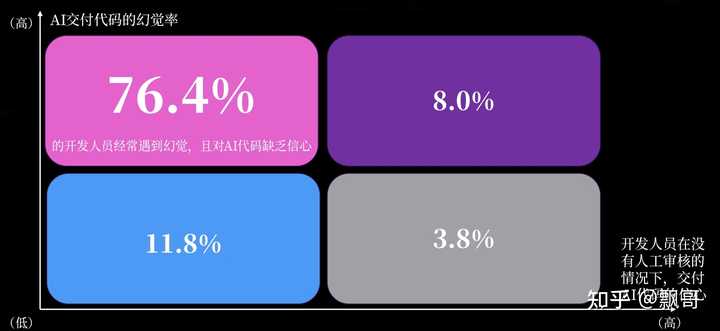

直接说结论吧:所有工具的 Plan 模式都没法自动完成整个项目,后续还是得依赖开发者进行大规模的手动调试和修复。

- Trae:需要进入 SOLO 界面来启动 Plan 模式,结合调试功能可以边开发边调试,完成度算是最高的。但是生成的系统依然需要逐一修复 Bug。

- Comate:相比三个月前的测试,明显进步了,能够生成前端界面,不过功能上还是无法操作,同样需要逐个修复问题。

- CodeBuddy:生成的 TypeScript 代码错误不少,修复的过程简直像“打地鼠”,解决一个又冒出几个,最终不得不放弃。

- Cursor:因为要求配置数据库(没给示例),对不熟悉后端的用户来说,形成了一个门槛,结果只能中止。

关于耗时:Trae SOLO 用时最长(超过3小时),CodeBuddy 平均用时1小时多,Comate 不到1小时,Cursor 仅用15分钟就“完成”了规划,虽然无法运行。

计划文档与任务执行

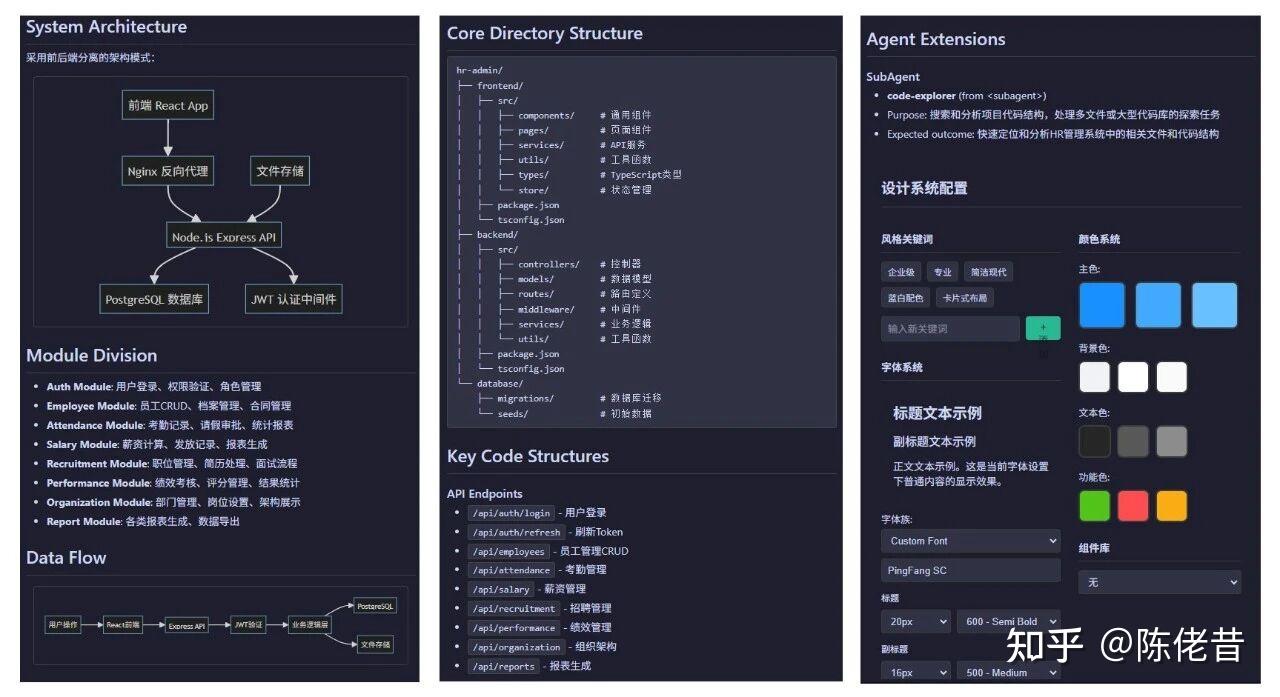

在生成的计划文档方面,CodeBuddy 表现得最为出色。

它2025年12月21日的新版本提供的计划内容非常丰富,涵盖了前端界面、后端数据、设计配色以及整体架构。

其次是 Cursor 和 Trae,它们的计划虽然包含了数据设计,但相比 CodeBuddy 缺少了 UI 配色设计和流程图等细节。Comate 的计划则比较简单,主要列出了项目文件结构和开发步骤。

而且,Trae 还修正了早期版本中那种“开发周期需1-2周”的不合理描述,听起来更符合实际。

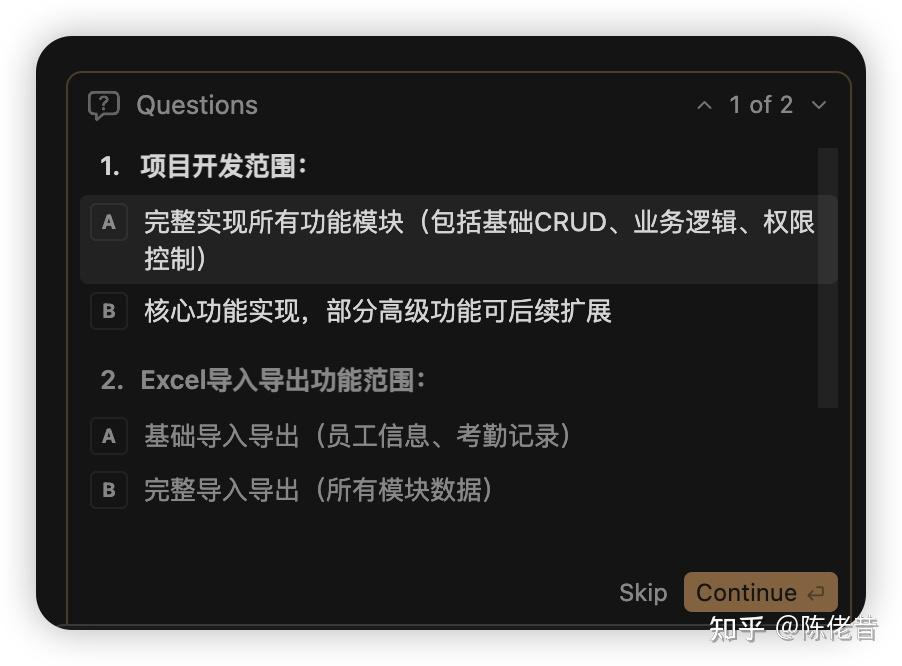

把计划转化为可执行任务又是另一回事。除了 Cursor 能严格按照计划生成任务,其他工具或多或少会对任务进行一些调整。在计划与任务一致性方面,Cursor 表现得更好。

在交互细节上,Cursor 也有明显的优势。它在任务开始前设有“需求澄清”和“技术方案选择”环节,用户可以通过鼠标或键盘进行确认。而其他 IDE 通常需要用户手动输入指令。

CodeBuddy 也有一些亮点,新版本允许用户自定义任务执行顺序,比之前更灵活,任务中断后恢复也更便捷。

总体来说:Cursor 在交互细节、文档交付和任务执行一致性方面更胜一筹;CodeBuddy 在交互和文档方面有亮点;而 Trae 和 Comate 则更偏向传统的“程序员工具”,在细节处理上还有待优化。

番外:后端代码评分

由于最终都没有顺利获得可运行的系统,我们决定评估一下各工具生成的后端代码质量。

作为前端开发者,我使用 Cursor 的 AI 根据以下标准给这些代码打分:

- 架构设计 (20分):模块化设计、分层架构、依赖注入、可扩展性各5分

- 代码质量 (20分):代码规范、类型安全、代码复用、代码注释各5分

- 安全性 (20分):身份认证、权限控制、数据验证、安全配置各5分

- 数据库设计 (15分):实体设计、迁移管理、查询优化各5分

- 错误处理 (10分):异常处理和错误提示各5分

- 测试覆盖 (10分):单元测试和集成测试各5分

- 文档和工具 (5分):API文档3分、开发工具2分

各工具后端代码评分结果如下:

| 打分项目 | Codebuddy | Comate | Trae | Cursor |

|---|---|---|---|---|

| 架构设计20 | 17 | 10 | 10 | 17 |

| 代码质量20 | 16 | 10 | 13 | 15 |

| 安全性20 | 16 | 12 | 12 | 16 |

| 数据库设计15 | 12 | 8 | 11 | 12 |

| 错误处理10 | 6 | 4 | 4 | 6 |

| 测试覆盖10 | 0 | 0 | 3 | 2 |

| 文档和工具5 | 4 | 1 | 4 | 4 |

| 总计 100 | 71 | 45 | 57 | 72 |

Codebuddy 的代码是基于 GLM 4.6 生成的,其他 IDE 则使用的是 Auto,可能是自研的模型。

根据评分,各 IDE 生成代码的主要问题总结如下:

CodeBuddy 在架构和代码质量上表现较好,不过在测试缺失、安全配置不足和文档不完善方面还有待加强,具体包括缺少单元测试和集成测试、全局异常处理、数据库索引、请求限流等安全配置,以及关键业务代码的注释。

Comate 的问题比较全面,涉及架构、安全、测试和工具链等多个方面。它的代码缺乏数据输入验证;Service 层缺失导致 Controller 过于臃肿;未使用 TypeScript,类型安全无法保障;同时缺少依赖注入、数据库迁移管理、全局错误处理机制、数据库索引、单元测试和集成测试,以及 Swagger API 文档。

Trae 的问题主要集中在架构分层、安全实践和类型安全上。它的代码缺少 Service 层和数据验证库,也缺少全局错误处理中间件和依赖注入框架。在安全方面,JWT 密钥使用了默认值,CORS 配置也需要改进。此外,在 TypeScript 中使用了 any 类型,并且缺少数据库迁移管理。

Cursor 的代码整体架构较为完整,但在细节和工程化实践上还有提升空间,具体问题包括:缺少单元测试和集成测试;缺少全局异常过滤器和统一的错误响应格式;JWT 密钥使用了默认值;TypeScript 未启用严格模式,存在较多 any 类型;缺少数据库索引以及对复杂业务逻辑的注释。

需要说明的是:这些评分仅基于代码静态分析,仅供参考。例如,虽然 CodeBuddy 评分较高,但实际运行时 TypeScript 错误很多,修复的成本也很高。同时,大模型迭代很快,本文结论基于2025年12月底的测试,未来情况可能会有所变化。

Trae SOLO用时超过3小时,真的太久了,开发效率能不能再提升一下?

我对这个AI编程IDE的对比分析很感兴趣,下一步会不会有更深入的功能评测?

我觉得如果能更直观地展示新功能,开发者的接受程度会更高吧?

使用Trae SOLO时,开发者需要耐心等待,真的有人能忍受这样长时间的开发吗?

使用CodeBuddy时,修复错误的过程让我感到无比挫败,真不知道有没有更好的解决方案。

对于新手来说,Cursor对数据库的配置要求确实是个门槛,建议可以提供更友好的引导。

对比后发现,Trae的调试功能非常实用,边开发边修复Bug的体验确实提升了效率。

Trae SOLO用时过长,是否会让开发者选择放弃?

下次能不能试试让这些工具有个对比视频?这样一目了然,能更好理解它们的差异。

用CodeBuddy修复Bug时的挫折感太真实了,谁能给点建议让过程更顺畅?