这个问题是在2025年秋天提出来的,参考的模型包括:GPT-5、Claude Opus 4.1/Claude sonnet4.5、Gemini 2.5 Pro。

看了大家的讨论,感觉都挺有道理的。不过,在我们深入分析之前,先问大家一个问题?

究竟是什么让这些大型语言模型各有“超能力”? 是它们的架构设计独特,还是训练数据的“知识秘方”?是模型对齐的微调技巧,还是开源与闭源的基因秘密?只有搞清楚这些核心要素,我们才能理解模型的“天赋”,并在AI的浪潮中,为不同场景找到最合适的“数字大脑”。

与其纠结于ChatGPT、Claude和Gemini之间的区别,不如先聊聊市面上主流模型各自擅长的领域。接下来,我将简单扩展一下这个问题。本文将从模型的架构、训练数据、模型对齐、开源与闭源等多个角度,分析是什么让大型语言模型脱颖而出;然后我会对这些模型进行对比,看看它们的特点和优势,也就是各家大模型分别擅长什么;最后结合前面的分析,针对不同的场景提供一些具体的选择指南。

如果观点有局限或不当之处,欢迎大家一起讨论交流。

到底是什么让大型语言模型如此与众不同?

在我们开始比较模型之前,先要弄清楚是什么让一个大型语言模型跟另一个不同。主要有三个因素决定了模型的能力和“个性”。

架构(Architecture)

现今的所有大型语言模型基本上都基于一种叫做Transformer的架构。这种突破性技术推动了最近的人工智能革命。它的核心原理是并行处理整个序列,而不是一个词一个词地处理。关键在于一种叫自注意力机制(self-attention)的技术,模型因此能判断上下文中不同词语的重要性,从而理解超长文本中复杂的关系。

不过,在这个框架下,有一些关键的变体值得关注。

最大的区别在于密集模型(Dense)和混合专家模型(Mixture-of-Experts,简称MoE)。

像GPT和Claude这样的密集模型在处理每个输入时都会激活所有参数。可以想象成用整个大脑思考每个念头。

而像Gemini、Mistral和Llama 4这样的MoE模型则不同。它们会根据任务选择性地激活某些“专家”子网络。因此,它们不是唤醒每一个神经元,而是将问题导向擅长解决该类问题的特定专家。这让它们在保持每次查询计算量较低的同时,也能扩展到更大的规模。

此外,GPT-5还引入了一种基于路由器的架构,能够根据任务的复杂性自动在不同模型之间切换。简单的查询由快速模型处理,而复杂的难题则由深度推理模型来解决。

DeepSeek则采取了另一种策略,它训练强大的基础模型,然后通过大规模偏好优化来支持显式的多步推理。大多数版本都提供一个“推理”端点(为难题提供更多步骤)和一个低延迟的“快速/轻量”端点,供普通聊天使用。

另一个显著差异是上下文窗口(context windows),也就是模型一次能“记住”多少文本。这方面的范围从低端的128,000个词元(token)到Llama 4 Scout的1000万个词元。

虽然架构告诉我们模型如何处理信息,但真正决定它思维方式和知识储备的,接下来要讲的内容……

训练数据(Training data)

这或许是区分模型专长领域的最大因素。

比如,GPT-5是在大量多样化的互联网数据、书籍和学术论文上训练出来的,因此它是个通才,几乎能聊任何话题。

而Gemini不仅吸收了数万亿文本词元,还包括视频帧和音频,这让它拥有强大的原生多模态理解能力。

Claude则注重高质量的代码和结构化文档,这也是它在技术精度和执行复杂指令方面表现优异的原因。

Grok能够实时获取X平台的数据流,因此它能从Twitter上获取当前、未经筛选的观点。

Llama 4则在文本、图像和Meta社交平台上进行训练,因此它在不同模态上都具备均衡能力。

DeepSeek则融合了广泛的网络文本、代码、数学和双语(中/英文)资源。这种组合让它在符号操作方面表现出色,同时在编码和通用英语应用中也保持稳定。

尽管使用相同的训练数据,不同模型的表现可能也会大相径庭。这是因为初始训练后发生的事情也是模型形成真正个性的关键阶段。

对齐(Alignment)

然后就到了第三个因素:微调和对齐。

这基本上是在初始训练后进行的专业化阶段。

这里有几种不同的流程。

监督微调(Supervised Fine-Tuning,简称SFT)是模型从精心策划的“指令-响应”对中学习的过程。你给它展示“总结这份文档”的例子,并附上理想的摘要。这样一来,模型就能学会如何遵循指令和处理特定任务。

基于人类反馈的强化学习(Reinforcement Learning from Human Feedback,简称RLHF)则是让多个评审员对模型的多个输出进行排序,模型因此学习偏爱高评分的响应。这是将模型的行为与人类价值观和偏好对齐的方式。

此外,还有直接偏好优化(Direct Preference Optimization,简称DPO),这是一种更新、更稳定的RLHF替代方案。它直接在偏好数据上进行优化,无需独立的奖励模型,速度更快,计算量更少,预计在2025年将越来越多地应用。

不同公司在对齐理念上各有千秋。

Anthropic为Claude采用了一种名为“宪法AI”(Constitutional AI)的方法,让模型从一系列伦理原则中学习。这样,Claude既谨慎又注重安全(有时甚至过度)。

OpenAI则在GPT-5中结合了传统的RLHF与新的路由器系统。基础模型经过广泛的人类反馈循环,重点关注有用性和无害性,而路由器层通过选择合适的模型复杂度,增加了另一层对齐。这种双重方法旨在平衡不同任务类型下的能力与安全性。

与此不同的是,xAI对Grok采取了另一种方式。尽管其强化学习计算量是竞争对手的10倍,但它的内容过滤却相对较少。因此,您得到的是一个经过深度对齐的模型,讨论内容的限制较少,响应也更自然、更自由。

DeepSeek则通过偏好风格的优化,专注于数学逻辑和软件任务的准确性。它的风格倾向于简洁明了,而不冗长。

关键在于,这些对齐选择会极大影响模型如何实际响应您的问题。Claude可能会拒绝回答GPT-5会接的题,而Grok则可能给出其他模型不会提供的未经过滤的观点。

在我们审视具体模型之前,其实还有一件事比架构、训练数据或对齐更重要,尤其是在为您的项目做决策时,而大多数初学者往往忽视这一点。

开源 vs. 开放权重 vs. 闭源模型

许可证(Licensing)。这一点比大多数人想象的要重要得多。

有个普遍的误解是认为“开放”在所有模型中都代表同样的意思,但实际上情况复杂得多。

我来把它分成三种不同的类别。

第一种是闭源API模型。这类模型需要你调用其云服务,而你完全无法获取其权重。模型权重(model weights)就像是学习到的参数,包含了模型所有知识的数值。对于闭源模型来说,这些权重都被锁在供应商的服务器上。像GPT-5、Claude、Gemini和Grok这样的大牌都属于这一类。你基本上是通过API租用对模型的使用权。

另一种选择是开放权重模型(Open-Weight models)。这就让情况变得复杂……开放权重意味着模型权重可以下载,但通常伴随着有限制的自定义许可证。

Meta的Llama系列就是个典型例子。你可以下载权重,但许可证中对商业使用、用户数量或竞争对手使用等方面有许多限制。

最后还有采用宽松许可证的OSI开放模型(OSI-Open models with permissive licenses)。这些模型是在标准开源许可证下发布的,如Apache 2.0、MIT或BSD。这个选项的限制最少——你可以自由修改、微调、托管,并在商业上使用,几乎没有限制。

这类模型的例子包括大多数Mistral模型、Falcon、一些Kimi的版本以及Gemma的变体。

DeepSeek则采取了一种混合形式:一些检查点是开放权重(可下载,但有自定义条款),而其他特定尺寸和变体则是OSI开放的。

所以要记住:开放权重并不等于开源。仅仅因为你能下载权重,并不代表你可以自由使用它们。

这到底为什么重要?以下是关键点:

法律合规性: 带有自定义许可证的开放权重模型要求你仔细阅读条款。可能会有商业使用、用户数量或竞争性方面的限制。闭源API则受可能变更的使用条款约束,完全听从供应商的决定。这意味着像OpenAI这样的供应商对你的项目有很大的控制权。

再来说说控制与隐私: 闭源API意味着你的数据会进入供应商的云端。虽然如今的企业级选项提供了强大的隐私控制,但根本上来说,你的数据还是离开了自己的服务器。而使用开放模型,你可以将所有东西都保留在内部。

还有定制化: 开放模型让你拥有完全的微调能力和控制权。闭源模型则限制你在提示工程(prompt engineering)和对小范围变体的微调上,你需要在它们的系统内工作。

当然,成本也是个问题: 闭源模型按词元计费,没有基础设施负担——对于流量波动大或用量少的情况来说很合适,但在大规模使用时成本会高得惊人。开放模型需要前期的基础设施投资,但在高用量下,单位词元成本会大幅下降。

选择合适模型的秘密武器

首先,我们得聊聊质量: 当前的闭源前沿模型在推理能力和可靠性方面仍然占优。不过,开放模型的表现也在迅速提升,尤其是在一些小众的细分领域和微调任务上,它们可是有自己的亮点。

接下来,我给你一个简单的决策流程:

你是不是需要自己托管数据,或者必须把数据保留在内部?比如说,如果你在医疗或金融这样的行业,法规可严了。这种情况下,开源或开放权重模型就是你的唯一选择。

你是不是对新颖或复杂任务的准确性有严格的要求?那么,选择闭源的前沿模型,如GPT-5、Claude或Gemini,可能更适合你。可以考虑把开放模型作为备用,以备不时之需。

如果你在一个对成本非常敏感的大规模环境中工作,混合方案可能最有效。你可以把70%到90%的流量导向开放模型,然后把10%到30%的复杂查询交给闭源API,这样既能保证质量又能控制成本。

如果你觉得法律风险让你不太舒服,或者团队规模小,老实说,直接用闭源API开始最简单。这样上手快,以后再考虑开放模型也不迟。

好了,既然你对模型的各项特点和许可证对选择的影响有了了解,我们来看看具体的模型吧。我们先从五个主要的前沿模型开始,然后再转向一些专业选项,那儿的情况会更加有趣。

模型比较概览 — 前沿模型

现在来聊聊具体的模型吧。我们从那些主要的前沿模型说起。

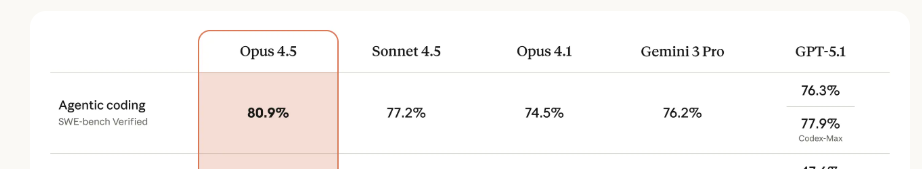

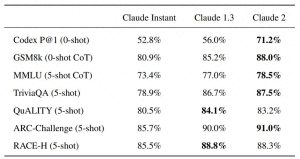

不过在深入之前,我想提醒你关于基准测试的重要性。

很多基准测试都是供应商自己做的,未必能做到真正的“同类”比较。因为不同的测试使用了不同的提示策略,有的允许使用工具,有的则不允许,评估的方法也各有不同。所以在这篇文章中,我不会提供具体数字。

我建议你创建20到50个代表你实际应用场景的提示,测试2到3个候选模型,然后根据准确性、成本和速度等因素进行评分。

你的特定应用场景比这些通用的基准数据要重要得多,不要盲目相信排行榜。

好了,带着这个免责声明,我们来看看这五个模型。

GPT-5 (OpenAI)

GPT-5在8月发布,适用于通用目的、创意写作、美学编程(比如构建漂亮的用户界面)以及健康相关的查询。它的路由系统能自动处理各种任务,操作起来非常简单。

上下文大小为40万词元,但它有时会显得有点啰嗦,一些用户反映因为模型自动切换导致质量不稳定。我个人对它的写作风格也不是特别满意。

Claude Sonnet 4.5 (Anthropic)

Claude Sonnet 4.5在2025年9月发布,是一个混合专家模型,拥有超大的词元上下文窗口。

它非常适合软件开发、智能工作流和桌面自动化。个人觉得它在专业写作方面的表现比GPT-5更出色。

不过,它有点过于谨慎,有时会拒绝回答其他模型会回应的问题,而且成本也高于大多数竞争对手。

Llama 4 (Meta)

Llama 4同样于2025年问世,是首个采用MoE架构的多模态Llama模型。

它有三个变体:Scout有1090亿参数和1000万词元的上下文——不过这只是个设计目标,实际上下文的大小还得看你的基础设施。Scout最大的亮点在于,通过int4量化,它可以在单个H100 GPU上运行。这意味着你可以自己部署这个前沿级别的模型,真是太棒了。

Maverick则有4000亿参数和大约100万词元的上下文,而拥有2万亿参数的Behemoth还在训练中,推迟到2025年底或2026年初发布。

值得一提的是,Llama 4是开放权重的,但并不是完全开放的。例如,许可证限制月活跃用户超过7亿的使用。所以虽然可以下载,但有条件。

Llama非常适合本地部署、定制企业解决方案以及利用Scout庞大上下文进行的大规模文档处理。

不过,你需要一些技术背景来部署它,并且要注意许可证的限制。

Grok 4 (xAI)

来自xAI的Grok 4于2025年7月发布,拥有约5000亿参数,Grok 4 Fast的上下文窗口达200万词元。

它在数学和科学推理方面表现出色,还能实时获取来自X平台的数据。

它的局限性在于过滤较少,这在某些应用场景中可能会引发争议。目前它主要与X平台集成。

预计Grok 5将在2025年底发布,他们称其“好到令人发指”,我们拭目以待……

DeepSeek

DeepSeek是一款最新的推理优先模型,于2025年推出。它将一个为解决复杂问题而设计的、速度较慢但更精准的“推理”模式与一个为日常工作而设的、速度更快的“轻量”模式结合在一起。

上下文窗口因版本而异(在标准端点上通常为数十万词元),定价方面也相对有竞争力。

实际使用中,它在数学、逻辑和代码密集型任务上表现优秀。许可证从开放权重到更宽松的版本都有,具体条款要看你选择的模型。

Gemini 2.5 Pro (Google)

最后是Gemini 2.5 Pro。它的上下文窗口高达100万词元,预览配置和路线图上还有更大的窗口。

Gemini原生支持多模态,并具备深度研究模式,适合进行复杂的数据分析和研究任务。它与谷歌的生态系统(搜索、地图等)有深度整合。

不过在纯编码方面,它稍微落后于Claude和GPT-5。但预计Gemini 3将在2025年第四季度推出,并会有显著的编码改进,所以这种情况可能很快就会改观。

好了,以上就是主要的前沿模型。但许多人在这里会犯个错误,认为越大越好。有时候,选择一个更小、更专业的模型,成本仅为前者的几分之一,可能更明智。让我来给你解释一下。

模型比较概览 — 专业模型

刚才提到的是大型前沿模型,但通常更有趣的决策发生在这些更小、更专业的模型上。接下来我们来深入了解这些。

Mistral的产品线

Mistral的核心理念是效率,他们声称你可以以10%的成本获得90%的性能。Mistral Medium 3在仅需4个GPU的情况下,性能接近Claude Sonnet 3.7,且成本更低,非常适合关注成本效益的生产环境。Mistral Small 3.1则是一个拥有240亿参数的模型,采用Apache 2.0许可证,每秒能处理150个词元,适合客户服务机器人等高吞吐量应用。

Cohere Command模型

Cohere专注于企业级应用,具有强大的合规特性。Command R+在带有引用的问答方面表现出色,拥有128K上下文和多语言支持,非常适合需要可靠信源的企业聊天机器人。Command A于2025年3月推出,拥有256K上下文,并为推理、翻译(覆盖23种语言)和视觉任务提供了专门版本。

月之暗面 Kimi

Kimi是智能体领域的专家。Kimi K2是一个拥有1万亿参数的混合专家模型,权重开放,专为AI智能体设计。它具备实时网络搜索、多模态能力和用于自我反思的特殊架构。Kimi-Dev-72B变体在SWE-bench上创下了开放模型中的记录,使其成为需要搜索、编码和验证结果的自主研究智能体的理想选择。

Qwen模型

阿里巴巴的Qwen系列提供了强大的开放权重替代方案。Qwen 2.5的尺寸从5亿到720亿参数不等,其中许多采用Apache 2.0许可证。72B变体在许多基准测试上与GPT-4的表现相当,同时完全开放。Qwen 2.5-Coder专门针对编程任务进行了优化,具有强大的多语言代码生成能力。

当然,还有更多模型!不过这些是市场上比较主要的参与者。

但这仍然没能回答最重要的问题:你究竟该用哪一个?让我根据真实的应用场景,为你提供一个简洁的决策矩阵。

决策框架

现在我们已经介绍了这么多模型,接下来我们聊聊在特定任务中究竟该选哪个。

步骤1:选择你的许可证

这是我的核心建议:法律限制必须优先于技术选择。先选择许可证,再选择模型。

你可以从问自己以下问题开始:

你是否处理客户的个人身份信息(PII)或受保护的健康信息(PHI)? 如果是,那你需要本地部署的开放权重模型,或者与供应商签订特殊协议的闭源模型。

你是否需要在专有数据上进行微调? 如果是,那你需要像Mistral或Kimi这样的开源模型,或者像Llama这样的开放权重模型。闭源模型无法满足你所需的定制化。

你是一个需要快速迭代的小团队吗? 如果是,那就直接选择一个闭源API,比如GPT-5、Claude、Gemini或DeepSeek。这样能更快进入生产环境,验证产品市场契合度,然后再考虑后续的决策。

预算有限,想要大规模运作? 如果是这样,不妨试试建立一个路由器。简单来说,你可以把80%的请求交给开放模型,剩下20%的难题交给闭源模型处理。这样一来,既能保持效果,又能节省开支,真是一举两得。

步骤2:明确需求

好了,一旦你了解了许可证的限制,就可以根据任务的复杂度、类型、上下文要求和部署方式来进一步明确你的需求了。

按任务复杂度分:

- 对于简单的查询,比如常见问题解答,可以使用Mistral Small或者DeepSeek的快速模式。

- 中等难度的任务,比如写作或基础编码,Mistral Medium或GPT-5的快速模式就很合适。

- 复杂的推理任务,比如数学或研究,可以考虑使用Grok 4、GPT-5的推理模式或DeepSeek的推理模式。

- 而智能体工作流则可以选择Kimi K2或Claude Sonnet 4.5。

按上下文需求分:

- 如果词元量小于128K,任何模型都可以胜任。

- 128K到100万词元时,大多数前沿模型都能处理。

- 100万到200万词元呢?你就需要Gemini、Grok或Llama Maverick了。

- 依此类推。

按部署方式分:

- 想用云API的话,可以选GPT-5、Claude、Gemini、DeepSeek或Grok。

- 如果要自行托管,Llama、Mistral、Kimi都是不错的选择,当然在许可证合适的情况下也可以选DeepSeek的开放权重模型。

- 对于边缘或本地模型,像量化版的Mistral 7B的方案也可以考虑。

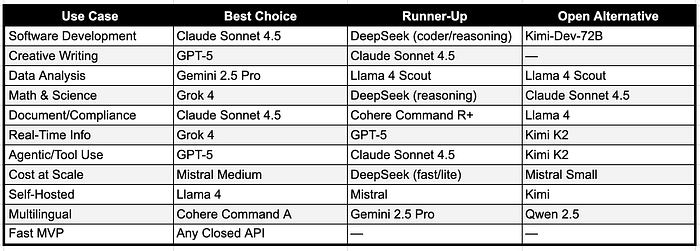

按任务类型分:

如同我们提到的,不同模型在特定任务上的表现各有千秋。下面是一个快速参考表:

这张表能给你快速的答案,但可别只靠这个来做决定。切记,下一步也不能跳过。

步骤3:建立评估流程

现在你已经锁定了2到3个候选模型,是时候进行测试了。

我们来聊聊怎么建立一个评估流程,让你对模型选择更有信心。

创建测试集

首先,别光信基准测试。像MMLU或HumanEval这样的公共基准虽然能做粗略筛选,但并不能告诉你模型在你特定应用中的表现。

你需要做的是:

至少创建20到50个能代表你实际应用场景的提示。如果你是在做客户支持机器人,就从真实的支持工单中提取问题;如果是代码生成,就用你项目的实际规范;总结文档的话,就用领域内的真实文档。确保你的测试集中包含常见查询、边缘案例、系统不该处理的范围外问题,以及用户可能犯的错误(比如拼写错误或模糊请求)等示例。

设计评估标准

接下来,评判结果不能凭感觉。你需要有结构化的评估标准。

想想看,在你的应用中,什么才算是一个好的回应。通常可以分成几个重要维度:

- 准确性: 信息是否正确?这是大多数应用中最重要的指标。

- 质量: 它是否真的解决了用户的问题?一个技术上正确但没用的回答是没意义的。

- 格式合规性: 输出是否符合你要求的结构?比如,如果你需要JSON,得到的是否是有效的JSON?

- 速度: 响应速度快不快?这点因应用而异。

特别重要的一步是制定一个评分标准(rubric),包含示例。比如,一个5分的响应应该是什么样的,得2分的又是怎样的?如果你使用AI裁判或多个人类评估员,这一点尤其重要。没有明确的标准,你的评分就会不一致或毫无意义。

选择评估方法

接下来,咱们聊聊怎么给这些响应打分。

对于简单明确的任务,比如选择题或数据提取,可以用精准匹配评分。当正确答案是“巴黎”时,输出“巴黎”就得1分,输出“法国”就得0分,你懂的。

对于灵活性要求高的任务,你可以考虑以下几种方法:

词汇相似度:衡量模型输出和参考答案之间词元的重叠程度,比如BLEU或ROUGE这样的指标。问题是,你需要全面的参考答案,而且重叠度高不一定就意味着质量好。

语义相似度:对大多数应用场景来说更好一些。它会把模型输出和参考答案进行嵌入,然后用余弦相似度进行比较。两个文本在词汇上可能不同,但语义上接近,比如“What’s up?”和“How are you?”。这不需要精确的参考答案,并且对灵活输出效果不错。

越来越多人开始用AI裁判来评估。你可以使用像GPT-5或Claude 4.5这样的强大模型来评估候选模型的输出。AI裁判速度快,相比人类评估员成本低,并且可以在没有参考数据的情况下运作。它们能评估毒性、幻觉和整体质量等方面,并且与人类的判断高度相关。

让AI裁判发挥作用的关键在于好的提示。包括评估任务、标准和评分系统。少样本(Few-shot)示例明显比零样本(zero-shot)效果好。给裁判展示什么是好的响应,什么又是坏的。

还要注意,AI裁判可能会不一致。同一个裁判在同一输入上,运行两次可能会给出不同的评分。所以,建议把温度(temperature)设置为0,以确保结果可复现,考虑多次评估后取平均分。

确定样本量

最后,测试集中需要多少个示例呢?

OpenAI有个实用的经验法则:如果你想检测的分数差异每减少3倍,就需要增加10倍的样本。

因此,如果你想检测30%的改进,100个样本就够了;但如果想检测3%的改进,那你得准备1000个样本。

大部分基准测试使用的样本在300到2000之间,所以起步至少100个,但如果条件允许,目标是300到1000个。

关键就是让你的测试集足够大,以确保可靠性,同时又不能太大,以便于操作。

好了,现在你已经为候选模型准备好了严谨的评估结果,接下来就该计算它们在大规模运作时的实际成本了。

步骤4:计算总成本

对于API模型,价格计算很简单,就是输入词元数乘以输入价格,加上输出词元数乘以输出价格,再乘以你的月用量。

(输入词元数 x 输入价格) + (输出词元数 x 输出价格) x 月度用量 = 总价

对于开放权重模型,你还得考虑硬件成本(GPU租赁或购买)、工程时间、薪资等等。

这就是今天选择模型的框架。不过,记得我这篇文章是2025年10月写的,科技发展飞快。让我给你简单预告一下接下来可能会发生的事情,帮你做好准备。