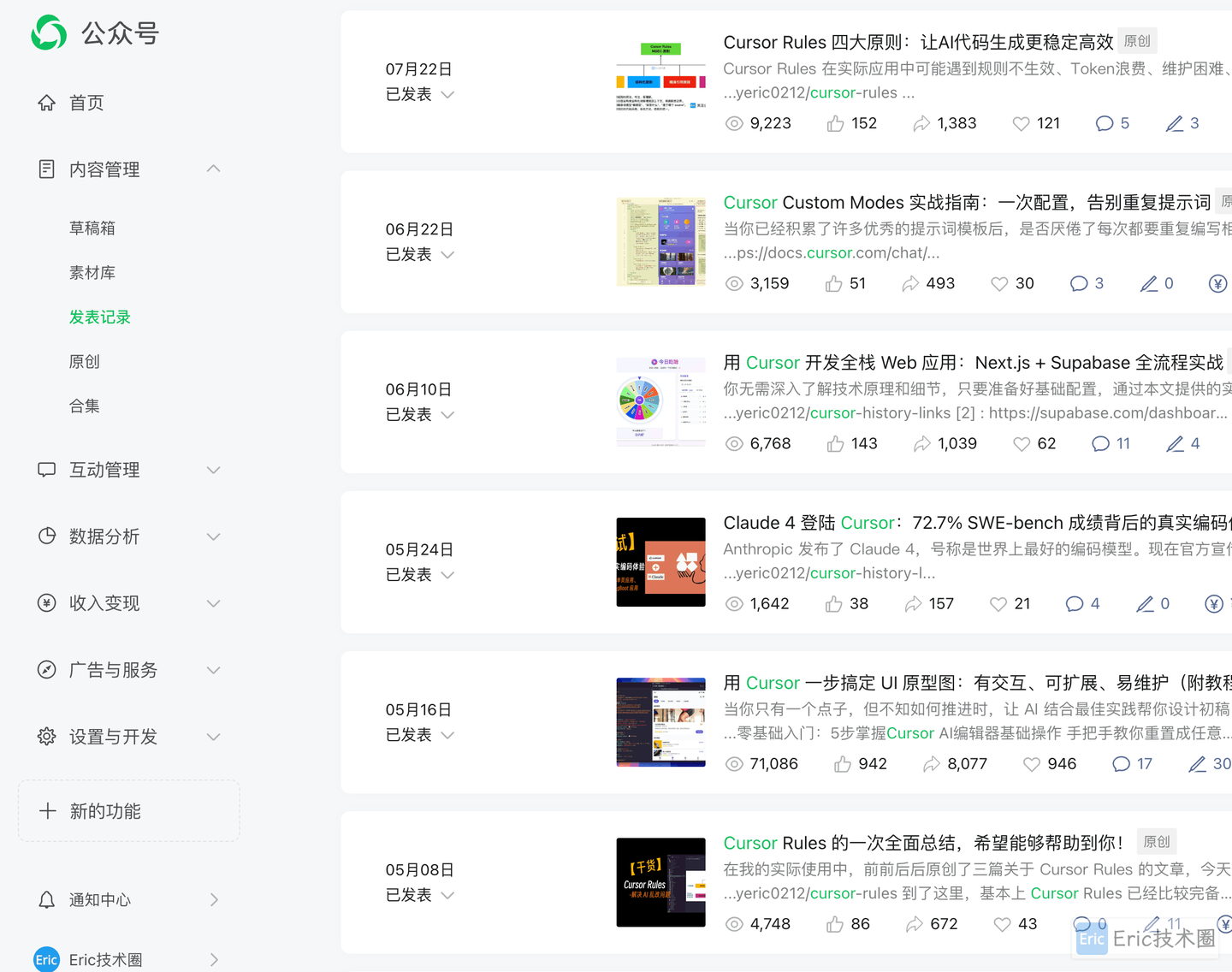

大家好,今天有个重要的消息要分享:火山引擎刚刚推出了豆包编程模型(Doubao-Seed-Code)。这个模型专门为 Agentic 编程任务进行了深度优化,最近在官方的 SWE-Bench-Verified 榜单上创下了新的记录,还兼容了像 Anthropic API 这样的主流开发环境。

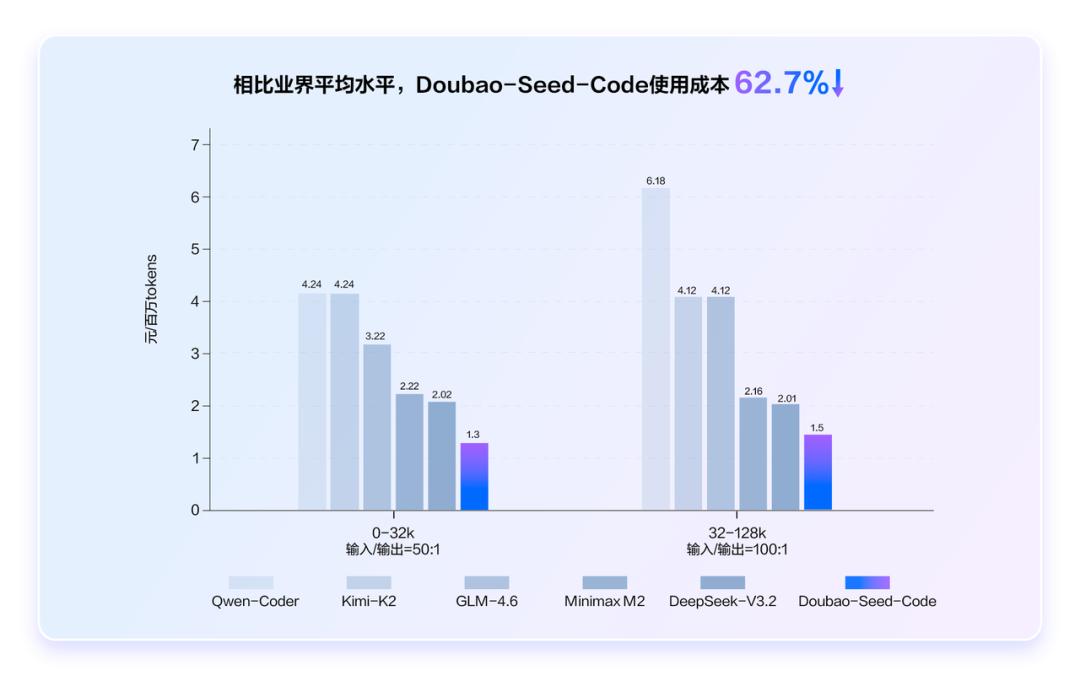

火山引擎还透露,豆包编程模型的综合使用成本比行业平均低了62.7%,可以说是“国内最低价”。现在,用户可以通过火山方舟平台获取这个模型的全量 API。对于需求大的个人开发者,订阅套餐“Coding Plan”首月只需9.9元,真是个好机会。

此外,TRAE 的中国版本也正式接入了豆包编程模型。为了更好地支持企业级 AI 开发,TRAE (CN) 企业版今天开始公测。

接下来,IT之家给大家带来官方的介绍:

深度优化于 Agentic 编程任务

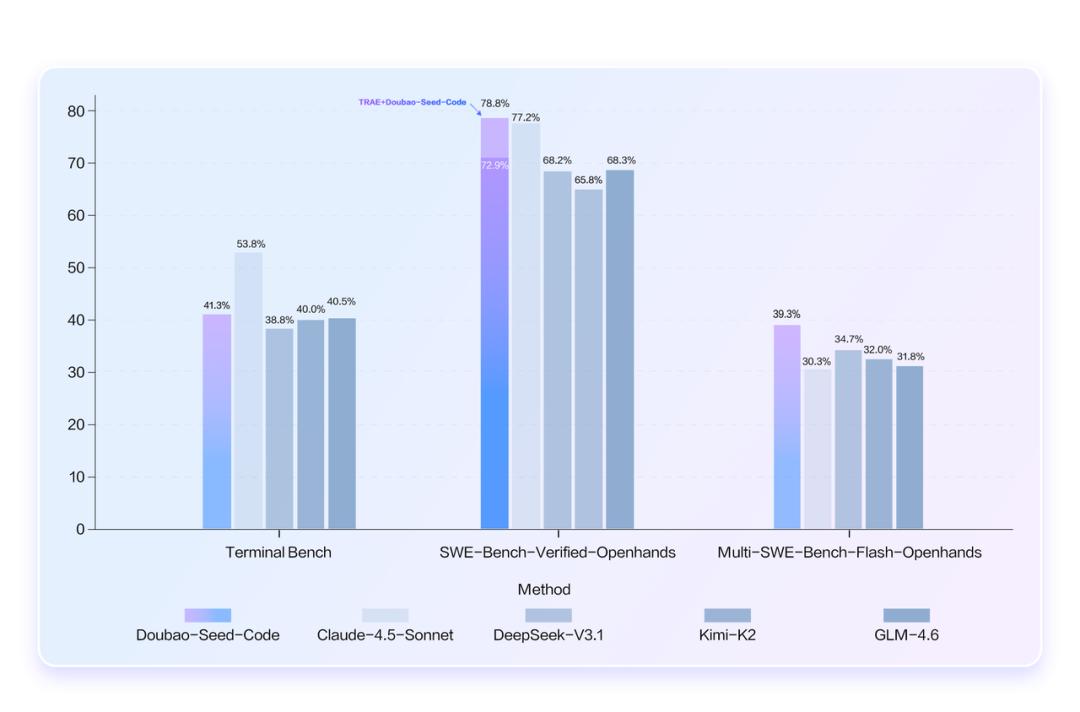

豆包编程模型经过深度优化,在 Terminal Bench、SWE-Bench-Verified-Openhands、Multi-SWE-Bench-Flash-Openhands 等多个权威基准测试中表现十分优秀,领先同类国内产品。

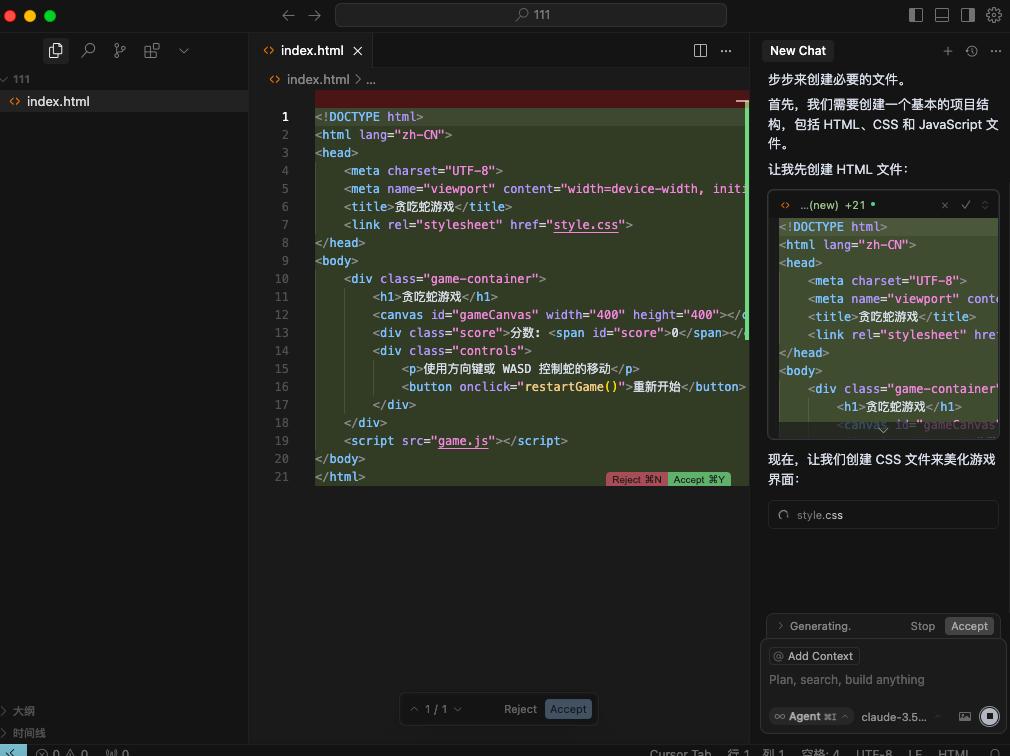

Doubao-Seed-Code 支持长达256K的上下文,轻松应对长代码文件和多模块依赖等复杂情况,完美支持端到端自主编程,在全栈开发中表现出色,尤其在前端开发方面更为突出。值得一提的是,这是国内首个具备视觉理解能力的编程模型,可以根据UI设计稿、截图或手绘草图生成代码,甚至能对生成的页面进行视觉比对,自主修复样式和Bug,大大提高了前端开发的效率。

为了更好地满足开发者的需求,Doubao-Seed-Code 还与 Anthropic API、TRAE 等主流开发生态兼容。使用 Claude Code 的团队只需短短几行代码就能切换到 Doubao-Seed-Code,享受更高性价比的服务。

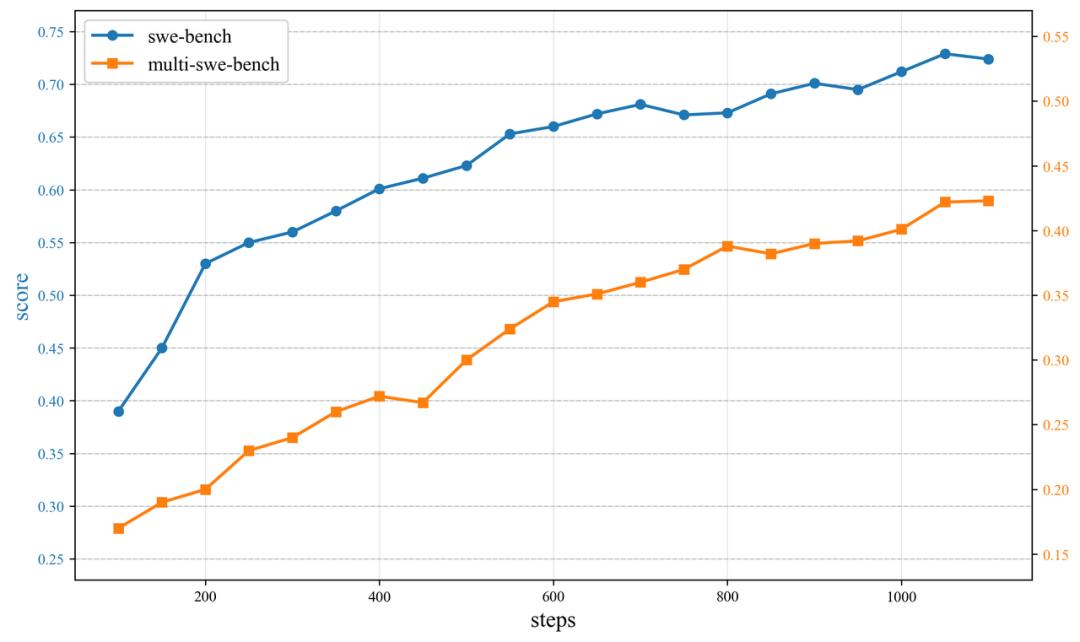

这个强大的性能是基于一套大规模的 Agent 强化学习训练系统。这套系统构建了一个包含十万容器镜像的庞大训练数据集,具备万级并发沙盒会话的能力,能够高效训练上千卡的单个 RL 任务。依靠这套系统,模型无需冷启动数据,完全通过端到端强化学习训练就能培养出顶尖的 Agent 能力,优化过程更加简单高效。

根据训练结果显示,模型在 Multi-SWE-Bench 和 SWE-Bench-Verified 数据集上的表现稳步提升,显示出良好的泛化能力。在 SWE-Bench 基准测试中,完全依靠 RL 训练的 Doubao-Seed-Code 模型就达到了顶尖水平,说明纯强化学习在实际编程场景中是有潜力的。

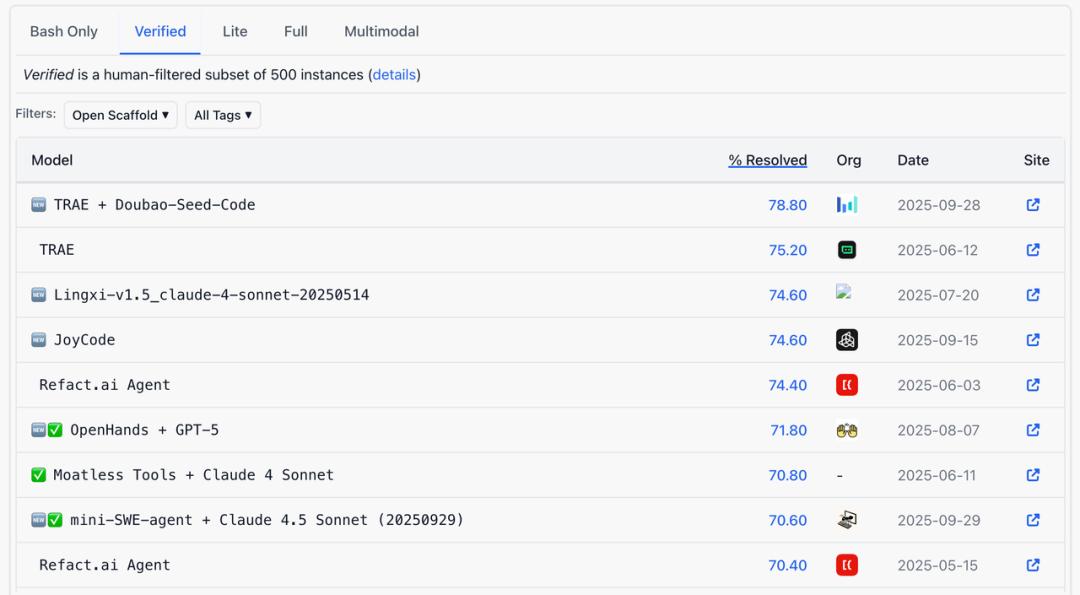

值得关注的是,在与 TRAE 开发环境深度结合后,Doubao-Seed-Code 在 SWE-Bench Verified 榜单中取得了 78.80% 的成绩,创造了新的 SOTA,充分证明了模型与工具深度适配后的协同效应。

超划算的开发体验,火山方舟为你开启新篇章

国内最低的综合使用成本,Coding Plan 优惠等你来享

说到 Doubao-Seed-Code,它不仅在性能上表现优异,更是把开发者的需求考虑得周全,让大家享受到最大的成本优惠。它采用了火山引擎首创的分层定价机制,并结合全透明的缓存能力,帮助用户在多轮对话中降低费用。总的来说,Doubao-Seed-Code 的输入和输出单价在国内算是最低的:

- 0-32k 输入区间:输入 1.20 元 / 百万 Tokens,输出 8.00 元 / 百万 Tokens

- 32-128k 输入区间:输入 1.40 元 / 百万 Tokens,输出 12.00 元 / 百万 Tokens

- 128-256k 输入区间:输入 2.80 元 / 百万 Tokens,输出 16.00 元 / 百万 Tokens

举个例子吧,想要建立一个好看的交互式英语学习网站,在相同的 Tokens 数量下(0-32k 输入区间),使用 Claude Sonnet 4.5 的成本大约是 4.05 元,而 GLM-4.6 则要 0.77 元,但 Doubao-Seed-Code 只需 0.34 元,真心划算。

此外,火山方舟还特别为个人开发者推出了“Coding Plan”优惠计划,最低只需 9.9 元就能畅享豆包编程模型!这个套餐不仅支持 Claude Code,还有 veCLI、Cursor、Cline、Codex CLI 等主流工具,结合火山方舟庞大的资源池,开发者可以得到稳定的算力保障,体验到流畅的编码过程。

豆包编程模型正式接入 TRAC (CN) 企业版,公测开始啦!

今天,TRAE 中国版正式接入了 Doubao-Seed-Code。作为国内首款 AI 原生 IDE,TRAE 为开发者提供了智能问答、代码自动补全、自定义智能体等全方位的 AI 编程能力。

对于企业开发者来说,现在 TRAE (CN) 企业版正式进入公测阶段,提供了比个人版更全面的升级:

企业场景优化:支持多达 10 万个文件和 15,000 万行代码的大型代码库,还提供更强大的 GPU 集群,确保在高并发场景下也能稳定响应;

安全可控:保证代码加密传输,云端不存储,数据“用后即抛”;同时支持成员使用数据看板、费用管控等企业级管理工具;

灵活模型管理:企业后台可以统一配置模型,支持内置模型与自定义模型,大家都能一键使用。

在公测期间,企业用户可以享受首月免费(限 20 个席位/企业),只需访问火山引擎-TRAE(CN)企业版的官方页面就能提交公测申请。

豆包编程模型的表现确实令人惊艳,尤其在前端开发方面的效率提升非常明显。不过,使用成本虽然低,但具体的稳定性和长期效果还需更多用户反馈来验证。

豆包编程模型的前端开发能力确实很强,能根据设计稿生成代码很方便,但在稳定性和长期使用效果上还有待观察。

豆包编程模型在前端开发的表现让人期待,尤其是根据设计稿生成代码的功能非常实用。不过,建议团队在推广时多提供一些实际案例,以增强用户的信心。

豆包编程模型的价格确实诱人,但在实际使用中,是否能保持稳定性能还需要更多用户反馈来验证。希望后续有更多案例分享。

豆包编程模型在前端开发中的表现非常引人注目,特别是视觉理解能力的应用。不过,建议加强对用户体验的持续跟踪,以便及时调整和优化。

豆包编程模型在视觉理解能力上表现突出,能提高开发效率,但希望在实际应用中能有更多实证案例来验证其稳定性。

豆包编程模型的视觉理解能力很有前景,可以显著提高开发效率,但希望能提供更多实际案例,以验证其在复杂项目中的表现。

豆包编程模型的价格确实有吸引力,但在实际使用中的稳定性和性能表现还需要更多用户案例来支持,期待后续有更多反馈。

豆包编程模型在前端开发中的表现很有潜力,尤其是视觉理解能力的应用,但希望能有更多的案例来验证其在复杂项目中的实际效果。

豆包编程模型在性能和价格上确实有优势,但我对其在复杂项目中的适应性还有些疑虑,希望能看到更多用户反馈和案例。

豆包编程模型在前端开发中的表现很吸引人,特别是视觉理解能力,能显著提高开发效率。不过,建议尽快发布更多用户案例,以增强信心。

豆包编程模型在前端开发中的表现确实很强,尤其是视觉理解能力令人期待。不过,对于复杂项目的适应性,我还是有些担心,希望能有更多实证案例来验证。

豆包编程模型在前端开发中的表现确实很突出,尤其是视觉理解能力,可以大幅提高开发效率。不过,能否满足复杂项目的需求还有待观察,希望能看到更多真实案例。

豆包编程模型的视觉理解能力确实很吸引人,能够提高前端开发效率,但我对它在多模块复杂项目中的适应性还有些疑虑,希望看到更多案例支持。