瞬间生成万字:Kimi K2 高速版引领“极速AI”时代

瞬间生成万字:Kimi K2 高速版引领“极速AI”时代

最近,月之暗面推出了 Kimi K2 Turbo Preview,这款模型的输出速度从每秒 10 个 Tokens 提升到了 60 个 Tokens,峰值甚至可以达到每秒 100 个 Tokens。这意味着,开发者再也不用担心高延迟的问题,交互变得更加流畅。虽然有五折的限时促销让人心动,但真正吸引人的还是技术上的突破:MoE 架构大大释放了并行推理的能力,能更快地理解和响应复杂的请求,堪称效率的革命。

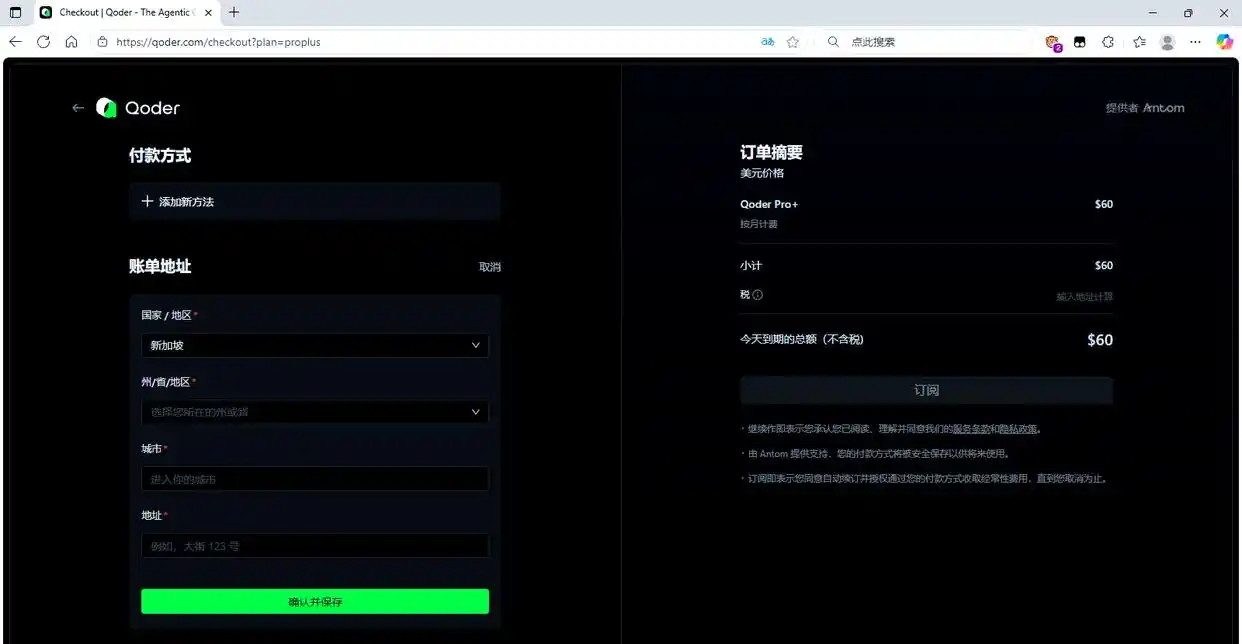

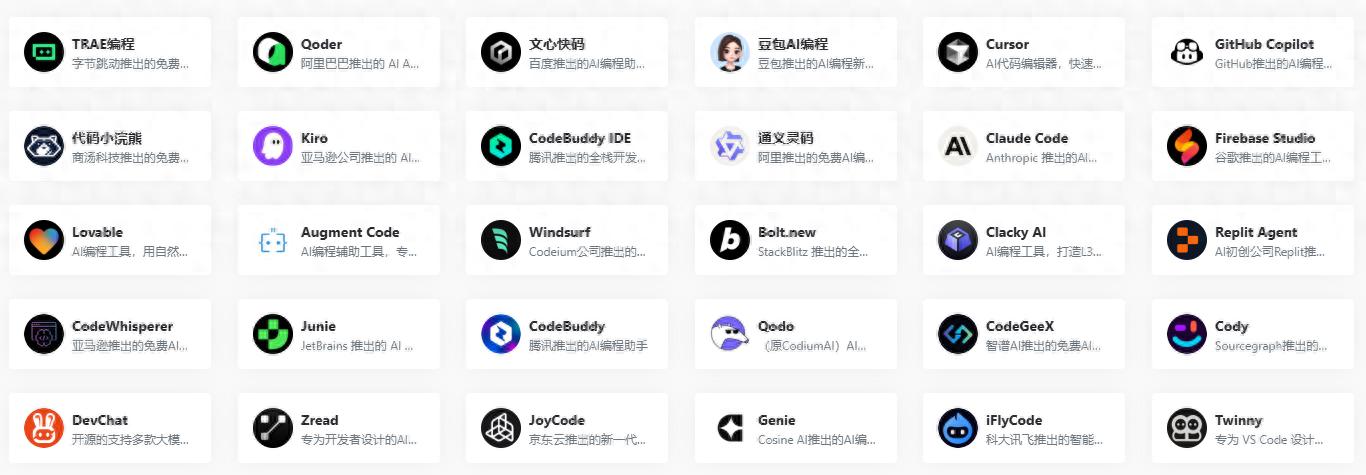

“一句话搞定开发”:阿里 Qoder 统筹项目全局

阿里新推出的 Qoder 平台,可以一次性检索到完整的代码库(最多可达 10 万个文件),自动生成项目维基,理清依赖关系,甚至能自主规划和完成复杂的开发任务。想象一下,这就好比把 QA、架构师、环境搭建和测试全部交给智能体处理——真正实现了 AI 代替开发的愿景。Qoder 的推出意味着 AI 不再只是辅助工具,而是成为软件工程师的新角色。

腾讯 CodeBuddy 一体化 IDE:一句话解决从原型到部署

腾讯云的 CodeBuddy IDE 国内版已经开始公测,不需要邀请码,整合了 DeepSeek‑V3.1‑Think 等多个最新模型,并内置了一系列设计和部署工具,打通了产品原型、编码到上线的全流程。这款 DeepSeek‑V3.1‑Think 模型不仅推理速度快、理解能力强,还能灵活切换思考和非思考模式,非常适合处理长文本和复杂工具调用,开发效率大幅提升。AI 正在逐步取代那些重复的体力劳动。

实验分析:MoBE 架构使大型 MoE 模型轻松自如

最新的研究论文 MoBE 提出了一种 Mixture‑of‑Basis‑Experts 的压缩方法,在几乎不影响模型精度的情况下,能够将 DeepSeek‑V3‑0324 和 Kimi‑K2‑Instruct 等模型的参数量减少约 24%–30%。这项技术为大模型的部署开辟了新局面,让边缘设备、移动端和低成本服务器都有可能运行以往只能在云端完成的 MoE 模型,实现真正的普惠 AI。

Agentic AI 新模式:Kimi K2 不仅开源,还有“行动能力”

月之暗面发布了 Kimi K2 模型的源码,它是全球首个完全开源的以 Agent 为导向的 MoE 模型。其 MoE 架构结合 MuonClip 优化器,以及多阶段的强化学习训练,使得在 LiveCodeBench、数学和推理任务中表现出色,能够主动分析、拆解任务并调用工具,堪称“数字员工”。开源的特性让整个社区都能共享这种 Agentic AI 的能力,可能会催生出许多创新应用,比如智能化运维助手和自动测试机器人等。

趋势洞察:AI IDE 向外拓展,MoE 模型飞快且轻便

这六则更新背后,大家达成了一个共识:AI 工具正在从“辅助”变为“主动执行”,从“云端慢推理”转向“边缘高速解答”。

- 效率优先:Kimi K2 速度的突破,已经接近实时交互的标准;而 DeepSeek-V3.1 则展现了推理质量与速度双赢的新标杆。

- 工具智能化:Qoder 和 CodeBuddy 正在探索从自然语言到完整开发交付的一体化路径,缩短开发周期。

- 普惠部署:MoBE 压缩技术降低了轻量化部署的门槛,而开源的 Agentic 模型则显著降低了研究与创业的门槛。

未来,AI 工具将不仅仅是助手,而是开发流程中不可或缺的“智能伙伴”——它们将自己构建项目、撰写代码、调试甚至上线。从现在来看,开发者的角色可能会更加集中在“设定目标、监督和验证”上,而不是繁杂的编码工作。

这样的前景让人兴奋,也提醒我们要继续关注模型结构创新、高效推理路径与人机协作体验的深入结合。