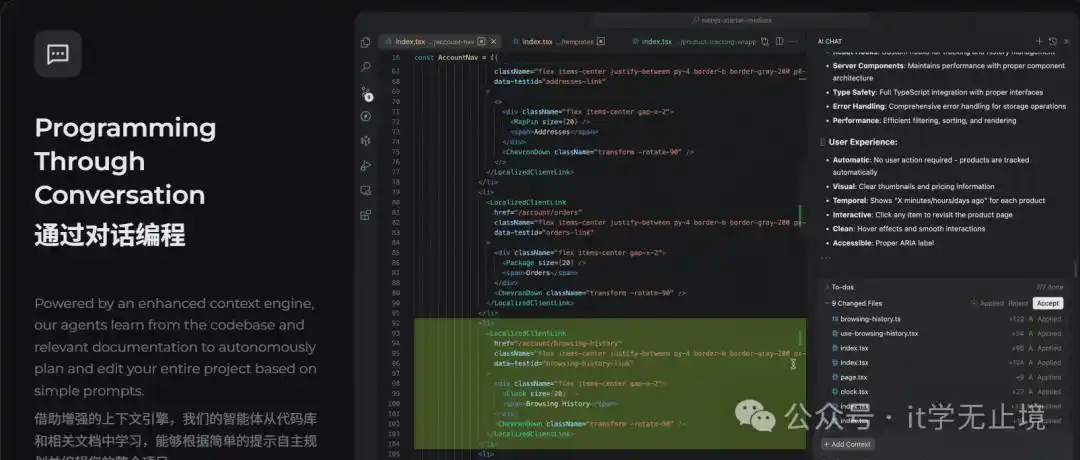

现在,Qoder 推出了全新的「上下文压缩」功能,可以更高效地管理会话内容,节省开发成本,同时还能保持良好的协作体验!

上下文窗口到底是什么?

上下文窗口(Context Window)就像是 AI 的“短期记忆”,它决定了在一次对话中,模型能够“记住”多少信息。就像我们人类的记忆一样,AI 的上下文窗口也是有限的。目前,Qoder 支持的上下文长度为 200K。

为什么要管理上下文呢?

随着对话的深入,这段“短期记忆”会越来越长。每次请求模型时,它都需要处理这些信息,才能准确理解你想表达的意思。这样一来,就会出现以下几种情况:

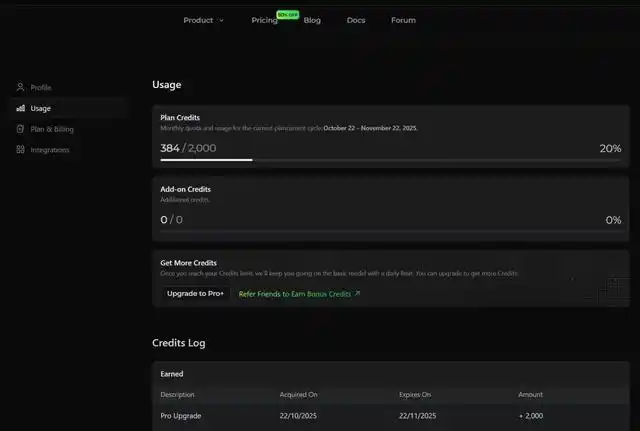

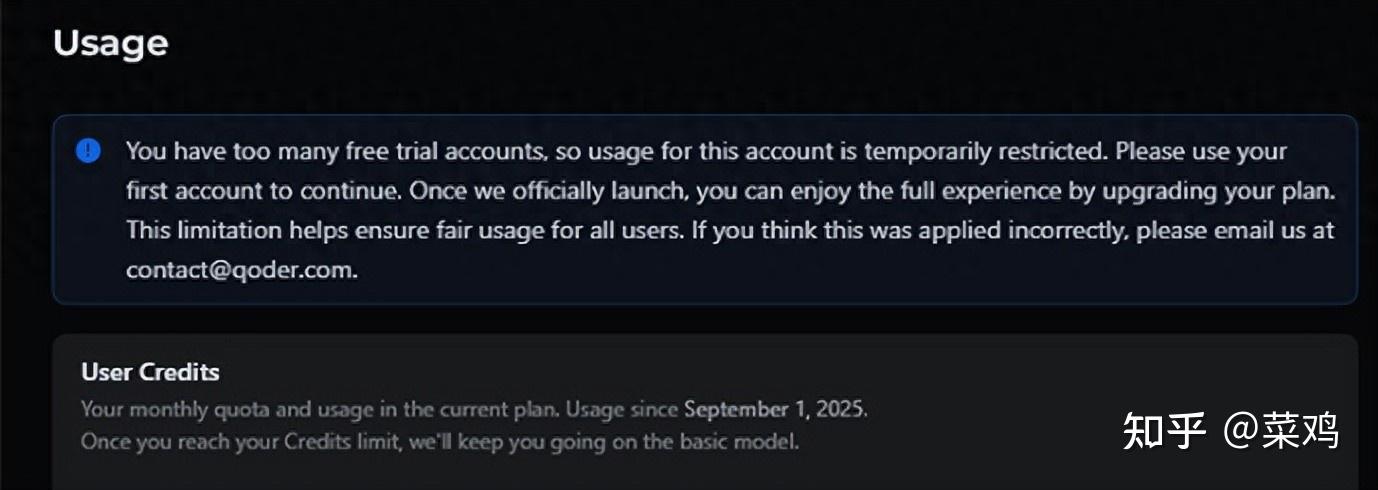

- 消耗的 Credits 增多:每次请求需要处理的 Token 数量增加,自然消耗的 Credits 也就变多了。

- 想象一下:在同一个对话中,如果聊了几十轮后,你可能只想让 AI 修改一个变量名,但实际上你发给模型的却是整段历史对话(包含了很多已经解决的问题和无关的代码)。

- 通过有效的上下文管理,能够总结会话内容,从而减少发送给模型的 Token 数量,这样就能直接降低成本,让 Credits 的消耗速度变得更慢。

- 响应速度变慢:除了成本问题,上下文过多也会拖慢 AI 的反应速度。

- 就像在处理一个大文件时,即使你只是想查找一个词,也需要更多的时间来加载和分析。通过主动管理上下文,相当于给 AI 减轻了负担,这样它的响应速度就能提高,让你的协作体验变得更加流畅。

让AI更聪明:新功能上线啦!

- 潜在干扰:当上下文中夹杂着很多无关的旧信息时,AI可能会被误导,搞错判断。

- 比如说,你在调试一个旧模块,突然又要开发新功能,这时候AI可能会把不同阶段的想法混淆,甚至被旧代码的逻辑牵着走,最终给出不靠谱的建议。

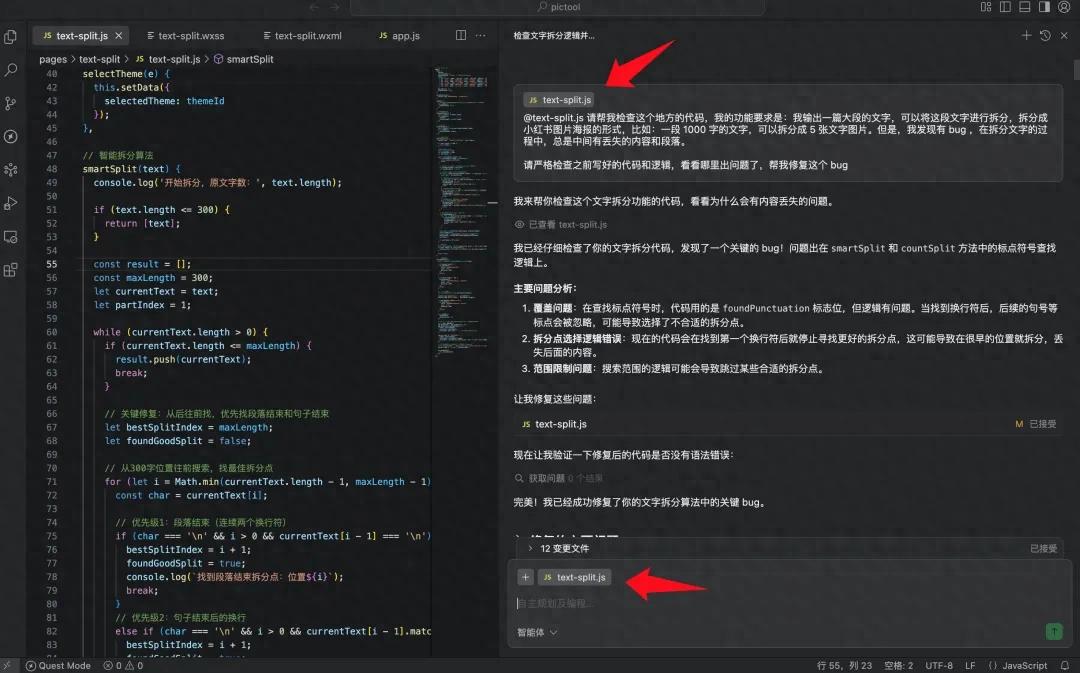

Qoder 新能力上线

上下文压缩

为了让AI更高效地为你服务,Qoder推出了新功能,可以实时查看当前会话的上下文使用情况,并在不同场景中引导你采取合适的操作。

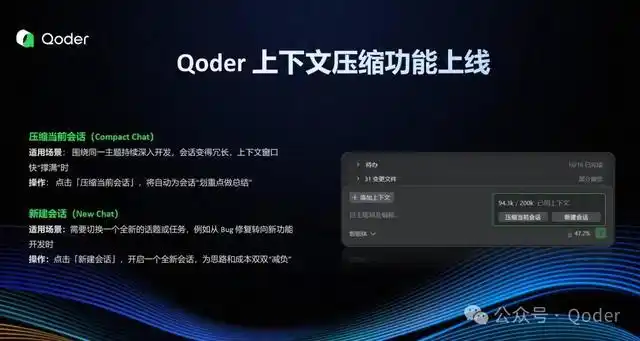

压缩当前会话(Compact Chat)

◾ 适用场景:当你围绕同一个主题进行深入讨论时,会话变得冗长,上下文窗口快要“撑满”了。

◾ 操作:只需点击“压缩当前会话”,系统就会自动为会话提炼重点,做出总结:

- 智能总结:保留关键的代码逻辑等重要信息,去掉冗余内容,同时保持核心脉络。

- 效果立现:有效降低Credits消耗,同时提升AI的响应速度。

开启新对话,轻松换话题

适用场景:当你需要从一个任务切换到另一个全新话题,比如从修复 Bug 转到开发新功能时,这个功能就派上用场了。

操作:只需点击一下“新建会话”,就能轻松开启一个全新的讨论,帮助你减轻思路和成本上的负担。

- 更准:这样可以避免历史上下文的干扰,让 AI 的回答更加精准。

- 更省:通过减少无关上下文,节省你的 Credits。

实战指南:上下文管理小能手

理论结合实践才能发挥最佳效果。记住这些小技巧,轻松掌握上下文管理。

法则一:注意上下文的使用,合理管理

在 Qoder 的对话框右下角,你可以看到当前会话的上下文使用情况(例如:115.3k / 200k)。建议当使用量超过总量的 40% 时,考虑进行上下文的压缩。

特别是当你发现 AI 的回答有点跑题或者反应变慢时,可能是因为上下文超载了。这时,如果你还想深入当前的话题,进行一次压缩不仅能帮你节省 Credits,还能提升响应速度。

法则二:新话题,开新聊

当你准备一个全新的项目时,记得要创建一个新的会话哦!这样可以避免之前的聊天记录干扰,让 AI 更准确地理解你的需求,同时还可以减少上下文的使用,节省使用费用,让新对话变得更高效又划算。

快来体验 Qoder 0.2.1 版本的全新功能吧!

官方网站:

下载链接:https://qoder.com