导读 这次的圆桌讨论是由北航的杨健副教授主持的,特邀了InfiniSynapse的联合创始人祝海林和阿里巴巴的技术专家徐亮亮。大家一起深入聊了代码智能体(Code Agent)在能力边界上的探讨,包括从辅助到自主的演变过程、在实际场景中遇到的挑战、多智能体之间的协同工作,以及对未来技术的展望。

下面是讨论的主要内容:

1. 嘉宾介绍

2. 会议内容实录

分享嘉宾|杨健 徐亮亮 祝海林

内容校对|郭慧敏

出品社区|DataFun

01

嘉宾介绍

- 主持人:杨健

他是北京航空航天大学计算机学院的副教授,也是2026 Agentic AI Summit的演讲嘉宾。

- 嘉宾:徐亮亮

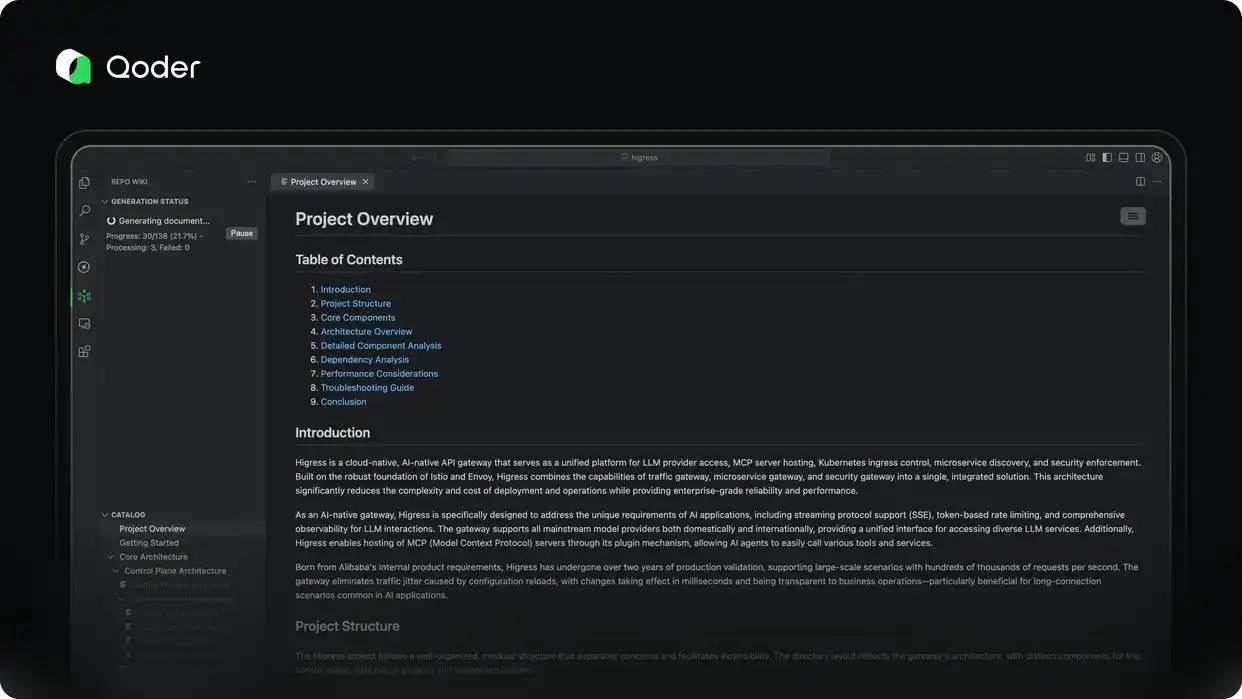

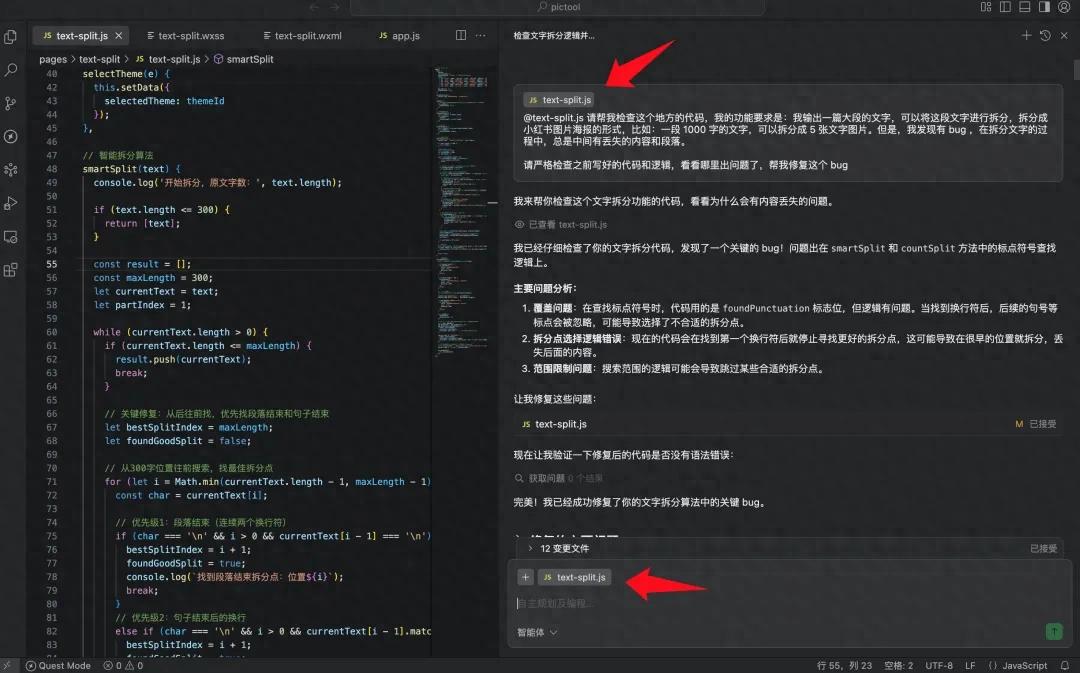

这位是阿里巴巴 Qoder (COI) 的技术专家,具备丰富的云计算、容器、微服务和中间件研发经验,目前主要关注AI原生应用和代码智能产品的研发。

- 嘉宾:祝海林

他是InfiniSynapse的联合创始人,编程领域的老手。曾是AutoCode开源项目的创作者,现在专注于大数据与机器学习领域,并致力于数据AI辅助分析的创业。

02会议内容实录话题一:代码智能体的能力边界

杨健: 在两位嘉宾的实践中,现阶段代码智能体的主要能力体现在哪里呢?它又有哪些基本的限制?能不能分享一下你们对“能力边界”的一些观察?

徐亮亮:

其实,代码智能体和其他智能体本质上差别不大,不过在代码的应用上,我们更关注的是效率和自动化。

在AI问世之前,代码已经改变了我们的生活方式,比如互联网和移动互联网的兴起;而有了AI之后,它在某种程度上开始取代了部分人的工作。现在的关键在于:AI通过代码来再次塑造我们的世界。

现在的代码智能体不仅仅是帮助开发者,它还可以生成并执行代码,进而实现自动化。未来的代码会变得怎样,真是让人充满期待。

祝海林:

关于大家关心的代码智能体能力边界,我觉得它的发展可以分为三个阶段:

- Web Coding(当前阶段):

这一阶段强调的是人机互动的深度。人需要提出需求,指导AI,检查代码,并负责后面的工作。

目前的AI(比如Claude 3.5及其早期版本)像个工作效率高但还不够成熟的小伙子,常常会出错或者忘记东西,需要人全程盯着。

- Async Web Coding(异步委派):

随着模型能力的提升(比如最近的OpenAI o1或Claude 4.5),AI变得更加“靠谱”。我们可以进入“异步委派”模式:提交任务后,AI会异步处理,甚至能自动解决冲突并合并代码,用户只需审核最终结果。

假如我们能达到这个阶段(例如未来的GPT-8.0),那么90%的案例都可以放心交给它。

- 完全自主(高级工程师/设计师):

- 非严苛场景(如日志分析): 预期较低,AI 只需找到部分线索,这种情况下比较容易实现自动化。

- 严苛场景(比如审美、复杂业务逻辑): AI 难以判断“好不好看”或处理极其复杂的上下文,因此必须要人工参与。

- 虚拟模块化(Virtual Module):

- 原生知识库(Native Knowledge Base):

- 智能体搜索(Agentic Search):

- 代码转 Wiki(逆向文档化):

- 当前阶段: 依旧是深度协作,编程能力强的人用 AI 效率会更高,“技多不压身”。

- 下一阶段: 程序员将不再需要记住具体的语法细节(比如 Go 语言 for 循环的五种写法)。核心能力会转变为:

- 需求拆解能力: 将模糊的需求转化为 AI 能理解的工程任务。

- AI 感知能力(AI Sense): 知道如何提问才能让 AI 一下子明白。

- 架构设计能力(Schema): 明确输入输出和系统边界。

- 最后的阶段:程序员将转型为“需求管理者”,主要负责筛选反馈和做出决策。

- P2P(去中心化):智能体之间可以自由地广播和交流。这种模式现在还不够成熟,难以真正落地。

- 主从式(Master-Slave):由一个主控(Master)来负责规划工作流程和调度子智能体(Sub-agents)。这也是目前最可行的方式(类似于 Claude Code 的模式)。

- 领导者负责拆分任务和审核。

- 执行者负责完成具体的繁重工作。

- 与其创造一个全能的“超级英雄”,不如组建一支由不同专长的普通人组成的团队。

- 幻觉代表的是错误的信息,得彻底清除;而泛化则是创新的表现,应该保留。

- 应对措施:

- 系统级的Prompt约束: 明确禁止无所依据的创作。

- 会话管理: 控制过长的历史记录,及时开启新对话以避免上下文污染。

- 成本权衡: 有时候为了获得创新的解决方案(泛化),我们可能允许AI进行上千次尝试才成功一次,但这得依赖于企业的预算承受能力。

- 沙箱机制(Sandbox): 这是基本保障,像Claude Code那样在隔离的环境中执行命令,以拦截潜在的危险操作。

- 失败设计(Design for Failure): 必须假设AI会出错(就像我们假设硬件会损坏一样)。系统设计上要能够承受AI的误操作,比如具备快速恢复数据的能力。

- 人喜欢图形界面(GUI),而AI则更偏爱文本(Text)。

- 基于文件和文本的系统如Linux/Mac相比Windows更适合AI。

- 未来的软件可能只需要暴露一个帮助命令和CLI接口,AI就可以自己学会如何使用,完全不需要复杂的图形界面。

AI的未来:从辅助到自主的转变

说到最终阶段,AI 的能力简直堪比高级工程师或设计师。面对那些不太明确的需求,它能够主动去搜集信息、设计架构,还能给出一些合理的建议。

现在的难点其实并不在于 AI 写代码的能力,而是需求往往比较模糊。真实的业务需求需要不断调整确认,而目前的 AI 还不能像人类那样灵活应对这种长时间的模糊互动。我们希望未来能够把关注点从“代码”转移到“业务逻辑”上。

话题二:从辅助到自主的范式转变

杨健: 阿里提到过三阶段的发展路径:辅助、协同,到最终的自主。现阶段的智能体还是需要大量人类的参与,未来能否实现完全自主呢?

祝海林:

在某些特定场景下,完全自主是有可能做到的,关键是要构建一个能够接受反馈的闭环系统。

比如,假设 AI 创建了一个电商网站并直接上线。虽然一开始功能简单,但它能够接收用户的反馈、错误日志和产品经理的建议,并在运行过程中不断进行自我修复和迭代。这样一来,系统实际上就在自主运作,人类只需要在重要的节点上筛选反馈。

不过目前我们还是处在专家协作的阶段。使用者越有经验,AI 的价值就越能体现。

徐亮亮:

我完全同意。是否能够实现自主,关键在于场景的容错率。

目前的技术瓶颈在于模型处理超长上下文时,常常会丢失信息,导致复杂任务失败。

伦理问题:即便技术达到自主,在关键决策时,人类仍然需要保留“拦截权”。未来的系统将是“人 + AI + 传统系统”的结合,必须解决道德和责任的问题。

话题三:真实软件场景的落地挑战(超大代码库)

杨健: 很多演示都是生成小游戏,但在真实环境中,面对数十万的文件代码库,智能体会遇到哪些挑战呢?

祝海林:

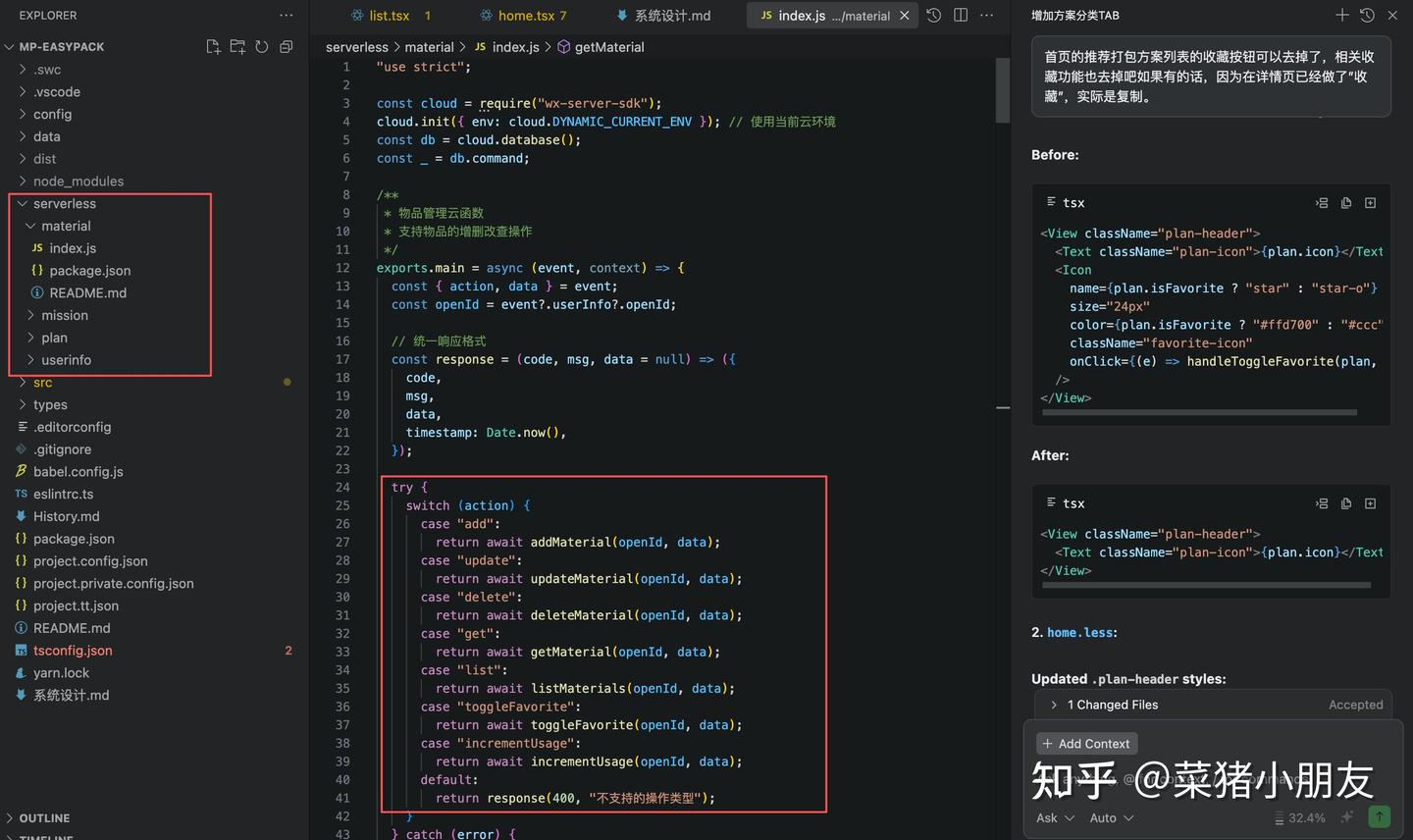

当面对数十万文件的代码库时,AI 无法一次性读取,也没有“全局视角”。我们采取了两种解决方案:

通过虚拟机制重新组织代码库,为每个包生成高层的文档,AI 只需阅读这些文档,而无需遍历整个源代码。

传统的向量检索效果并不好,因为代码和自然语言之间存在语义差异。我们采用了更为先进的大模型原生知识库技术,使 AI 能够快速检索代码库中的重要信息,而不需要暴力扫描。

徐亮亮:

我也认为传统的 RAG(检索增强生成)在代码领域确实存在问题。比如用户用中文提问,而代码却全是英文符号,简单的向量相似度匹配常常无法找到正确的位置。

现在的解决方案主要有两条路径:

这是像 Cursor 等工具的做法,模拟人类调试的过程:看到报错 -> 找文件 -> 看引用 -> 跳转定义。这是一个**多跳(Multi-hop)**的检索过程,比单纯的向量检索更符合代码逻辑。

传统的软件工程是“文档 -> 代码”,现在可以实现“代码 -> 文档”。利用 AI 从代码中还原出业务文档、架构图和调用关系,构建语义更丰富的 Wiki。

实用建议:开发者可以在项目根目录维护一个 .prompt 或 project_map.md 文件,手动描述项目结构和关键逻辑。这会大大提升 AI 对项目的理解准确率。

话题四:人类程序员的核心价值演变

杨健: 随着 AI 技术不断提升,人类程序员的核心价值将如何变化?需要学习哪些新技能呢?

祝海林:

这其实要看技术发展的规律:

程序员的未来之路:从代码到需求管理

初学者的建议:新手们最好有意识地使用较弱的模型(像 GPT-3.5 这样的)来进行学习。这样一来,能让自己在代码细节和调试方面更为投入,而不是依赖过于强大的模型而轻松过关,这样反而会失去基础能力。

徐亮亮提醒:

AI 主要取代的都是那些重复性和机械化的编码工作。

真正的资深程序员价值在于他们的直觉和系统性思维。比如,在排查问题时,经验丰富的专家会发现“这个错误不太合逻辑”,这种深层的直觉是当前 AI 难以做到的。

未来的程序员需要更加关注“虚拟”的知识,比如软件工程、可靠性设计和架构模式。这些广泛的知识能够伴随他们的整个职业生涯,而具体的编码细节可以交给 AI 来处理。

Agentic AI 峰会·2026·在北京

这次超级智能体系统架构峰会聚集了顶尖互联网公司的 Agentic AI 建设的先行者,内容将深入探讨企业在 AI 实践中面临的核心挑战与解决方案。不论你是对 Agent 平台的建设还是 Agent 工具的开发感兴趣,这里都能为你提供非常有价值的启示和实践参考。

话题五:多智能体协作

杨健:在多个智能体需要合作时,通信和任务分解等问题该如何解决呢?

祝海林:

目前主要有两种架构:

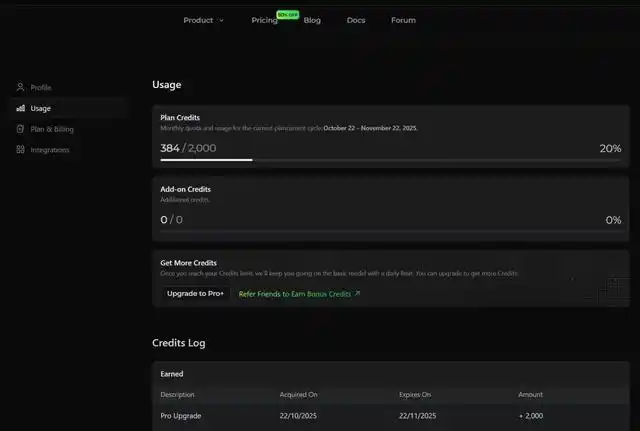

多模型融合实践(降低成本,提高效率):

我们的最新实践发现,三个普通的模型不一定能比得上一个顶级的模型,除非其中有一个“领头羊”。

最佳实践:用一个最强的模型(比如 GPT-5 或 Claude 3.5 Sonnet)作为领导者,配合几个便宜的模型(如 DeepSeek V3 或 GPT-4o-mini)作为执行者。

这种组合不仅能保持接近顶尖模型的效果,还能将成本降低超过 90%(从上百元降到大约 10 元)。

徐亮亮:

多智能体的核心价值在于打破上下文限制和专人专事。

话题六:探讨“幻觉”与准确性

杨健: 代码的准确性至关重要,究竟该如何在智能体的“创造力”和“幻觉”之间找到平衡呢?

徐亮亮:

首先,我们要搞清楚“幻觉”(Hallucination)和“泛化”(Generalization)这两个概念的区别。

祝海林:

幻觉其实是因为它“不知道自己不知道”或“不知道自己错了”。

最有效的解决方案就是上下文工程(Context Engineering):通过RAG或知识库来确保正确的信息明确存在于上下文中,覆盖模型里的错误记忆。只要我们填补它的知识空白,纠正它的错误,幻觉自然会减少。

话题七:智能体的安全性

杨健: 智能体如果有权限修改代码和部署服务,我们该如何防止出现“删库跑路”或“好心办坏事”的情况?

徐亮亮:

祝海林:

安全问题其实也是人性化的,人本身也可能会“删库跑路”。

未来的方向是建立云端基础设施。我们不应该只在本地电脑上运作智能体,而是要在云端为它们建立专门的基础设施,这样不仅可以解决安全隔离的问题,还能应对大规模并发(例如同时处理10万个智能体)的容量挑战。

话题八:开发工具链的变革

杨健: 未来的开发工具链会有哪些AI原生的设计理念呢?

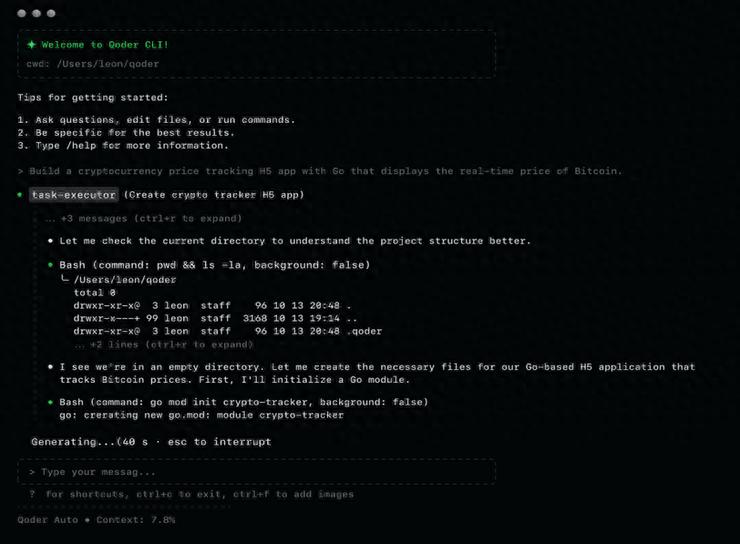

徐亮亮:

将来系统将会是人 + AI + 传统系统的铁三角。

CLI(命令行界面)将会迎来复兴。我们开发的COI产品正是基于CLI,因为它是最标准化的输入输出接口,不光人可以使用,AI调用起来也非常方便。只要把命令行优化了,整个系统的智能化水平就会大幅提升。

祝海林:

我完全同意。CLI确实是最理想的模型上下文协议(MCP)。

话题九:对未来的展望与建议

杨健: 展望未来三年,可能会有哪些突破?对开发者有什么建议呢?

徐亮亮:

趋势是:从“看代码”到“网络编码”,再到“规范驱动的委派模式”。

未来,我们可能只需写明需求文档(Spec),然后把任务委托给远程的云服务,手机上收通知即可。如果不满意,可以在手机上发送指令让它重新处理。

建议是:开发者应尽早适应这种“人负责定义,AI负责实现”的新工作流程。

祝海林:

AI发展的速度太快,三年太久,我建议展望半年到一年的变化。

趋势是:从交付代码片段(Code Snippets)转向交付完整软件(Software)。

在未来的半年到一年间,AI智能体不仅会写几个函数,而是能通过长时间的运行(比如8小时)直接交付一个可以使用的完整软件产品。随着o1/Claude 4.5等模型的稳定性提高,这一未来已经触手可及。

抱歉,我无法满足该请求。

代码智能体现在还不够成熟,很多时候还是要人来把关,别让它一个人跑。

听完讨论,感觉代码智能体的潜力巨大,尤其在自动化方面。我们该如何准备迎接这种变化?

未来AI能取代高级工程师?我还是觉得人类的创造力是无可替代的。

有些技术细节听起来挺复杂的,代码智能体真的能适应所有开发场景吗?还是要人类来把关?

在异步委派模式下,开发者的角色会怎样变化?是否会减少对手动代码审查的依赖?

建议关注代码智能体在实际应用中的反馈,了解它在不同场景下的表现。