编辑|郑玄

自从2025年,各种关于AI编码的宣传就像火箭一样迅速升空,甚至有点像科幻小说中的场景。

在消费者市场上,单句生成的演示内容依旧在吸引眼球,技术的进步被包装成了一种未来感的叙事;但你有没有想过,普通人为什么要学习编码呢?这些演示能在实际环境中运作吗?

更深入地说,其实超过95%的AI编码用户都是在开发真实软件的专业人士。他们的工作并不是那些天马行空的创意示例,而是有至少80%的价值来自于对旧有项目的迭代与改进。

这样的项目不仅产值高,时间积累也长,而且复杂度也不低,而传统的AI编码工具似乎在这方面并不擅长。根据Stack Overflow在2025年的开发者调查显示,大家对人工智能的信任度降到了史上最低。尽管有84%的开发者表示在开发过程中使用或打算使用AI工具,比2024年的76%有所增加,但有46%的人对AI输出的准确性表示怀疑,这个比例比去年的31%上升了不少。更有45%的受访者表示,因为调试AI生成的代码而感到压力山大(

原因其实很简单,生产级项目对AI的要求可不仅仅是生成代码片段,而是要理解整个项目的全貌,遵循隐性规则,完成全链路的生产能力。

因此,AI编码软件的要求聚焦在上下文工程和智能体能力这两个具体维度上。

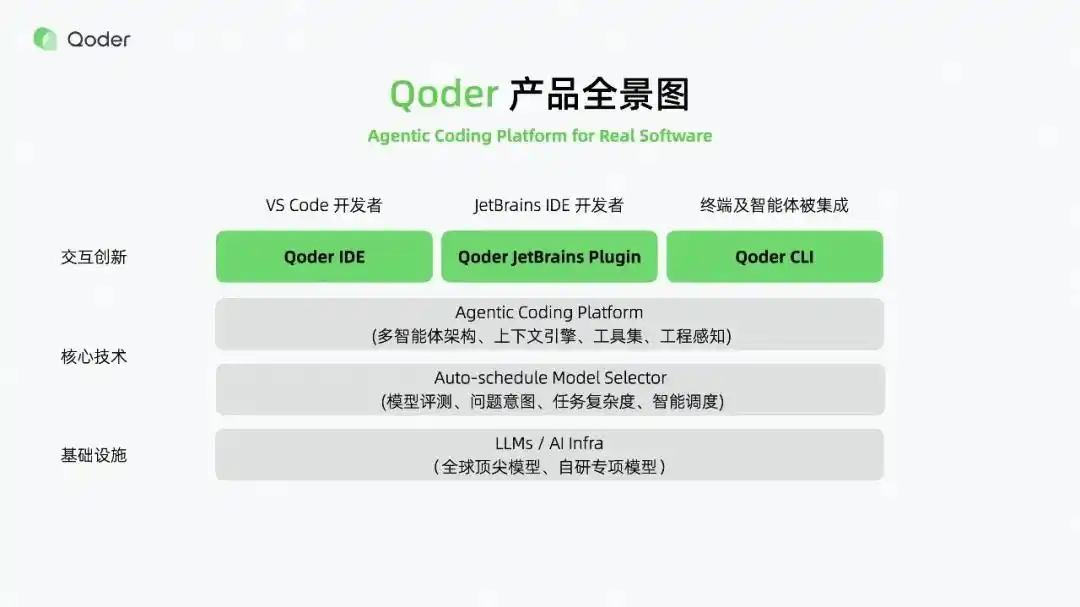

不久前,飞天发布会上推出的Qoder,全面支持JetBrains插件、IDE和CLI这三种主流产品形态,正是这个行业转型的一个标志性成果。

可以说,Qoder作为国内首个定位为「智能体编程平台」的AI开发工具,标志着AI编程从简单的「代码助手」向「能自主完成复杂任务的全栈AI工程师」的重大飞跃。

01

生产级代码需要怎样的上下文能力

AI编程在生产环境中的最大障碍就是上下文能力,在团队合作的复杂项目中,这个问题会被无限放大。

现有的工具通常使用20万token的上下文窗口,这不仅无法涵盖跨模块的依赖关系(会导致一些低级错误,比如变量未定义),而且也无法捕捉团队积累的隐性知识,比如金融行业对支付超时重试的要求、电子商务系统需要包含的流水号等,这些都是避免线上事故的关键因素。

要解决这个问题,上下文工程需要突破三个主要瓶颈:覆盖的广度、检索的精度和意图匹配的准确性。

其中,上下文长度是第一个核心难点。为此,Qoder推出了10万文件级的上下文检索。

这意味着什么呢?按照行业标准来看,个人项目大约需要50-500个文件,中型企业的应用则需要大约1000-5000个文件,即使是像Linux内核这样的大型开源项目,文件数量也只有5万左右。10万文件的覆盖能力意味着Qoder能适应数百人团队维护的超复杂系统,从文件级别的理解提升到项目级别或工程级别。

但仅仅扩大上下文长度,一方面模型的上下文窗口并不支持,另一方面可能引发计算能力的激增和精度的下降。因此,使用RAG形式进行精确检索已成为行业的常见做法。在这个过程中,提高检索精度显得尤为重要。

当前行业内主要有两大技术路径:以Claude Code为代表的grep派,依赖关键词匹配,适合小型代码库但语义召回率低;以早期Cursor为代表的智能检索派,借助语义理解进行上下文检索,但技术应用仍然较为初步。

Qoder则采用了融合式检索引擎,建立了云端代码搜索引擎,能够关联代码结构、历史迭代记录与Repo Wiki文档,实现跨模块和跨项目的语义级精准定位——既避免了grep的机械匹配缺陷,又弥补了纯智能检索的细节缺失,确保AI只获取与当前任务高度相关的信息。

这种跨模块和跨项目的检索能力,使得Qoder能够超越单文件的限制,全面理解和索引整个代码库的结构与历史,从而确保对复杂、多轮迭代项目的适应能力。

在精准检索的基础上,若想进一步提升大模型的输出质量,就必须在意图匹配上做文章。Qoder通过动态记忆和一键增强两种机制来解决这个问题:

动态记忆模块能够自动挖掘历史对话中的编码风格(比如命名规范、注释习惯)和工程约定,例如识别开发者常用的「ResultDTO」来封装返回值,后续生成的代码将自动遵循这一规范。

提示词增强功能则能将模糊需求进行结构化,从而减轻开发者优化提示词的负担。例如,输入「优化登录接口」,系统会自动补全为「基于Spring Security架构,增加手机号验证码、密码错误锁定、token有效期调整、关联数据表及单元测试」的完整任务描述,从源头上减少理解偏差。

为了适应团队协作的场景,Qoder还支持Repo Wiki的导出与共享——通过核心成员梳理项目架构和隐性规则生成文档,整个团队都可以通过代码库共享,使AI的上下文认知与团队经验同步,彻底解决了「新人AI不懂老项目规则」的行业痛点。

02

什么是智能体AI编码

上下文解决了学习的问题,接下来就是用智能体来解决执行的问题。

过去,许多AI编码工具的定义依旧停留在集成大模型,做代码生成或补全助手的阶段,往往只能完成简单的单一功能生成,而且生成的内容与原有代码结构不匹配,通常还需要大量的人工调整,更别提需求、设计、开发、测试的全链条闭环了。

以用户注册功能为例,基础的Copilot仅能生成简单的表单代码,却无法关联数据库表结构、调用短信验证接口,甚至无法自动编写单元测试,而这些附加工作占到了实际开发工作量的70%以上。

正因如此,到了2025年,AI编程从代码补全向任务执行升级逐渐成为了一个共识,而智能体能力也成为了核心竞争力的来源。

其显著代表就是不久前更新的Cursor,其2.0版本的用户界面不再以文件为中心,而是围绕智能体进行重新设计,支持最多同时运行8个智能体。但这依然没有解决智能体执行过程的黑箱问题:开发者无法追踪任务拆解过程,出错后难以定位问题。

针对智能体编码落地的困境,Qoder的突破在于创新性地引入了Quest模式和Spec驱动的核心理念,实现智能体能力的可控与可追溯。

Quest模式的核心在于通过任务委派和多任务并行执行,使得多个智能体可以独立处理子任务(例如接口开发与测试编写可以同步进行),并且能够自动处理依赖关系(比如子任务1未完成时,子任务2无法启动)。这进一步拓展了人和AI开发的时间和空间。

在此基础上,Qoder通过待办事项列表,进一步将任务结构化,确保智能体执行任务的准确性。

举个例子,将生成订单接口的任务拆分为查询商品库存→创建订单记录→扣减库存→生成物流单四个步骤,每一步都显示状态、依赖资源和耗时:如果扣减库存失败,系统会标注可能的出错原因和解决方案,开发者还可以直接在待办事项列表中修改参数,系统会实时调整执行逻辑。

01

Spec 驱动开发可以说是从根本上解决了开发者和 AI 之间理解需求的障碍。作为开发者最熟悉的协作工具,需求规范(Specification)被 Qoder 确立为任务执行的基础。简单来说,开发者一旦明确了需求,AI 就会根据这个规范制定开发计划,自己完成代码编写、测试脚本生成和结果验证等一系列流程,最后输出包括代码文件、测试报告和待确认问题的执行报告。这种方式让开发者的重点从盯着屏幕实时修改代码,转向需求定义和结果审核,甚至还支持在离线状态下提交任务,静待反馈,彻底改变了人与 AI 的协作方式。

02

破解 AI 编程的难题

说到 AI 编程工具,大家可能都知道它们面临着能力、场景和成本之间的难以平衡。

那些功能强大的工具,往往价格也不菲;而那些成本控制得不错的工具,通常在场景适用性或技术能力上有些欠缺。

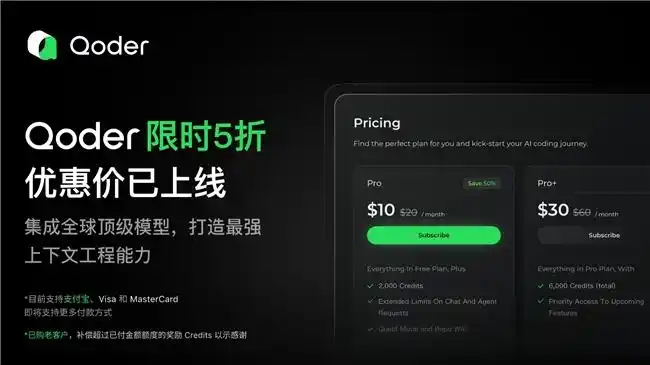

比如说,看看国外的两款 AI 编程工具:Claude Code 的 Max 版本要200美元每月,而 Cursor Pro 是20美元每月,这对很多想尝试的用户来说,确实是一笔不小的开销。而且,大多数 AI 编程工具在会员制的基础上,还会额外按 token 收费,这样一来,复杂任务就容易把额度耗尽。

与此同时,现有工具普遍存在场景局限性。比如,Cursor 主要集中在 IDE,而 Claude Code 则偏重文档处理,这就意味着开发者需要为多个昂贵的平台付费,还得不断切换工作流。

所以,如何选择合适的产品,并以高性价比的方式使用,成了行业内最大的痛点。

针对这些问题,Qoder 提出了两步走的解决方案:一是对齐标准,二是提供全场景高性价比的选择,来破解行业困境。

首先,在标准层面,Qoder 针对常见的 AI 编程需求,推出了涵盖多场景、多语言和多模态的 Qoder 评测集;在此基础上,还推出了自动化评测框架 Qoder Bench,能够实时对 AI 编程软件进行自动化和并行化评测,以及线上 A/B 测试,帮助用户在 能力、场景和成本的难题中,找到最合适的方案。

全场景高性价比方案,实际上可以从场景和价格两个方面来理解。

Qoder 在已有的 IDE 和 CLI 基础上,推出了 JetBrains 插件,全面覆盖三种主流编程产品形态的全链路场景:IDE 适用于百万行代码的复杂项目,整合了所有核心能力;JetBrains 插件兼容 IntelliJ IDEA、PyCharm 等主流开发工具,实现零学习成本接入;而 CLI 则专为服务器运维、快速代码审查等轻量场景设计,提供终端级的高效支持。

三端的数据和账号、Credits 实时同步,确保开发者在不同场景下的体验一致。开发者在 CLI 生成的脚本可以直接在 IDE 中编辑,这样就省去了大量的手动同步、配置和环境切换的麻烦,提供了一种无缝、一致的开发体验。

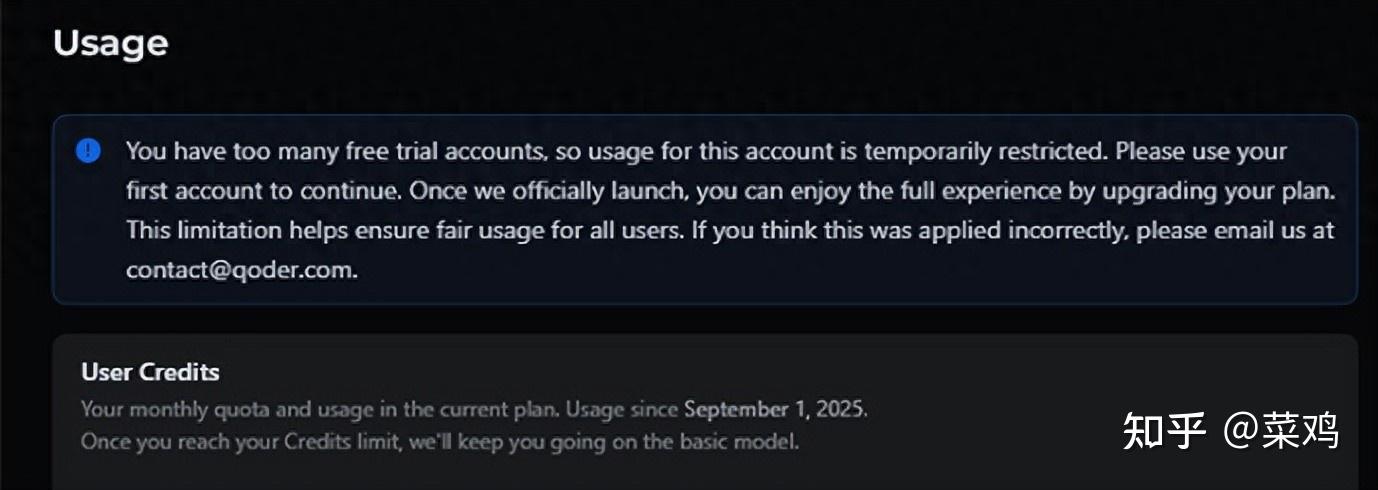

在定价方面,Qoder 还推出了首月仅需2美元的优惠。

伴随着实惠的价格,Qoder 还推出了更智能的成本控制模式。通过模型分级选择器,Qoder 能够为不同任务自动匹配最合适的模型:轻量模型适用于代码补全、注释生成等简单任务,成本仅为SOTA模型的零头,同时响应速度也有很大提升;复杂任务如架构重构、跨模块开发则使用高级模型,这样比固定使用单一模型能节省更多成本。

Qoder 的创始人丁宇(叔同)在采访中提到,Qoder 拥有大量用户和真实使用数据,能够从统计学角度分析不同场景最适合的模型。如果让用户手动来选择,首先会打断他们的思路,其次也不太现实——毕竟没人能每次提问时都换模型。一般人都是开一个新会话选好模型后一路用下去。因此,Qoder 的核心理念就是机选优于人选,利用强大的模型调度能力,自动判断并为每个问题选择最合适的模型,这样用户的体验和效果都会更好。

这也是 Qoder 与其他产品最大的不同之处:用效果来说话。

根据 Qoder Bench 的数据,在复杂任务测试中,Qoder 的综合效果评分领先行业13.22%,而在相同任务量的情况下,其耐用性比 Cursor 高出104.9%。

03

总结

展望2025年,随着 AI 的普及,大模型行业将发生深刻变化,一个明显的趋势是 SOTA 刷新频率与「aha 时刻」的密度成反比——参数竞赛的边际效益递减,行业终于回归技术落地价值的核心。

在绘画、PPT、编程等多个细分领域,做深、做性价比也越来越重要,专业用户的口碑也变得至关重要,从小的体验入手,让工程化能力和模型能力并行发展,成为新的主流。

编程是通向 AGI 的必经之路,而 Qoder 则是帮助大模型通过实际编码任务提升端到端能力的重要工具。它不仅服务开发者,更服务更广泛的场景。从战略层面来看,Qoder 是阿里 AI 体系的重要组成部分。

AI 编程的竞争焦点,已经从生成炫酷的 Demo 转向如何解决实际生产环境中的软件开发问题,这正是 Qoder 的真正价值所在。

在生产环境中,调试 AI 生成代码的压力确实会影响开发效率,建议增加相关的支持工具。

建议在使用Qoder时,配合团队的知识库,以便更好地解决上下文问题。

AI工具的信任度下降,难道是因为它们不能理解项目的全貌吗?

听说Qoder能支持10万文件的上下文检索,真的是一个突破,值得尝试!

上下文能力的提升是否意味着我们可以更高效地处理项目?希望Qoder能带来实质性的帮助。

听说Qoder的目标是成为全栈AI工程师,真有这种潜力吗?就像拥有一个虚拟的团队成员一样。

考虑到开发者对AI工具的信任度下降,Qoder应加强透明度以重建信任。

Qoder能否在实际项目中提供帮助,值得我们持续观察和尝试!