文|道总有理

在新的一年里,DeepSeek成为了全球科技界的焦点。自从它上线以来,已经在AI产业链上引发了不少波澜,无论是OpenAI还是英伟达,大家的震惊似乎都在证明DeepSeek的成功。

说到DeepSeek的表现,真的是值得一提。数据显示,在发布后的五天内,它的日活跃用户量已经超过了ChatGPT,而上线20天后,这个数字更是突破了2000万,达到ChatGPT的23%。目前,DeepSeek的增速让它成为全球最快的AI应用。

在国外的一众AI公司感到难以置信的同时,国内的AI行业却热闹非凡。现在,阿里云、百度云、腾讯云和字节火山引擎等都已经正式支持DeepSeek,同时,百度昆仑芯、天数智芯和摩尔线程也接连宣布支持DeepSeek模型。

这标志着在全球AI竞争中,国产厂商终于迈出了重要一步。DeepSeek的出现,是否意味着长期以来的大模型行业终于突破了一些固有的障碍呢?有些关键细节其实还有待深入探讨。

DeepSeek的火爆是偶然吗?

围绕DeepSeek的主要争议,似乎都指向一个问题:它是否真的在大模型技术上实现了突破。早在DeepSeek宣布其模型训练成本只有行业的十分之一时,就有很多声音质疑,认为它可能是通过大幅削减模型参数,或者依靠其母公司幻方早早积累的低成本算力来实现的。

从某种角度看,这些质疑并非空穴来风。

一方面,DeepSeek在缩减模型参数方面的做法确实引人注目;另一方面,幻方在算力储备上也确实有其优势。众所周知,幻方是BAT之外唯一能够储备超过万张A100芯片的企业,2023年的报道显示,国内能囤积超过1万枚GPU的企业不超过五家,而幻方正是其中之一。

值得注意的是,无论是参数规模的缩减,还是算力的创新争议,都无法否认DeepSeek“小力出奇迹”策略的实际意义。首先,DeepSeek-R1在仅有1.5亿参数(1.5B)的情况下,在数学基准测试中取得了79.8%的成功率,超越了GPT-4等大模型。

其次,轻量化模型在推理能力和性能方面表现更为出色,训练和运行的成本也显著降低。DeepSeek以仅需1/50的价格提供了类似于GPT-4的性能,迅速在中小企业和个人开发者中占据了一席之地。

至于幻方对DeepSeek的支持,可以说这不仅仅是资本的偶然,而是国产大模型发展的必然。值得注意的是,幻方量化是国内首批进入大模型领域的公司之一,早在2017年就宣称要实现投资策略的全面AI化。

2019年,幻方量化成立了AI公司,自研的深度学习训练平台“萤火一号”投资近2亿元,搭载了1100块GPU;两年后,“萤火二号”的投入增至10亿元,搭载约1万张英伟达A100显卡。

到了2023年11月,DeepSeek的首个开源模型DeepSeek-Coder发布。这意味着,引起国际科技巨头关注的DeepSeek并不是一蹴而就的产品,而是国产AI厂商在大模型布局中必经的一步。

不可否认的是,目前国内已经具备了孕育“DeepSeek”的条件。公开资料显示,国内人工智能相关企业已超过4500家,核心产业规模接近6000亿元人民币,正在形成一个完整的AI生态系统。

在芯片、算法、数据、平台和应用等方面,我国以大模型为代表的人工智能普及率已达到16.4%。

当然,DeepSeek在技术路径上的依赖风险始终存在,这也让它的成功多了一丝偶然的成分,尤其是“数据蒸馏技术”遭遇了不少质疑。事实上,DeepSeek并不是第一个使用数据蒸馏的大模型,“过度蒸馏”甚至是当前AI赛道的一大矛盾。

中科院、北大等多家机构曾指出,除了豆包、Claude和Gemini,大部分开源或闭源的LLM蒸馏程度过高。过度依赖蒸馏可能会导致基础研究的停滞,进而降低模型之间的多样性。上海交通大学的教授也表示,蒸馏技术无法解决数学推理中的根本性挑战。

总的来说,这些种种都在逼迫DeepSeek和整个国产大模型赛道不断进行自我验证。或许,未来还会出现第二个“DeepSeek”,从现实来看,DeepSeek的成功更多是必然而非偶然。

“开源时代”是不是要来了?

值得关注的是,DeepSeek的成功又一次在全球科技界引发了关于开源与闭源的激烈讨论。Meta的首席科学家杨立昆在社交媒体上表示,这并不是中国在追赶美国,而是开源在追赶闭源。

提到开源模型,不得不回顾2023年Meta的一次源代码泄露事件。当时,Meta顺势发布了LLama 2的开源可商用版本,瞬间在大模型领域掀起了一阵开源热潮,国内的悟道、百川智能和阿里云等纷纷投身开源大模型的浪潮。

根据Kimi chat的统计,2024年开源大模型品牌超过10个。2025年初不足两个月,除了火热的DeepSeek,参与开源的公司不胜枚举。

据说在1月15日,MiniMax开源了两个模型,一个是基础语言大模型MiniMax – Text – 01,另一个是视觉多模态大模型MiniMax – VL – 01;同时,NVIDIA也开源了自己的世界模型,分别有三个型号:NVIDIA Cosmos的Nano、Super和Ultra;1月16日,阿里云通义也开源了一个7B的数学推理过程奖励模型。

从2023到2025,经过无数AI人才的争论,大模型的“开源时代”真的要来了吧?

可以明确的是,相较于闭源模式,开源模型凭借其开放性在短时间内能够吸引大量关注。公开资料显示,LLama 2发布时,其在Hugging Face的检索结果就超过6000个,而百川智能的两款开源大模型在当年9月的下载量更是超过了500万。

其实,DeepSeek的迅速崛起与其开源模式密不可分。2月的统计显示,接入DeepSeek系列模型的企业数不胜枚举,云服务商、芯片厂商以及应用端企业都纷纷参与。当前AI需求旺盛,大模型的开源似乎更能推动AI生态的形成。

不过,大模型赛道开源与否,还需要进一步探讨。

虽然Mistral AI和xAI都是开源的支持者,但它们的旗舰模型目前却是封闭的。国内大多数厂商也是一手闭源、一手开源,像阿里云和百川智能这样的例子比比皆是,甚至李彦宏一度也是闭源模式的坚定支持者。

原因其实很简单。一方面,在全球科技领域,开源AI公司并不受资本青睐,反而是闭源AI企业在融资上更具优势。数据显示,自2020年以来,全球闭源AI初创公司融资已达到375亿美元,而开源AI仅获得149亿美元,这对资金需求巨大的AI企业来说,差距明显。

另一方面,开源AI的定义在近年来变得愈加复杂。2024年10月,全球开放源代码促进会发布了开源AI的定义1.0版本,其中指出,AI大模型若要被视为开源,需具备三个要点:训练数据透明性、完整代码和模型参数。

按照这个定义,DeepSeek可能就不算真正意义上的开源,可能只是为了迎合短期的市场需求。而在国际上,《Nature》的一篇文章也指出,很多科技巨头声称他们的AI模型是开源的,实际上并不完全透明。

最近,受到冲击的奥尔特曼首次承认OpenAI的闭源“是一个错误”,或许,跟着DeepSeek的热潮,AI界的一场“口水战”又将拉开序幕。

算力的大规模投入是否会“暂停”?

这段时间,许多沉迷于囤积算力的AI企业因DeepSeek的横空出世而受到嘲讽,像英伟达这样的算力供应商股价也大幅下跌。说实话,DeepSeek确实在某些方面带来了新的突破,缓解了一部分对“垄断诅咒”的焦虑。

但是,全球大模型赛道对算力的需求依然不容忽视,甚至DeepSeek自身也未必能暂停算力的投入。

算力大战:DeepSeek的挑战与未来

首先得说,DeepSeek现在主要能做的就是文字问答、图文识别和文档阅读,至于图片、音频和视频生成这块儿,暂时还没涉及。尽管如此,它的服务器却快撑不住了。如果未来想要扩展到其他领域,算力需求肯定会暴涨,尤其是生成视频的模型和处理语言的模型之间,算力需求差距大得惊人。

根据公开资料,OpenAI的Sora视频生成模型所需的算力,训练和推理的需求分别是GPT-4的4.5倍和近400倍。可以想象,从语言处理到视频生成的转变,算力需求差距之大。而随着各种超级算力场景的出现,算力建设的必要性只会越来越明显。

数据显示,从2010年到2023年,AI的算力需求翻了好几万倍,远远超出了摩尔定律的预期。展望2025年,OpenAI计划推出首个AI Agent产品Operator,这可能会引发超级算力场景的崛起,这对于算力建设的未来至关重要。

目前,大模型的发展被划分为五个阶段:L1是语言能力、L2是逻辑能力、L3是使用工具的能力、L4是自我学习能力、L5是探索科学规律。而Agent正处于L3阶段,并已开始探索L4的自我学习能力。

根据Gartner的预测,到2028年,全球15%的日常工作决策将通过Agentic AI完成。如果大模型的发展如预期般快速推进,从L1到L5,各大AI公司对算力的投入自然会更加重视。

那么,L3阶段的算力需求到底有多大呢?

巴莱克银行在2024年10月的报告中提到,假如到2026年消费者的人工智能应用能突破10亿日活跃用户,且Agent在企业业务中的渗透率超过5%,那所需的算力至少要达到142B ExaFLOPs(约合150万亿P),这样才能生成五千万亿个token。

尽管超级应用的时代还没到来,但在目前这个竞争激烈的大模型赛道上,没有哪家企业愿意掉队。像微软、谷歌、亚马逊、Meta、字节跳动、阿里巴巴、腾讯和百度这些国内外的AI巨头们,恐怕会继续加大投入,以赌未来的成功。

此外,DeepSeek最为人称道的就是它成功绕过了“芯片瓶颈”。

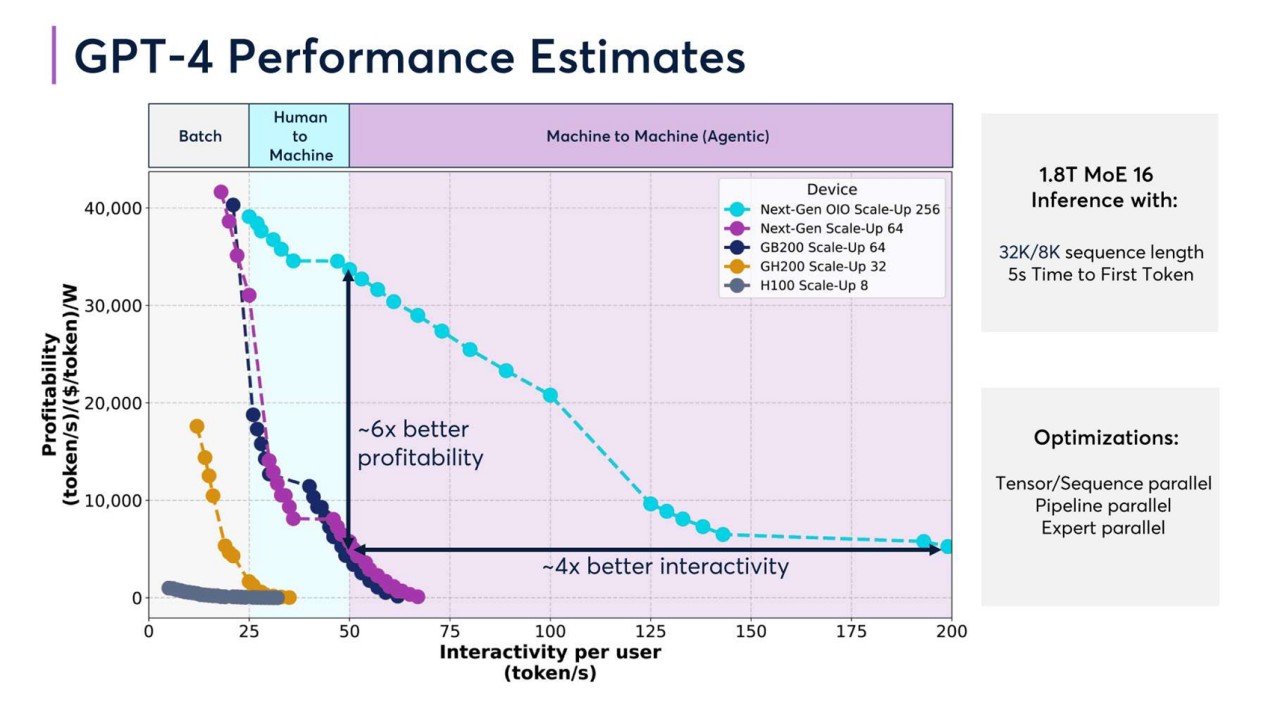

不过,算力产业的基础设施是至关重要的,相同的投入下,优质的基础设施往往能带来更高的算力效率与商业回报。《2025年算力产业十大趋势》指出,以GPT-4为例,不同硬件配置下的性能差异显著。比如,使用GB200 Scale-Up 64配置的盈利能力,是H100 Scale-Up 8配置的6倍。

DeepSeek的服务器频频崩溃,似乎在暗示着大模型赛道的算力争夺战依然没有结束。预计到2025年,英伟达的下一代GPU GB300将会出现多个关键的硬件规格变化,而国内的AI芯片国产化进程也在快速推进。

种种迹象表明,算力的建设依然是个长期的任务,反而愈加激烈。

DeepSeek的成功真是让人惊讶,尤其是它在短时间内用户量激增,说明了市场对新技术的渴求。期待它在大模型技术上的进一步突破!

DeepSeek的崛起确实令人振奋,它在性能和成本上的优势让不少企业看到了新的希望。未来的发展值得持续关注。

DeepSeek的表现确实让人刮目相看,尤其是它在降低成本和提高性能方面的突破,对整个AI行业都是一种激励。期待后续能带来更多创新。

DeepSeek的迅速崛起显示了国产AI技术的潜力,尤其是在降低成本和提升性能方面,给行业带来了新的机遇。值得关注它未来的表现。

DeepSeek的成功不仅在于用户量的激增,更重要的是它在大模型领域的创新和突破,未来的发展方向值得期待。

DeepSeek的崛起真是个惊喜,特别是它在降本增效上的成果,可能会改变整个AI行业的格局。希望它能持续突破,让更多企业受益。

DeepSeek的成功不仅是技术上的突破,更是国产AI崛起的象征。它的降本增效策略让很多小企业看到了希望,未来的发展值得期待。

DeepSeek的表现真是出乎意料,尤其是在用户增长和成本控制方面,给整个行业注入了新的活力。希望它能继续保持这种势头,推动国产AI的发展。

DeepSeek的迅速崛起,展现了国产AI的实力,尤其是在成本控制与性能提升方面,真是行业的游戏规则改变者。期待它带来更多惊喜。

DeepSeek的快速崛起让人刮目相看,尤其是它在参数缩减和算力利用上的创新,可能会彻底改变AI行业的竞争格局。期待它未来的表现!

DeepSeek的成功证明了国产AI的实力,特别是在技术创新和成本控制上,值得期待未来的发展。