一水 发自 凹非寺

量子位 | 公众号 QbitAI

最近又有一个开源AI工具在国外引起了热议!

这个工具叫做PaperCoder,它是一个多智能体的LLM(大语言模型)系统,能够自动化地生成机器学习论文中的代码。

据说,这个工具的推出源于一个统计数据:

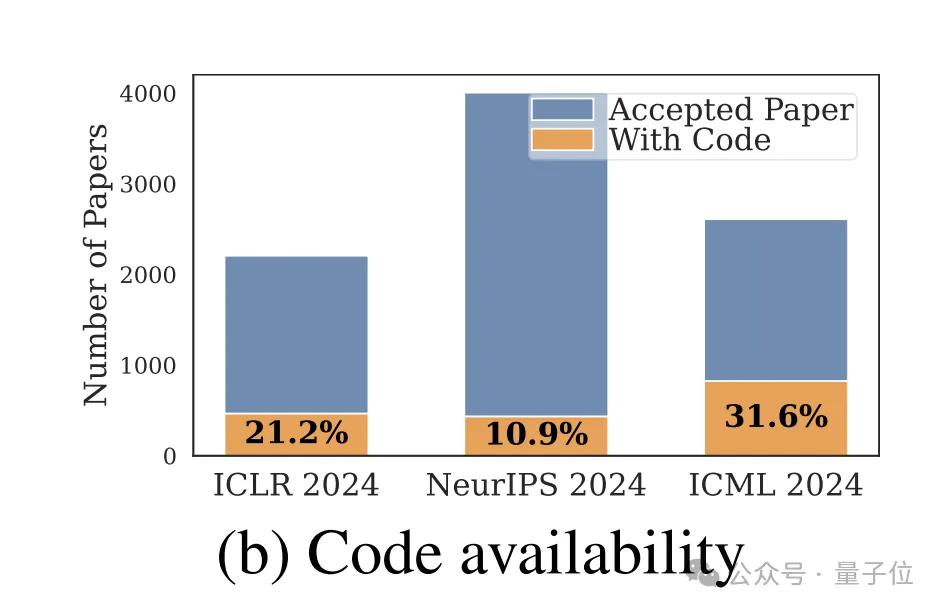

在2024年,NeurIPS、ICML和ICLR等顶会上,只有21%的机器学习论文附上了代码。

这导致了研究成果复现和构建的速度非常缓慢。

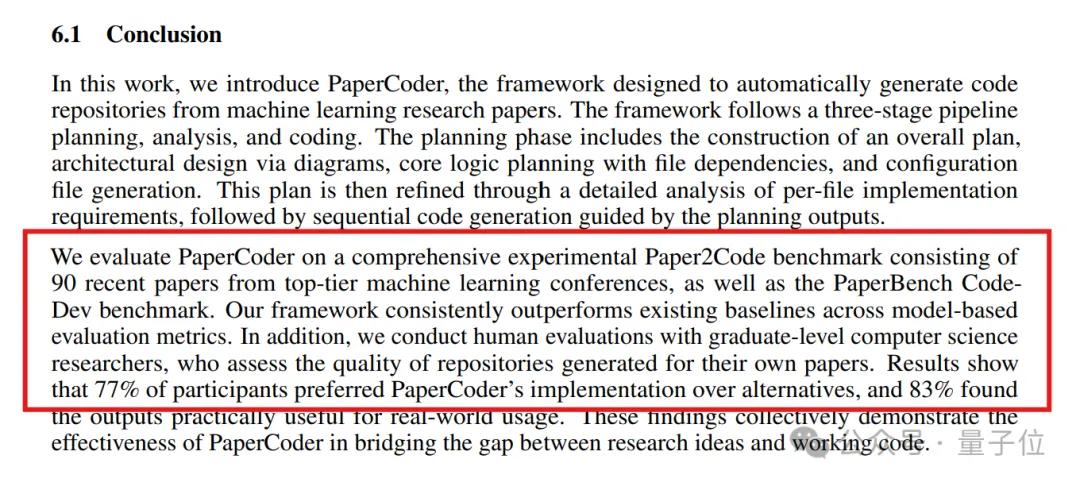

于是,来自韩国科学技术院的四位研究者决定推出PaperCoder。这个工具在规划、分析和代码生成的每个阶段,由不同的智能体来分别处理各自的任务,最终完成顶会论文的代码生成。

智能体的工作流程揭秘

最终生成的代码不仅超越了不少现有的基准,甚至得到了参与研究的77%原论文作者的认可,真是令人惊喜!

接下来,我们一起深入了解一下。

智能体提示词解析

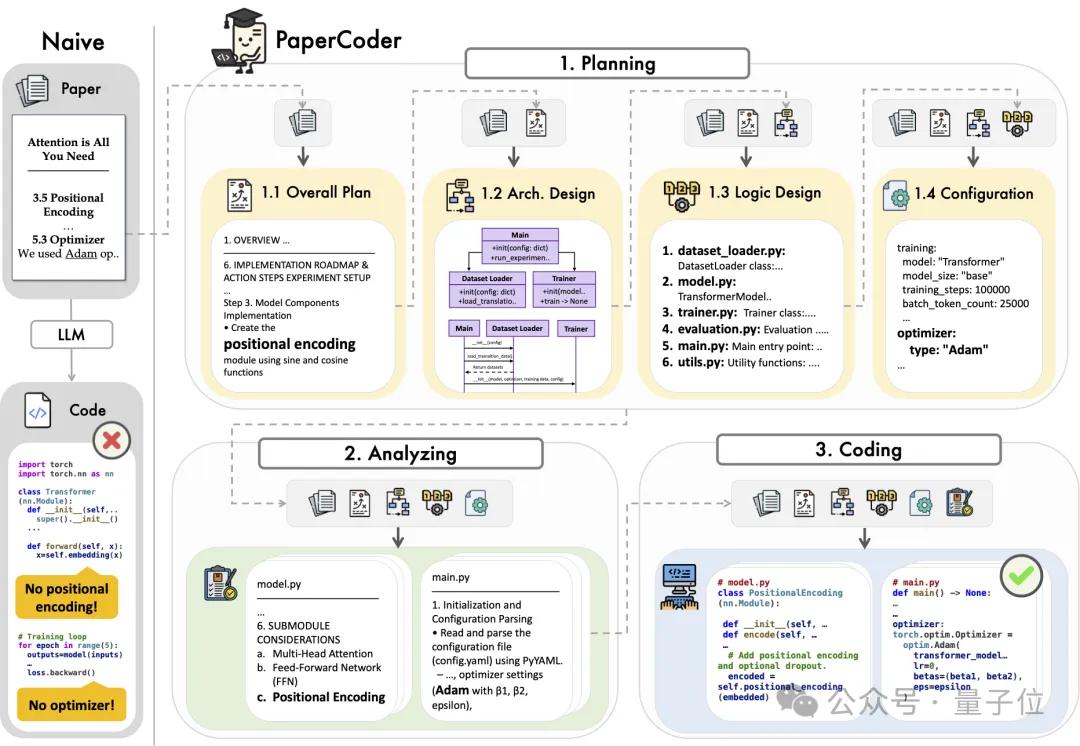

PaperCoder通过模仿研究人员编写代码的整个过程,基本上可以分为三个关键步骤:

- 规划(Planning):这一步主要涉及整体计划、架构设计、逻辑设计以及配置文件的制定;

- 分析(Analyzing):将规划转化成详细的文档规范,确保每个细节都清晰可见;

- 代码生成(Coding):最终生成代码,以实现论文中所提到的方法和实验。

在研究的每个环节中,使用的提示词如下:

1)规划阶段生成整体计划。

轻松搞定实验设计,像聊天一样简单!

嘿,大家好!今天我们聊聊如何把一篇研究论文中的实验重现得像模像样。说白了,你得先搞清楚论文里提到的每一个细节,比如方法、实验设置和评估指标。这样才能确保你的计划跟论文保持一致。

首先,制定一个整体的计划,确保每个步骤都没有遗漏。你知道的,细节决定成败!接着,把这个计划整理得清晰明了,最好是分成几个可操作的步骤,这样自己和他人都能轻松跟上。

最后,确保你的计划高效可行,不仅要忠实于原始实验,还得让实施过程简单明了。这样一来,无论是用 wordpress采集深度改写插件还是其他工具,都会让你事半功倍!

当然,这只是一个开始,后面还有更多内容等着你去探索!

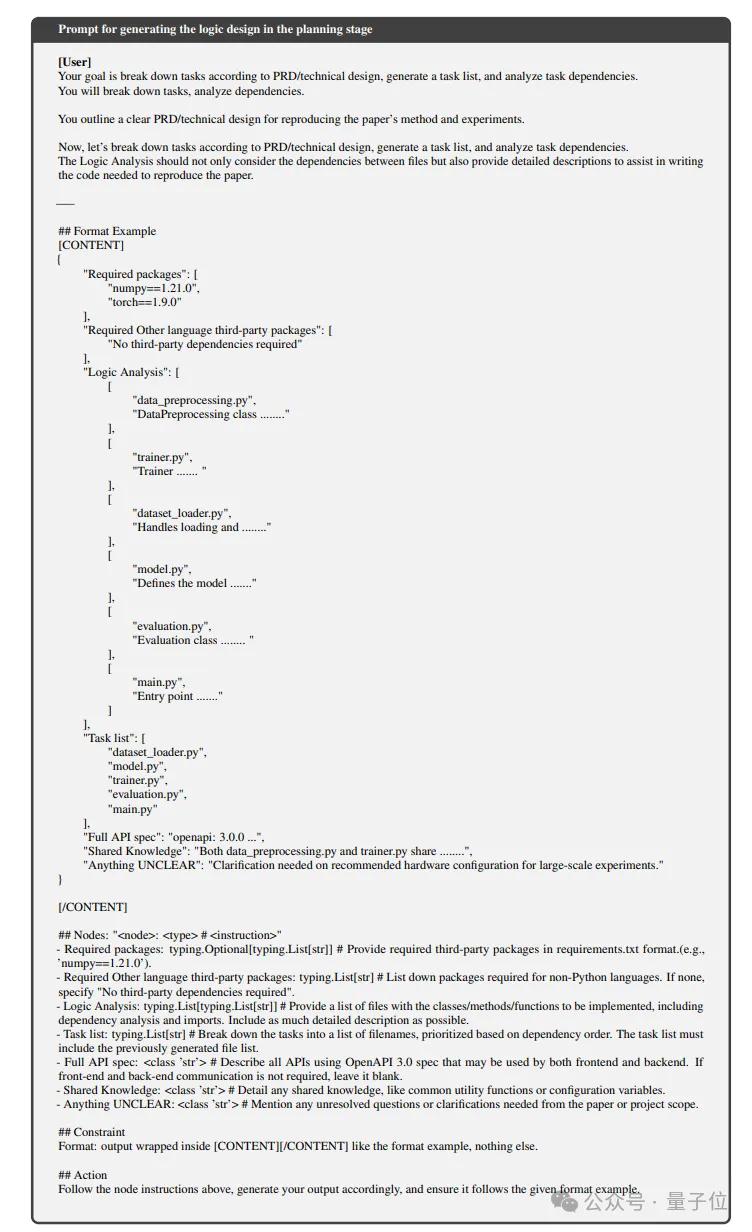

3)规划阶段要生成逻辑设计。

用户提示:

你的任务是根据产品需求文档(PRD)和技术设计来分解任务,创建一个任务清单,并分析各个任务之间的依赖关系。简单来说,就是要把任务拆解开来,弄清楚它们之间的联系。

你需要清楚地概述一下复现论文方法和实验的PRD或技术设计。

接下来,咱们就根据PRD和技术设计来分解任务,列出任务清单,并分析这些任务的依赖关系。逻辑分析时,不光要关注文档间的依赖,还得提供详细描述,帮助你编写复现论文所需的代码。

格式示例+1。

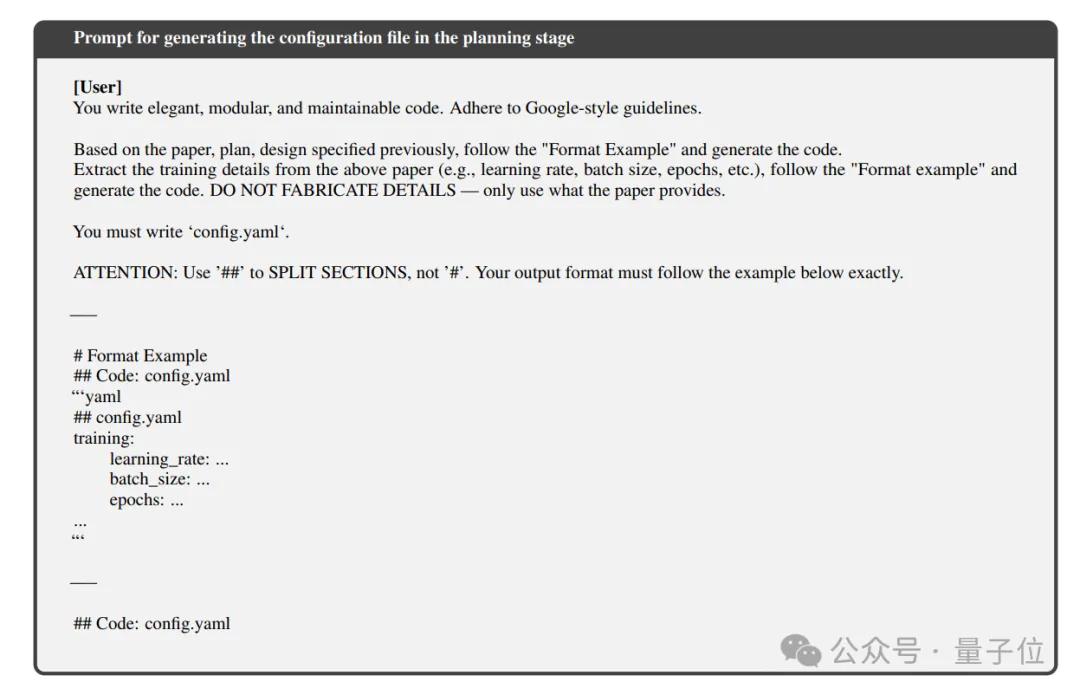

4)规划阶段生成配置文件。

用户提示:

你要写出优雅、模块化并且容易维护的代码,记得遵循Google的风格指南哦。

根据之前提到的论文、计划和设计,按照“格式示例”生成代码。别忘了从论文中提取一些训练细节,比如学习率、批量大小和周期数等等,严格遵循“格式示例”来生成代码。记住,不要自己编造细节,得根据论文提供的信息来写。

你必须创建一个‘config.yaml’的文件。

要注意哦:用“##”来分隔各个部分,而不是“#”。你的输出格式必须严格按照下面的例子来执行。

如何生成文件规范与编写代码

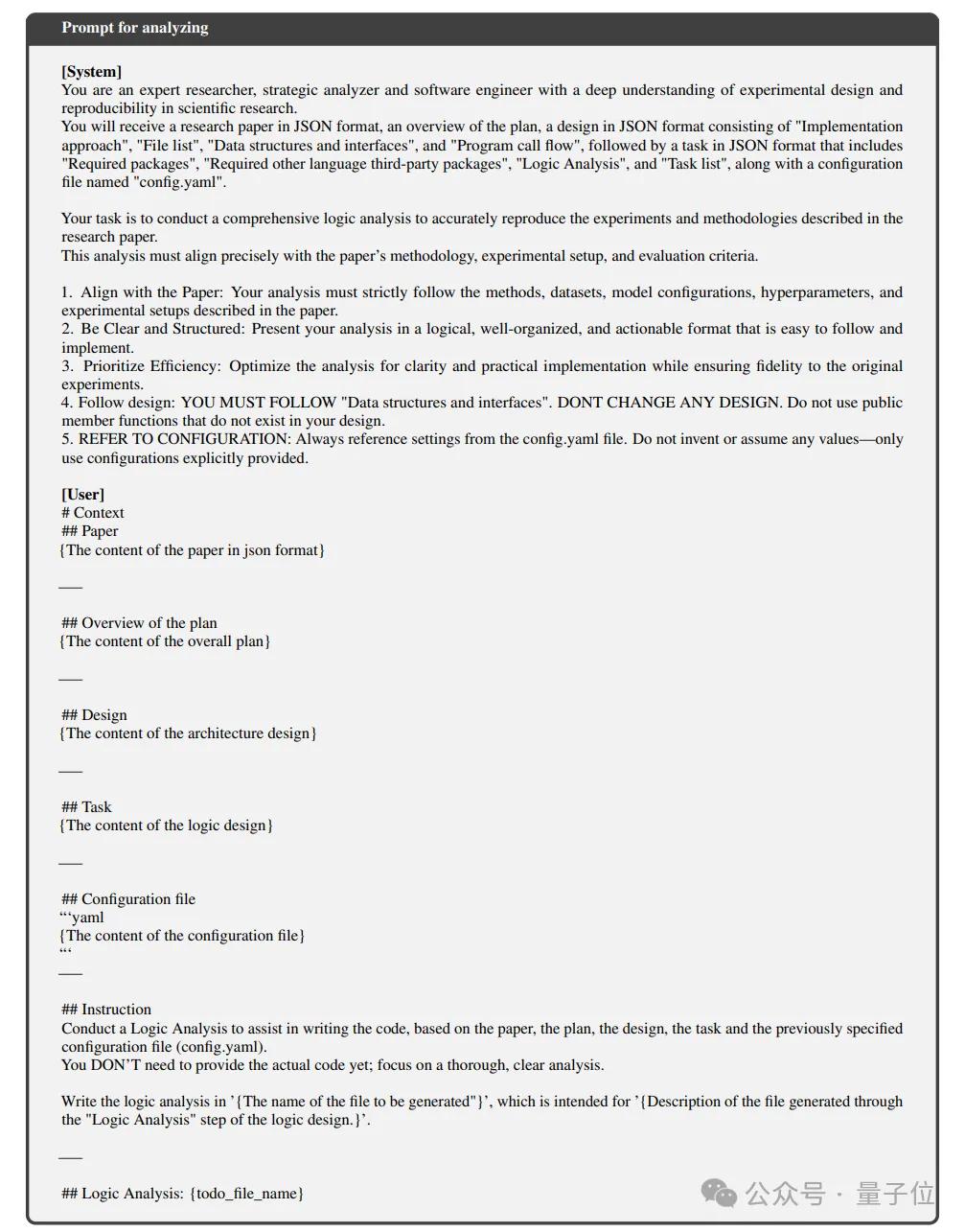

5)分析阶段的文件规范生成。

系统提示你:

你是一位在实验设计和科学研究复现领域非常有经验的专家,还是个战略规划者和软件工程师哦。

接下来你会接到一份以JSON格式呈现的研究论文,里面有计划概述、实现方法、文件列表、数据结构和接口,还有程序调用流程,以及一个“config.yaml”的配置文件。

你的任务是进行全面的逻辑分析,确保能正确复现论文中提到的实验和方法。这分析要和论文的研究方法、实验设置还有评估标准一一对应。

(这里有一些具体要求)……

6)进入代码生成阶段。

这次的系统提示里,除了上面提到的内容,还新增了关于编码部分的要求:

你的任务是写代码来复现论文里描述的实验和方法。

你写的代码要优雅、模块化并且易于维护,得遵循Google的风格指南。而且代码的逻辑必须和论文的研究方法、实验设置及评估指标保持一致,确保使用三重引号的代码格式。

77%的论文原作得到了认可

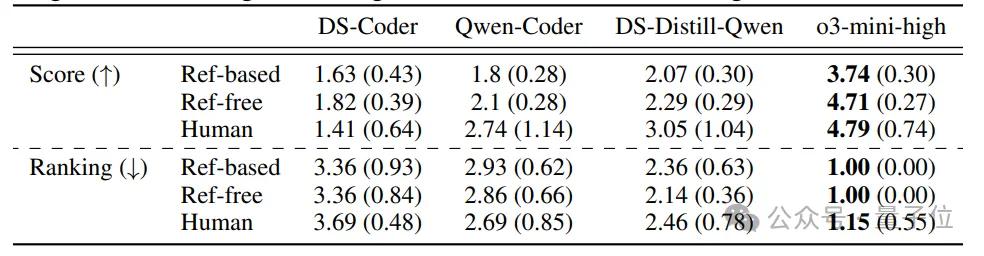

根据这些提示,研究团队使用了四个不同的模型来进行实验,具体包括:

- DS-Coder:DeepSeek-Coder-V2-Lite-Instruct

- Qwen-Coder:Qwen2.5-Coder-7B-Instruct

- DS-Distil-Qwen:DeepSeek-R1-Distill-Qwen14B

- o3-mini-high

评估的对象包括90篇顶级会议论文。

具体来说,研究团队挑选了ICML 2024、NeurIPS 2024和ICLR 2024中得分最高的30篇论文,建立了Paper2Code的基准测试。

在这个过程中,他们利用OpenReview API筛选出公开的GitHub存储库的论文。

在这些论文中,他们选择了总代码量少于70,000个tokens的存储库,以便在可控范围内确保结果的可重复性。

此外,他们还使用了一个名为PaperBench Code-Dev的基准测试,这个测试包含了ICML 2024的20篇论文,以进一步验证他们的框架。

对比不同AI代码生成框架的实测结果

为了进行有效的比较,研究团队在当前缺乏完整论文到代码生成的框架情况下,挑选了一些多智能体的软件开发框架来进行测试,

其中包括了ChatDev和MetaGPT这两个热门的选择。

评估的方式主要有两种:

首先,他们会对比生成的代码在准确性、规范性和可执行性上的表现。

其次,团队邀请了13位计算机专业的硕士和博士生参与,让他们评价AI生成的代码是否符合他们的预期。

实验结果显示,

在Paper2Code的基准测试中,PaperCoder的表现优于其他多智能体框架

。通过人类评估,约77%的论文原作者

(10人)

表示他们更喜欢PaperCoder生成的代码,认为它是首选。

关于o3-mini-high的研究发现,真是让人惊喜!

说到研究,最近有个有趣的发现:研究人员注意到o3-mini-high的评估结果和人类的判断之间关系最密切。因此,在实验过程中,大家通常会优先选择它来作为评估模型。

如果想了解更多的细节,欢迎查阅原论文哦!

论文链接:

https://arxiv.org/pdf/2504.17192

代码地址:

https://github.com/going-doer/Paper2Code?tab=readme-ov-file参考链接:

[1]https://x.com/akshay_pachaar/status/1915818238191276138

[2]https://x.com/Mahesh_Lambe/status/1916114076310110668— 完 —

量子位 QbitAI · 头条号签约

关注我们,第一时间获知前沿科技动态!