说到Vibe coding,现在可是热得一塌糊涂。你知道吗,最近有位技术大佬直接搞出来了当红的AI编程工具Cursor和Windsurf背后的核心算法!

就在今天凌晨,名叫Nir Diamant的高手发布了一篇超级精彩的文章,深入剖析了Cursor和Windsurf的核心算法。就像你玩抖音时需要搞懂它的推荐机制一样,现在在Vibe Coding的我们,当然要快速理解这些编程助手是怎么运作的。这篇文章的细节真是丰富,值得大家收藏好好研究。

市场上有不少AI编程工具,各种Copilot层出不穷,但能真正让开发者会心一笑的,非Cursor和Windsurf莫属。这两款工具的魅力,不仅在于能帮助你编程,更像是一个懂你的合作伙伴,真正理解你在做什么。

那么,这两款工具是如何运作的呢?它们背后又是什么样的算法和系统?废话不多说,我们直接来看干货。

Cursor和Windsurf

如何理解你的代码

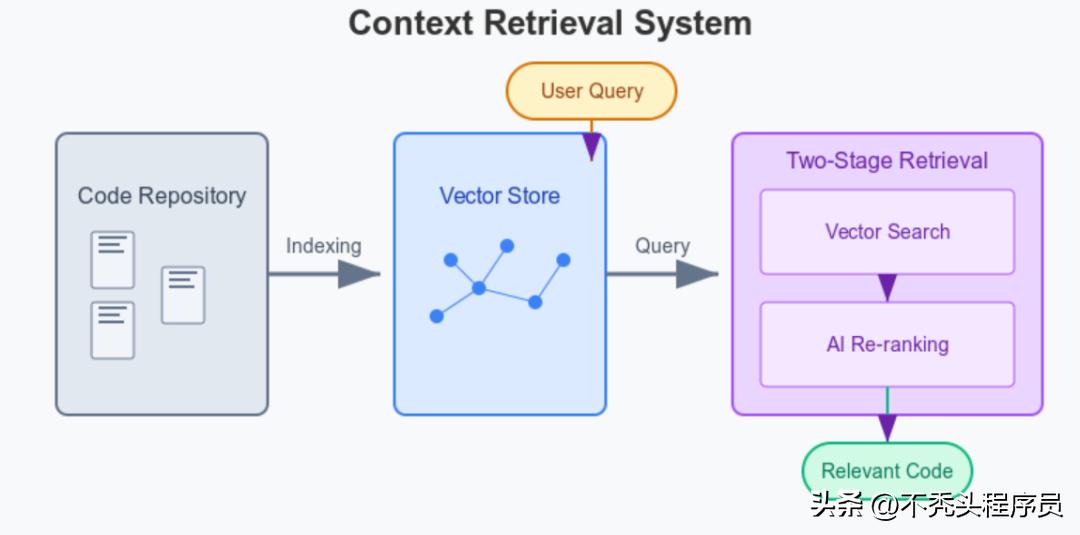

要想让AI编程助手真正发挥作用,它得理解整个代码库和你的意图。Cursor和Windsurf都运用了先进的上下文检索系统,帮助AI“读懂”你的代码。

先来看看Cursor是怎么做的。

- Cursor会把整个项目索引到一个向量数据库中——可以把它想象成一张智能代码地图,把语义相似的代码聚集在一起。

- 在索引过程中,它会使用特定的编码器模型,特别注重注释和文档字符串,以更好地捕捉每个文件的功能和意图。

- 当你提出问题时,它会采取“两阶段检索”的方式:

### 如何利用智能助手优化代码搜索体验

- 首先,向量搜索会帮你找到一些可能相关的代码片段。

- 接下来,AI模型会根据相关性对这些代码片段进行重新排序。就像你去图书馆,先把所有相关书籍找出来,然后再挑选出最适合你的。

这两步检索方式远比传统的关键词搜索有效,特别是对于复杂的代码问题来说。

- 你还可以通过添加 @file 或 @folder 标签来指明特定的文件,类似于在说“麻烦你翻到这几页”。

- 而且,当前打开的文件和光标附近的代码也会自动被纳入考虑范围。

接下来,我们来看看Windsurf的处理方式,其实也很相似。

- Windsurf的索引引擎同样会扫描整个代码库,建立一个可以搜索的代码地图。

- 它使用基于大型语言模型的搜索工具,声称比传统的嵌入式搜索更精准,能更好地理解你的自然语言查询并找到相关的代码片段。

- 在提供建议时,它不仅会考虑当前打开的文件,还会从整个项目中提取相关文件,实现更全面的系统感知。

- 另外,它还提供“上下文固定”功能,让你可以将设计文档等重要信息固定在一个AI随时能看到的地方,方便AI随时参考。

Cursor和Windsurf是如何“思考”的

作者指出,这两款助手的思维方式是通过精心设计的提示和上下文管理策略来引导的。

先来看看Cursor的提示结构。

- 它使用结构化的系统提示,带有 和 等标签来组织不同的信息类型。

- 明确告诉AI应该怎么做,以便塑造它与用户之间的互动方式:

- 尽量避免不必要的道歉,

- 在行动之前先解释原因,

- 不在聊天中直接输出代码,而是使用专用的代码编辑器。

- 使用“上下文学习”技术:在提示中展示正确的工具调用或响应格式,就像用例子帮助新手一样。

至于Windsurf,它的机制有些不同,使用了Cascade Agent,更加综合——

- 结合了AI规则和记忆机制,使得系统更智能。

Windsurf与Cursor:智能助手的高效协作

- Memories可以分为两类:一种是用户自己创建的,比如API说明,另一种是AI自动生成的,这些都是基于之前的互动。这就意味着,Windsurf能够“记住”你项目的变化,而不是每次都要从头开始。

而且,Cursor和Windsurf有一个共同点,那就是它们都能高效管理上下文窗口,也就是一次能处理的文本量。它们会对信息进行压缩,优先保留与当前任务最相关的内容。

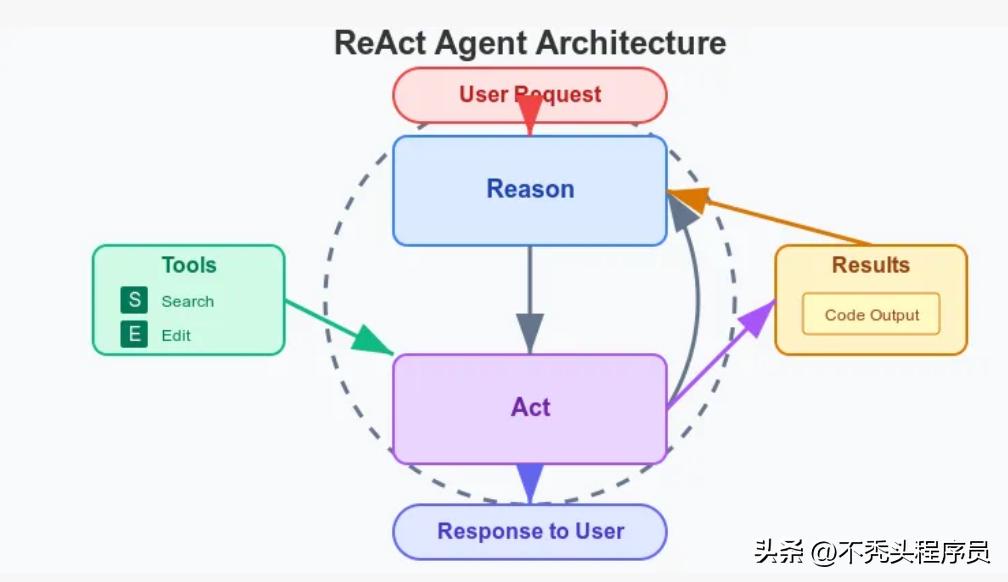

这两者是如何完成任务的呢?

Cursor和Windsurf都采用一种叫做ReAct(推理与执行结合)的模式,把语言模型变成了可以执行多步操作的智能代理。

先来看看Cursor是怎么运作的。

Cursor的代理循环运行的步骤是这样的:AI选择工具→解释意图→调用工具→查看结果→决定下一步。它可以使用的工具包括代码搜索、读取文件、编辑代码、执行shell命令,甚至在线搜索文档。

值得一提的是,Cursor进行了重要的优化——“特种diff语法”:这并不是让AI重写整个文件,而是建议具体的“语义补丁”,然后通过一个独立而快速的模型将这些补丁合并。这种方式既高效又能减少错误。

同时,Cursor还会在沙盒环境中运行实验代码,以确保不会对真实项目造成影响。

比方说,如果你让它“修复认证Bug”,它可能会先搜索相关代码文件,读取这些文件、进行修改,然后执行测试来确认修复是否成功。每一步它都会告诉你发生了什么。而且,它会限制自我修复的循环次数(比如“不超过3次”),以避免陷入死循环。

Cursor还采用了“专家混合机制”:用强大的大模型(如GPT-4或Claude)进行决策推理,而用小模型来执行具体任务,就像一个高级设计师来制定方案,再由专业团队来执行。

再看看Windsurf。Windsurf的Cascade机制也有类似的功能,但它更强调“AI流程”的设计。

生成计划 → 改代码 → 请求用户确认 → 运行代码 → 分析结果 → 提出修复。

当你发出请求时,Cascade会制定执行计划,进行代码修改,征求你的确认后才会执行代码。如果你同意,它还能在集成的AI终端中运行代码,分析结果并提出修复建议。

更厉害的是,Windsurf的代理系统非常强大,它可以在一个流程中串联多达20个工具调用,完全不需要你手动干预。这些工具包括自然语言代码搜索、终端命令、文件编辑,还能连接外部服务的MCP协议。这种能力让Cascade能够一次性完成安装依赖、项目配置和新功能实现等复杂任务。

更令人惊讶的是,如果你在AI执行代码的过程中手动修改了代码,Cascade会立即感知并自动调整所有相关部分,真正实现了你和AI之间的实时协作。

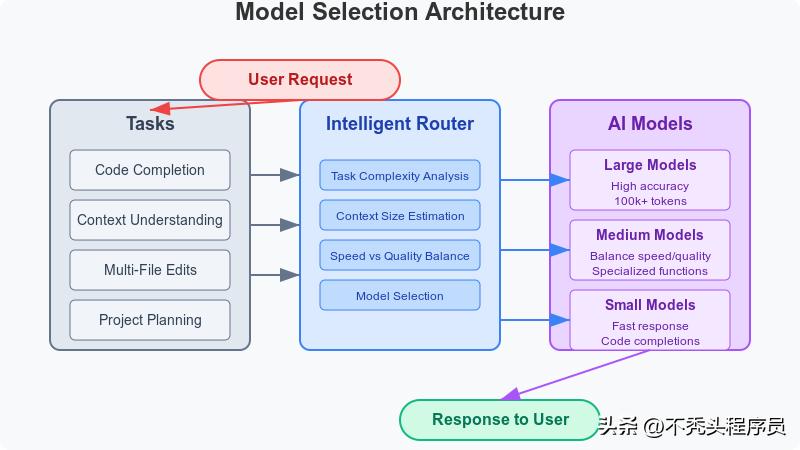

揭秘背后的智能“大脑”与模型架构

智能“大脑”揭秘

模型架构分析

说到这两款强大的AI工具,它们都是利用了多种AI模型来完成不同的任务,努力在速度和结果质量之间找到一个不错的平衡。不过,它们的方法论却相差甚远。

Cursor的模型系统可以概括为:

- 采用了“嵌入-思考-执行”三步走的策略(Embed-Think-Do Agent Loop)。

- 系统会根据需求来选择最适合的模型。

- 比如,利用100k tokens的Claude模型来处理项目的全局信息和复杂推理,这样可以“看得更远”。

- 生成向量嵌入的模型与OpenAI的text-embedding-ada相似。

- 在进行代码补全和编辑时,系统会根据任务的复杂度和用户的设定动态调整模型。

- 最核心的创新点在于:通过智能的动态路由机制,能根据具体场景灵活选择大模型或小模型,优化质量和响应速度的平衡。

至于Windsurf的模型策略,显得更加直接:

- 他们投入了大量资源训练自己专用的代码模型,基于Meta的Llama架构:

- 70B参数的基础模型适合日常任务;

- 而405B参数的高级模型则用来应对复杂挑战。

- 另外,用户可以自由选择GPT-4或Claude等外部模型,实现灵活的架构选择。

- 在模型选择上,小模型负责快速建议,大模型则用来处理大规模的文件修改,确保系统能为每个任务匹配到最合适的“智慧大脑”。

- 通过逐个token的实时反馈,你可以看到代码是如何“被编写”的。

- 如果代码中出现错误,它会自动识别并尝试修复,省去了你手动去改的麻烦。

- 它会追踪你文本光标的位置,帮助你完成代码补全,并预测你可能要修改的地方。

- 后台也在不断更新向量索引,随时确保新写入的代码可以被快速检索,AI 对代码库的理解始终保持最新。

- 同样支持流式输出,让你体验到“沉浸式工作流”。

- 当你修改代码时,Cascade 代理会立刻感知并调整计划。

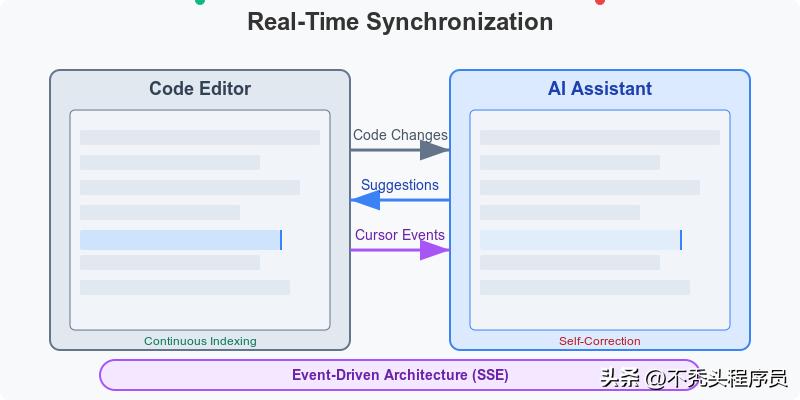

- 它建立在事件驱动的架构之上,保存文件和文本修改会触发 AI 的重新推理。

- 通过SSE(Server-Sent Events)实现编辑器、终端和聊天窗口的实时同步。

- 当你运行代码遇到错误时,AI 能迅速捕捉到错误信息并给出解决方案,完全不需要你手动去复制粘贴。

让你的编程体验更流畅的小秘密

它们如何与你保持同步(Sync机制)

实时同步是提升编程流畅度的关键,得让系统快速适应用户的每一次操作。这两种系统都有着很棒的同步机制。

Cursor 的机制主要是依靠token级别的流式响应:

而Windsurf 则致力于保持“工作流畅感”。

ps:这种设计让 AI 成为一个全神贯注的编程伙伴,时刻关注你的代码并主动配合。

最后,想告诉大家的是,这些内容是作者Diamant通过大量研究总结的关于Cursor和Windsurf这两款AI工具的“核心机制”的理解,当然,随着时间推移,机制中的细节也可能会有所变化。

网友:怪不得!

终于明白Cursor理解能力差的原因了

这篇文章发出去后,很多网友都为Diamant的努力点赞,大家纷纷表示对“大模型”的不足表示理解与包容。

例如,有位网友恍然大悟,了解到Cursor并不是一次性把所有代码都放到内存里,而是通过创建一种“智能地图”(RAG)来处理代码,只有在需要的时候才会调用相关的向量索引。

不过,也有另一位网友对此表示不满,他认为这正是这些编码工具理解能力差的原因所在!

“RAG对于自然语言可能不错,但对于代码就不行。”他还提到自己遇到的一个问题:向量搜索怎么知道util.py是上下文的一部分呢?

他觉得,只有端到端的测试和顶层的UI界面(因为包含自然语言)才应该使用RAG搜索,其他部分则应通过调用图来判断。

而在修复错误和添加新功能时,更有效的方法应该是运行现有的E2E测试,以更准确地识别并应用代码。

所以,搞清楚这些工具背后的核心逻辑,简直就像给开发者打开了一扇新视野,能为这些硅基生命的编程助手提供更好的进化建议。

对正在崛起的Vibe Coding来说,这可是一件大事。虽然现在大家对LLM编程工具的态度比较宽容,但对于这个领域的众多参与者来说,揭示背后的算法机制通常能帮助用户提出更好的改进建议。

昨天小编从一个技术交流群里听到一个朋友的反馈:

Cursor在生成项目代码时速度挺快,一两分钟就搞定了,但运行后错误很多,尤其是语义方面的错误,修复这些bug往往要花很久,经常超过半个小时。

Cursor的代码理解问题:用户的反馈至关重要

说实话,Cursor在理解代码方面确实显得有些力不从心。这种情况可能不是短时间能通过大模型来解决的。有位网友直击要害,指出了问题的根源。

所以,要是Cursor想要真正改善这个“理解不佳”的问题,听取用户的建议可真是个不错的主意!比如,使用RAG来处理代码上下文似乎效果不佳,换成调用图或许能带来更好的结果!