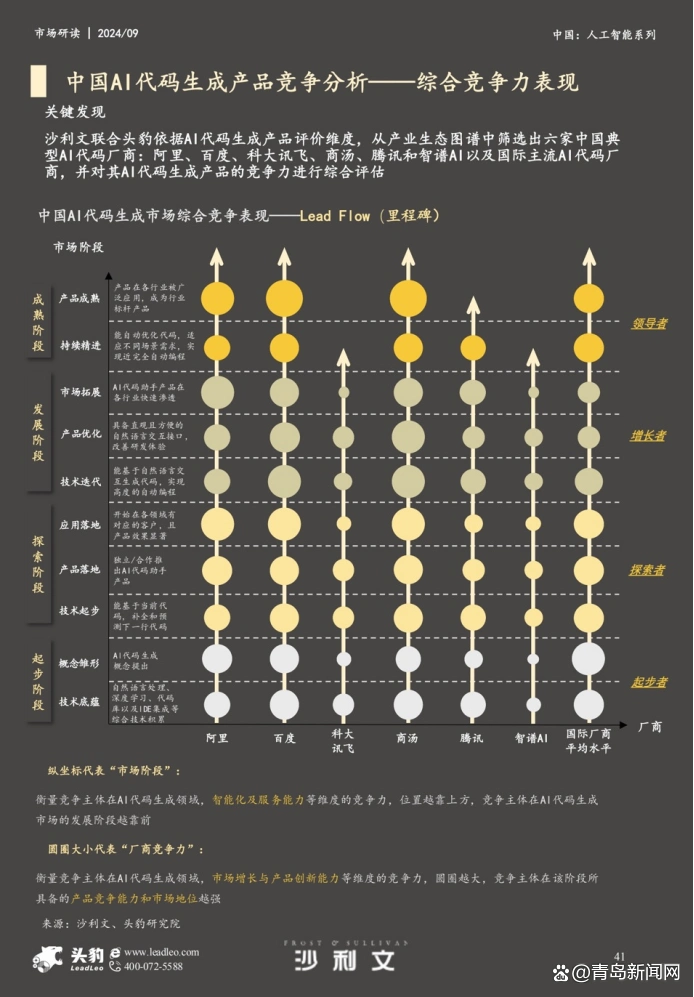

随着人工智能技术迅速发展,不少开发者和企业开始思考如何把这些先进的AI模型应用到实际产品中,以提升智能化水平。最近,百度在其AI技术生态中发布了文心4.0X1Turbo,并基于此推出了文心快码和Comate AI IDE的接入方案。这些创新举措的目标是让开发者享受到更便捷、更高效的AI开发环境,同时也带来了不少挑战。接下来,我们将从当前面临的技术难题出发,分析一些解决方案,并展望未来的发展方向。

一、面临的挑战:技术壁垒与整合难题

1. 模型适配与优化问题

文心4.0X1Turbo是最新一代的AI模型,参数庞大,对计算资源的需求也很高。这就意味着在将模型接入开发环境时,开发者需要考虑不同硬件的兼容性和优化策略。在实际操作中,大家可能会遇到模型加载缓慢、响应时间长等问题,这些都会影响开发效率。

2. 接口集成的复杂性

不同的AI工具和平台之间,接口的定义和调用方式往往不一样。这使得在把文心4.0X1Turbo接入Comate AI IDE或文心快码时,需要定制集成方案,增加了开发的复杂性。同时,确保接口的稳定性和安全性也是个不小的挑战。

3. 资源管理与成本控制

高性能模型的运行需要消耗大量计算资源,尤其是在模型训练和推理阶段,这对硬件配置的要求很高。对于企业和个人开发者来说,如何高效管理资源,避免浪费,同时控制成本,成为一个亟需解决的问题。

4. 用户体验与操作流程

面对复杂的模型参数调整和调试流程,普通开发者常常感到无从下手。如何简化操作流程,设计出友好的用户界面,让不同水平的用户都能轻松使用,也是一个亟待解决的问题。

二、应对策略:技术创新与策略优化

1. 模型优化与硬件适配

为了提高模型加载速度和响应时间,开发者可以尝试模型剪枝、量化等技术来减小模型体积,并提升推理速度。同时,利用高效的硬件加速方案,比如GPU和TPU,也能提高模型的运行效率。动态资源调度技术的逐步成熟,也能根据任务需求灵活分配计算资源。

2. 标准化接口与插件体系

为了解决集成难度,百度推出了标准化的API接口规范,并提供丰富的插件和SDK,以便开发者快速接入文心4.0X1Turbo。这些接口不仅支持多种编程语言,还注重安全性和稳定性,降低了二次开发的难度。同时,完善的文档和示例也能帮助用户更好地理解和使用接口。

3. 资源管理与成本优化

采用云端架构可以将部分计算任务转移到云端,从而有效控制硬件投入和维护成本。利用弹性伸缩机制,可以根据实际需求动态调整资源分配,减少资源浪费。而优化模型运行参数,减少不必要的计算,也有助于降低整体成本。

4. 用户体验提升

设计直观的操作界面和友好的调试工具,可以降低用户的操作门槛。例如,可以提供一键优化模型参数的功能,自动检测模型性能瓶颈并引导用户进行调优。同时,丰富的社区支持和技术交流平台,也能帮助用户快速解决实际问题,提升整体的使用体验。

三、未来发展方向:持续创新与生态构建

1. 深度融合多模态技术

未来的AI模型将不再局限于文本,还会涉及图像、音频、视频等多模态信息。将文心4.0X1Turbo与多模态模型结合,能够实现更丰富的应用场景,比如智能内容生成和多媒体理解等。这不仅增强了模型的适应性,也为开发者提供了更广阔的创新空间。

2. 智能化开发工具链

随着AI技术的不断进步,开发环境将越来越智能化。自动化的模型调优、代码生成和性能检测等功能,将逐步集成到AI IDE中,减轻开发者的负担。而支持云端协作和版本管理,将推动团队合作的高效进行。

3. 行业应用的深入探索

虽然当前主要面向开发者和研究人员,但未来AI模型将在教育、金融、制造等多个行业获得更广泛的应用。通过针对行业的定制化模型和工具,满足不同场景的实际需求,推动行业的数字化转型。

4. 生态体系的完善

建立一个开放、互通的AI生态系统,是推动技术普及和创新的关键。通过合作伙伴关系、开源项目和技术标准的制定,形成多样化的生态体系,为开发者提供丰富的资源和支持。

综上所述,尽管百度文心快码和Comate AI IDE接入文心4.0X1Turbo的方案面临不少技术挑战,但通过对模型的优化、接口的标准化、资源的管理和用户体验的提升等策略,已经取得了显著进展。随着技术的不断演进和生态的逐步完善,未来将为AI开发者带来更便捷、更高效的工具,也为行业的创新奠定坚实基础。人工智能的发展,正推动着我们的数字世界向着更智能、更高效的方向迈进。